FAQ Kode Penghapusan Penyimpanan Ceph

Baru-baru ini, seorang pelanggan mengajukan beberapa pertanyaan tentang bagaimana penyimpanan Ceph memanfaatkan Erasure Code untuk melindungi data, menghindari kerusakan data dalam kasus kegagalan perangkat keras, waktu pemulihan data, bagaimana cara memilih K+M, dan jumlah minimum server yang diperlukan untuk Ceph. Kami percaya bahwa banyak profesional TI yang akrab dengan sistem penyimpanan tradisional akan tertarik untuk memahami fitur dari generasi baru penyimpanan yang ditentukan oleh perangkat lunak. Saya akan membagikan kepada Anda beberapa pertanyaan yang sering diajukan oleh pelanggan dalam artikel ini.

Berapa lama Ceph akan memulihkan diri dari kegagalan disk Ceph?

Waktu yang diperlukan untuk memulihkan data dari kegagalan perangkat penyimpanan tergantung pada kondisi berikut:

- Waktu untuk memulihkan data tidak terkait dengan ukuran hard disk. Waktu tersebut sebanding dengan jumlah data yang disimpan di disk. Ceph hanya perlu memulihkan data yang rusak. Semakin sedikit data yang rusak, semakin cepat perbaikannya. Ceph tidak membangun kembali disk seperti pengontrol RAID.

- Ceph menyembuhkan kembali data ke disk yang sehat di kluster. Semakin banyak disk dan host di kluster, semakin cepat pemulihannya.

- Kecepatan pemulihan dapat disesuaikan dengan parameter perangkat lunak. Semakin tinggi kecepatan pemulihan yang diatur, semakin cepat pemulihannya. Mempercepat pemulihan akan menghabiskan lebih banyak sumber daya perangkat keras CPU dan jaringan.

- Kinerja CPU dan bandwidth jaringan juga akan mempengaruhi kecepatan pemulihan.

- Kecepatan pemulihan dari pool yang direplikasi akan lebih cepat daripada pool kode penghapusan.

- Umumnya, administrator dapat memperlambat kecepatan pemulihan untuk mengurangi penggunaan sumber daya server.

Waktu referensi untuk pemulihan:

- NVMe SSD bisa memakan waktu beberapa jam.

- HDD bisa memakan waktu sekitar satu hari.

Bagaimana cara memilih angka K & M untuk Kode Penghapusan?

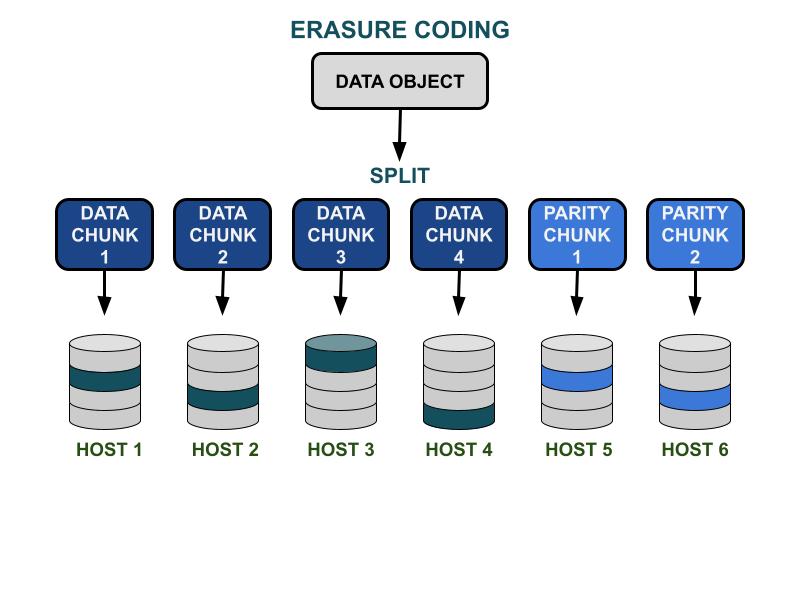

Bagaimana kode penghapusan bekerja.

Parameter kode penghapusan Ceph K & M melibatkan efisiensi kapasitas yang dapat digunakan dan redundansi terhadap kegagalan perangkat keras. K adalah jumlah potongan data, dan M adalah jumlah potongan kode. Ketika seorang klien menulis objek data ke cluster penyimpanan Ceph, objek data tersebut akan dibagi menjadi K potongan data yang berukuran sama. Ceph menggunakan potongan data untuk mengkodekan M potongan kode, yang akan digunakan untuk menghitung potongan data yang hilang ketika perangkat keras gagal. Potongan data dan potongan kode akan didistribusikan dan disimpan di domain kegagalan yang ditentukan oleh K+M. Jumlah maksimum potongan data yang dapat hilang adalah M domain kegagalan. Domain kegagalan yang tersedia tergantung pada bagaimana server penyimpanan dialokasikan dalam infrastruktur fisik. Untuk kluster Ceph skala kecil, kegagalan bisa terjadi pada disk atau host server. Domain kegagalan kluster skala lebih besar dapat mencakup rak server, ruang server, atau pusat data, antara lain. Objek data direkonstruksi dari potongan data ketika klien ingin membaca data tersebut.

Kinerja penyimpanan

Dibandingkan dengan algoritma replikasi data Ceph, pengkodean penghapusan biasanya memiliki efisiensi ruang yang dapat digunakan yang lebih baik. Karena kode penghapusan menggunakan lebih banyak operasi I/O disk untuk menyelesaikan I/O data, ini kurang ramah terhadap beban kerja yang membutuhkan IOPS. Semakin besar jumlah K dan M, semakin banyak operasi I/O yang akan mengkonsumsi sumber daya IOPS disk. Saat menggunakan K yang lebih besar dan M yang lebih kecil, total jumlah byte data yang ditransfer di jaringan cluster Ceph akan lebih sedikit. Ini dapat meningkatkan kinerja throughput I/O dari objek data berukuran besar.

Efisiensi ruang

Efisiensi ruang yang dapat digunakan dari kumpulan kode penghapusan sama dengan K/(K+M).Sebagai contoh, efisiensi ruang dari kumpulan kode penghapusan K=4, M=2 adalah 4/6 = 66,7%.Ini dua kali lebih efisien dibandingkan dengan kolam replika 3, yang memberikan kinerja IOPS lebih tinggi dengan tingkat redundansi perangkat keras yang sama.

K yang wajar lebih besar dari M karena efisiensi ruang yang dapat digunakan.Kode penghapusan (K-M) yang lebih besar mendapatkan efisiensi ruang yang lebih baik.

Jumlah host server

Jumlah K+M juga menentukan jumlah host atau domain kegagalan yang lebih besar yang diperlukan dalam kluster.

- Kolam kode penghapusan standar memerlukan setidaknya K + M host server untuk secara efektif mendistribusikan semua potongan EC.

- Konfigurasi kode penghapusan yang canggih memungkinkan penyimpanan beberapa potongan EC per domain kegagalan. Konfigurasi ini mengurangi jumlah server yang diperlukan untuk mendistribusikan potongan EC.

Ringkasan pengaruh kode penghapusan K & M:

- M menentukan jumlah domain kegagalan yang redundan.

- K + M yang lebih besar mengakibatkan penurunan kinerja IOPS objek kecil untuk klien tetapi meningkatkan throughput untuk objek yang lebih besar.

- Efisiensi ruang penyimpanan = K/(K+M)

- Jumlah minimum server yang diperlukan.

Berapa jumlah minimum host Ceph OSD yang diperlukan untuk menggunakan kolam kode penghapusan?

Praktik terbaik dalam menggunakan penyimpanan Ceph adalah mengatur domain kegagalan pool lebih besar dari "host". Sebuah pool data yang menggunakan host sebagai domain kegagalan menginstruksikan Ceph untuk menulis chunk secara terdistribusi ke host yang berbeda untuk memastikan data dapat dipulihkan untuk chunk lain yang disimpan di host sehat lainnya. Pengguna masih dapat mengonfigurasi domain kegagalan ke "disk drive," yang melindungi data secara khusus terhadap kegagalan disk, mirip dengan array disk tradisional.

Berikut adalah rekomendasi untuk jumlah minimum host yang diperlukan untuk menggunakan kumpulan kode penghapusan.

Konfigurasi terbaik: Jumlah server ≧ K + M +1

- Konfigurasi ini memungkinkan Ceph untuk mendistribusikan setiap chunk EC di antara K+M host.

- Ketika salah satu host gagal, Anda memiliki cukup host untuk memulihkan chunk yang hilang.

Konfigurasi kedua terbaik: Jumlah server = K + M

- Konfigurasi ini memungkinkan setiap chunk EC didistribusikan di antara K+M host.

- Ketika sebuah host gagal, Anda tidak memiliki host lain untuk memulihkan chunk EC yang hilang. Sangat penting untuk memperbaikinya dengan cepat agar sistem dapat kembali ke keadaan sehat secepat mungkin.

Konfigurasi terbatas anggaran: Jumlah server ≧ (K + M) / M

Konfigurasi ini menginstruksikan Ceph untuk mendistribusikan beberapa potongan yang telah dikodekan ke seluruh jumlah host yang ditentukan.Ketika sebuah host gagal, paling banyak M potongan dari sebuah objek akan hilang.

Konfigurasi ini memungkinkan

- Sejumlah disk dapat gagal secara bersamaan di satu host.

- Atau cluster dapat kehilangan paling banyak satu host.

- Atau hanya satu disk di masing-masing dari M host yang dapat gagal secara bersamaan.

Untuk contoh K+M = 4+2, jumlah minimum host yang dibutuhkan adalah 6/2 = 3. Anda hanya dapat kehilangan satu host, tetapi Anda tidak akan memiliki cukup host sehat di cluster untuk memulihkan potongan yang hilang.

Bagaimana cara menghitung kapasitas yang dapat digunakan dari cluster Ceph?

Ruang yang dapat digunakan di Ceph tergantung pada beberapa faktor penting.

1.Kapasitas mentah maksimum dari kluster Ceph yang dibangun oleh beberapa server adalah jumlah ruang disk di setiap server.

Jika kluster mencakup berbagai jenis perangkat penyimpanan, seperti HDD, SSD, atau drive NVMe, Anda harus menghitung total ruang disk mentah untuk setiap jenis perangkat secara terpisah.Ceph mampu mengenali kelas perangkat yang ditentukan yang digunakan oleh setiap pool.

2. Perlindungan data yang diterapkan pada setiap pool Ceph menentukan ruang yang dapat digunakan.

- Perlindungan terduplikasi: ruang yang dapat digunakan = kapasitas mentah/ukuran replika

- Perlindungan data Kode Penghapusan: ruang yang dapat digunakan = kapasitas mentah x (K/(K+M))

3. Ceph memiliki beberapa overhead untuk metadata dan operasi sistem. Ruang overhead yang digunakan sekitar 10 hingga 20% tergantung pada konfigurasi dan penggunaan spesifik Anda.

Semua ruang drive disk dibagikan di antara semua pool terduplikasi dan kode penghapusan

- Pool dapat menetapkan atau tidak menetapkan kuota. Semua kuota adalah penyediaan tipis

- Karena ruang yang tersedia di Ceph adalah penyediaan tipis, ruang penyimpanan hanya dialokasikan saat dibutuhkan, bukan mengalokasikan semua ruang yang diperlukan di muka. Ini dapat meningkatkan pemanfaatan penyimpanan dan mengurangi biaya penyimpanan.

- Disarankan untuk menyisihkan 1/n ruang selama operasi sebagai ruang pemulihan data jika terjadi kegagalan perangkat keras, di mana n adalah jumlah server.

- Sistem memiliki peringatan penggunaan yang telah ditetapkan sebesar 85% hampir penuh dan 95% penuh.