Часто задаваемые вопросы по кодированию стирания в Ceph Storage

Недавно клиент задал несколько вопросов о том, как хранилище Ceph использует кодирование с удалением для защиты данных, предотвращения их повреждения в случае сбоя оборудования, времени восстановления данных, как выбрать K+M и минимальное количество серверов, необходимых для Ceph. Мы считаем, что многие IT-специалисты, знакомые с традиционными системами хранения, будут заинтересованы в понимании особенностей нового поколения программно-определяемого хранения. В этой статье я поделюсь с вами несколькими вопросами, которые клиенты часто задают.

Сколько времени потребуется Ceph для восстановления после сбоя диска Ceph?

Время, необходимое для восстановления данных после сбоя устройства хранения, зависит от следующих условий:

- Время восстановления данных не зависит от размера жесткого диска. Время пропорционально объему данных, хранящихся на диске. Ceph нужно только восстановить поврежденные данные. Чем меньше поврежденных данных, тем быстрее ремонт. Ceph не восстанавливает диск, как контроллер RAID.

- Ceph восстанавливает данные на здоровые диски в кластере. Чем больше дисков и хостов в кластере, тем быстрее восстановление.

- Скорость восстановления можно регулировать с помощью программных параметров. Чем выше установлена скорость восстановления, тем быстрее происходит восстановление. Ускорение восстановления будет занимать больше ресурсов ЦП и сетевого оборудования.

- Производительность ЦП и пропускная способность сети также будут влиять на скорость восстановления.

- Скорость восстановления реплицированного пула будет быстрее, чем у пула с кодом стирания.

- Как правило, администраторы могут замедлить скорость восстановления, чтобы уменьшить использование ресурсов сервера.

Справочное время для восстановления:

- NVMe SSD может занять несколько часов.

- HDD может занять около одного дня.

Как выбрать числа K и M для кода стирания?

Как работает код стирания.

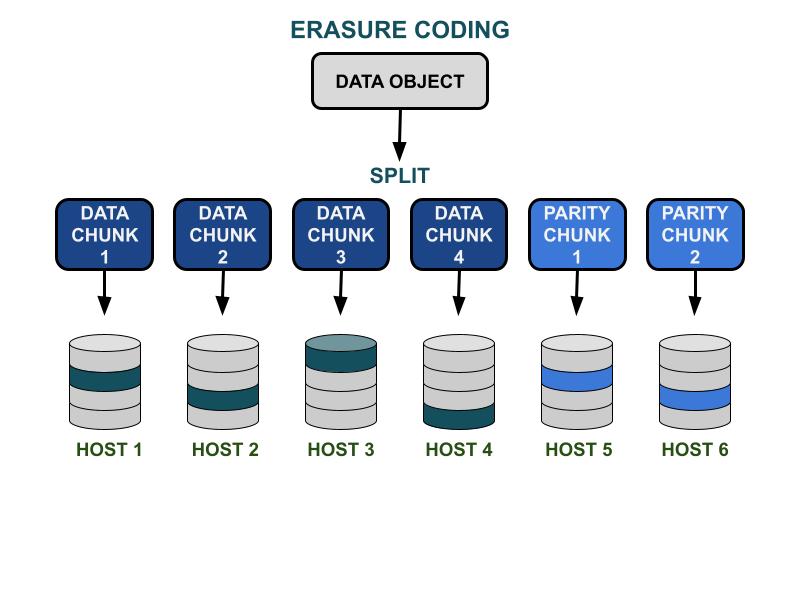

Параметры кодирования стирания Ceph K и M связаны с эффективностью используемой емкости и избыточностью в случае аппаратного сбоя. K - это количество частей данных, а M - это количество частей кода. Когда клиент записывает объект данных в кластер хранения Ceph, объект данных будет разделен на K равных по размеру частей данных. Ceph использует данные чанки для кодирования M чанков кодирующих чанков, которые будут использоваться для расчета потерянных данных чанков при сбое оборудования. Части данных и части кода будут распределены и сохранены в указанной области отказа K+M. Максимальное количество потерянных фрагментов данных составляет M зон отказа. Доступные области отказа зависят от того, как серверы хранения распределены в физической инфраструктуре. Для небольшого кластера Ceph сбой может произойти на диске или сервере. Область отказа кластера большего масштаба может включать серверные стойки, серверные комнаты или центры обработки данных, среди прочего. Объект данных восстанавливается из частей данных, когда клиент хочет прочитать данные.

Производительность хранения

По сравнению с алгоритмом репликации данных Ceph, кодирование с удалением обычно имеет лучшую эффективность использования пространства. Поскольку код стирания использует больше операций ввода-вывода на диске для завершения ввода-вывода данных, он менее удобен для рабочих нагрузок, требующих высокой производительности ввода-вывода. Чем больше сумма K и M, тем больше операций ввода-вывода будет потреблять ресурсы IOPS диска. При использовании большего K и меньшего M общее количество переданных байтов данных в сети кластера Ceph будет меньше. Это может увеличить производительность ввода-вывода для объектов больших размеров.

Эффективность использования пространства

Эффективность используемого пространства пула кодов стирания равна K/(K+M).Например, эффективность использования пространства пула кодов стирания K=4, M=2 составляет 4/6 = 66,7%.Это вдвое эффективнее, чем пулы с репликой 3, которые обеспечивают более высокую производительность IOPS при том же уровне аппаратной избыточности.

Разумное K больше, чем M, из-за эффективности используемого пространства.Более крупный код стирания (K-M) обеспечивает лучшую эффективность использования пространства.

Количество серверов-хостов

Количество K+M также определяет количество хостов или более крупных доменов отказа, необходимых в кластере.

- Стандартный пул кодов стирания требует как минимум K + M серверов-хостов для эффективного распределения всех частей EC.

- Расширенная конфигурация кодов стирания позволяет хранить несколько частей EC на домен отказа. Эта конфигурация уменьшает необходимое количество серверов для распределения частей EC.

Резюме влияния кодов стирания K & M:

- M определяет избыточное количество доменов отказа.

- Большее значение K + M приводит к снижению производительности IOPS для небольших объектов, но улучшает пропускную способность для больших объектов.

- Эффективность использования дискового пространства = K/(K+M)

- Минимальное количество необходимых серверов.

Какое минимальное количество хостов Ceph OSD необходимо для использования пула кодов стирания?

Лучшей практикой использования хранилища Ceph является установка домена отказа пула больше, чем «хост». Пул данных, использующий хост в качестве домена отказа, инструктирует Ceph записывать фрагменты распределенно на разные хосты, чтобы обеспечить возможность восстановления данных для других фрагментов, сохраненных на других здоровых хостах. Пользователи все еще могут настроить домен отказа на «жесткий диск», что защищает данные конкретно от сбоев диска, аналогично традиционным дисковым массивам.

Вот рекомендации по минимальному количеству хостов, необходимых для использования пула кодов стирания.

Лучшая конфигурация: Количество серверов ≧ K + M +1

- Эта конфигурация позволяет Ceph распределять каждый EC-кусок по K+M хостам.

- Когда один из хостов выходит из строя, у вас достаточно хостов для восстановления потерянного куска.

Вторая лучшая конфигурация: Количество серверов = K + M

- Эта конфигурация позволяет распределять каждый EC-чанк по K+M хостам.

- Когда хост выходит из строя, у вас нет другого хоста для восстановления потерянного EC-чанка. Крайне важно быстро его восстановить, чтобы как можно скорее вернуть систему в здоровое состояние.

Конфигурация с ограниченным бюджетом: Количество серверов ≧ (K + M) / M

Эта конфигурация инструктирует Ceph распределять несколько кодированных поэтапно фрагментов по заданному количеству хостов.Когда хост выходит из строя, будет потеряно не более M частей объекта.

Эта конфигурация позволяет

- Любое количество дисков может выйти из строя одновременно на одном хосте.

- Или кластер может потерять максимум один хост.

- Или только один диск в каждом из M хостов может выйти из строя одновременно.

Для примера K+M = 4+2 минимальное количество необходимых хостов составляет 6/2 = 3. Вы можете потерять только один хост, но у вас не будет достаточно здоровых хостов в кластере, чтобы восстановить потерянные части.

Как рассчитать полезную емкость кластера Ceph?

Полезное пространство в Ceph зависит от нескольких важных факторов.

1.Максимальная сырьевая емкость кластера Ceph, построенного из нескольких серверов, равна сумме дискового пространства на каждом сервере.

Если кластер включает различные типы устройств хранения, такие как HDD, SSD или NVMe-диски, вам следует рассчитать общее сырьевое дисковое пространство для каждого типа устройства отдельно.Ceph способен распознавать назначенный класс устройств, используемый каждым пулом.

2. Защита данных, применяемая к каждому пулу Ceph, определяет доступное пространство.

- Защита с репликацией: доступное пространство = сырой объем/размер реплики

- Защита данных с помощью кода стирания: доступное пространство = сырой объем x (K/(K+M))

3. Ceph имеет некоторые накладные расходы на метаданные и системные операции. Используемое пространство накладных расходов составляет около 10-20% в зависимости от вашей конкретной конфигурации и использования.

Все пространство дисков делится между всеми пулами с репликацией и кодом стирания

- Пулы могут устанавливать или не устанавливать квоты. Все квоты являются тонким распределением.

- Поскольку доступное пространство Ceph является тонким распределением, пространство для хранения выделяется только по мере необходимости, а не выделяется все необходимое пространство заранее. Это может улучшить использование хранилища и снизить затраты на хранение.

- Рекомендуется резервировать 1/n пространства во время работы в качестве пространства для восстановления данных в случае сбоя оборудования, где n - это количество серверов.

- Система имеет предустановленные предупреждения о использовании: 85% - почти заполнено и 95% - заполнено.