FAQ dotyczące kodu usuwania pamięci Ceph

Ostatnio klient zadał kilka pytań dotyczących tego, jak pamięć masowa Ceph wykorzystuje kodowanie erasure do ochrony danych, unikania uszkodzenia danych w przypadku awarii sprzętu, czasu odzyskiwania danych, jak wybrać K+M oraz minimalnej liczby serwerów wymaganych dla Ceph. Wierzymy, że wielu specjalistów IT zaznajomionych z tradycyjnymi systemami przechowywania będzie zainteresowanych zrozumieniem cech nowej generacji pamięci masowej definiowanej programowo. W tym artykule podzielę się z tobą kilkoma pytaniami, które klienci często zadają.

Jak długo zajmie Ceph odzyskanie po awarii dysku Ceph?

Czas potrzebny na odzyskanie danych z awarii urządzenia magazynującego zależy od następujących warunków:

- Czas na odzyskanie danych nie jest związany z rozmiarem dysku twardego. Czas jest proporcjonalny do ilości danych przechowywanych na dysku. Ceph potrzebuje tylko przywrócić uszkodzone dane. Im mniej danych uszkodzonych, tym szybsza naprawa. Ceph nie odbudowuje dysku jak kontroler RAID.

- Ceph ponownie przywraca dane do zdrowych dysków w klastrze. Im więcej dysków i hostów w klastrze, tym szybsza odbudowa.

- Szybkość odbudowy można dostosować za pomocą parametrów oprogramowania. Im wyższa ustawiona szybkość odbudowy, tym szybsza odbudowa. Przyspieszenie odbudowy zajmie więcej zasobów sprzętowych CPU i sieci.

- Wydajność CPU i przepustowość sieci również wpłyną na szybkość odbudowy.

- Szybkość odbudowy replikowanego zbioru będzie szybsza niż w przypadku zbioru kodu erasure.

- Ogólnie rzecz biorąc, administratorzy mogą spowolnić szybkość odbudowy, aby zmniejszyć wykorzystanie zasobów serwera.

Czas odniesienia do odbudowy:

- Dyski NVMe SSD mogą zająć kilka godzin.

- Dyski HDD mogą zająć około jednego dnia.

Jak wybrać liczby K i M dla kodu erasure?

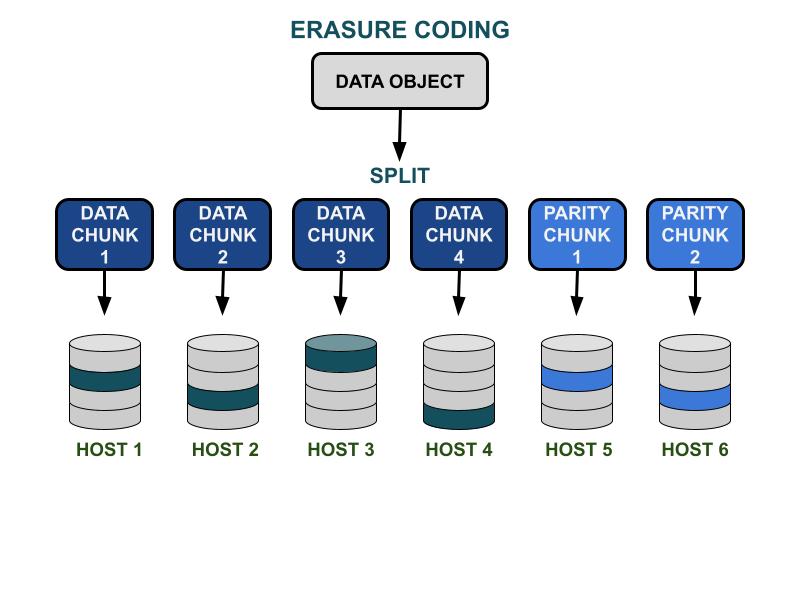

Jak działa kod erasure.

Parametry kodu erasure Ceph K i M dotyczą efektywności pojemności użytecznej oraz redundancji w przypadku awarii sprzętu. K to liczba kawałków danych, a M to liczba kawałków kodu. Gdy klient zapisuje obiekt danych w klastrze pamięci Ceph, obiekt danych zostanie podzielony na K równych części danych. Ceph używa fragmentów danych do kodowania M fragmentów kodujących, które będą używane do obliczenia utraconych fragmentów danych, gdy wystąpi awaria sprzętu. Fragmenty danych i fragmenty kodu będą dystrybuowane i przechowywane w określonej przez K+M strefie awarii. M obszarów awarii to maksymalna liczba fragmentów danych, które mogą zostać utracone. Dostępne obszary awarii zależą od tego, jak serwery pamięci masowej są przydzielane w ramach infrastruktury fizycznej. W przypadku małej klastra Ceph, awaria może wystąpić na dysku lub serwerze. Domena awarii klastra o większej skali może obejmować szafy serwerowe, pomieszczenia serwerowe lub centra danych, między innymi. Obiekt danych jest rekonstruowany z fragmentów danych, gdy klient chce odczytać dane.

Wydajność przechowywania

W porównaniu do algorytmu replikacji danych Ceph, kodowanie erasure zazwyczaj ma lepszą efektywność wykorzystania przestrzeni. Ponieważ kod kasowania wykorzystuje więcej operacji I/O dysku do zakończenia operacji I/O danych, jest mniej przyjazny dla obciążenia wymagającego dużej liczby operacji I/O na sekundę. Im większa suma K i M, tym więcej operacji I/O będzie zużywać zasoby IOPS dysku. Używając większego K i mniejszego M, całkowita liczba bajtów danych przesyłanych w sieci klastra Ceph będzie mniejsza. To może zwiększyć wydajność przepustowości I/O dużych obiektów danych.

Efektywność przestrzenna

Efektywność użytecznej przestrzeni puli kodów usuwania jest równa K/(K+M).Na przykład, efektywność przestrzenna puli kodów usuwania K=4, M=2 wynosi 4/6 = 66,7%.To jest dwa razy bardziej wydajne niż pule replik 3, które zapewniają wyższą wydajność IOPS przy tym samym poziomie redundancji sprzętowej.

Rozsądne K jest większe niż M z powodu efektywności użytej przestrzeni.Większy kod usuwania (K-M) zyskuje lepszą efektywność przestrzenną.

Liczba hostów serwera

Liczba K+M określa również liczbę hostów lub większych domen awarii, które są wymagane w klastrze.

- Standardowa pula kodów erasure wymaga co najmniej K + M hostów serwera, aby skutecznie rozdzielić wszystkie kawałki EC.

- Zaawansowana konfiguracja kodu erasure pozwala na przechowywanie wielu kawałków EC na domenę awarii. Ta konfiguracja zmniejsza wymaganą liczbę serwerów do rozdzielania kawałków EC.

Podsumowanie wpływu kodu erasure K & M:

- M określa redundantną liczbę domen awarii.

- Większe K + M skutkuje zmniejszoną wydajnością IOPS dla małych obiektów dla klientów, ale poprawia przepustowość dla większych obiektów.

- Efektywność przestrzeni magazynowej = K/(K+M)

- Minimalna liczba wymaganych serwerów.

Jaka jest minimalna liczba hostów Ceph OSD potrzebnych do użycia puli kodów erasure?

Najlepszą praktyką korzystania z pamięci Ceph jest ustawienie domeny awarii puli większej niż „host”. Pula danych używająca hosta jako domeny awarii instruuje Ceph do zapisywania fragmentów rozproszonych na różnych hostach, aby zapewnić możliwość odzyskania danych dla innych fragmentów zapisanych na innych zdrowych hostach. Użytkownicy mogą nadal skonfigurować domenę awarii na „dysk twardy”, co chroni dane szczególnie przed awariami dysków, podobnie jak tradycyjne macierze dyskowe.

Oto zalecenia dotyczące minimalnej liczby hostów wymaganej do użycia puli kodów erasure.

Najlepsza konfiguracja: Liczba serwerów ≧ K + M +1

- Ta konfiguracja umożliwia Cephowi rozdzielenie każdego kawałka EC pomiędzy K+M hostów.

- Gdy jeden z hostów zawiedzie, masz wystarczającą liczbę hostów, aby przywrócić utracony kawałek.

Druga najlepsza konfiguracja: Liczba serwerów = K + M

- Ta konfiguracja pozwala na rozdzielenie każdego kawałka EC na K+M hostów.

- Gdy host ulegnie awarii, nie masz innego hosta, aby przywrócić utracony kawałek EC. Kluczowe jest, aby naprawić go szybko, aby jak najszybciej przywrócić system do zdrowego stanu.

Konfiguracja z ograniczonym budżetem: Liczba serwerów ≧ (K + M) / M

Ta konfiguracja instruuje Ceph, aby rozdzielił kilka chunków z kodowaniem usunięć na wyznaczoną liczbę hostów.Gdy host ulegnie awarii, maksymalnie M fragmentów obiektu zostanie utraconych.

Ta konfiguracja pozwala

- Dowolna liczba dysków może jednocześnie ulec awarii w jednym hoście.

- Lub klaster może stracić najwyżej jeden host.

- Lub tylko jeden dysk w każdym z M hostów może jednocześnie ulec awarii.

Dla przykładu K+M = 4+2, minimalna liczba wymaganych hostów to 6/2 = 3. Możesz stracić tylko jeden host, ale nie będziesz miał wystarczającej liczby zdrowych hostów w klastrze, aby naprawić utracone fragmenty.

Jak obliczyć użyteczną pojemność klastra Ceph?

Używana przestrzeń w Ceph zależy od kilku ważnych czynników.

1.Maksymalna surowa pojemność klastra Ceph zbudowanego z wielu serwerów to suma przestrzeni dyskowej w każdym serwerze.

Jeśli klaster zawiera różne typy urządzeń pamięci masowej, takie jak HDD, SSD lub dyski NVMe, należy obliczyć całkowitą surową przestrzeń dyskową dla każdego typu urządzenia osobno.Ceph jest w stanie rozpoznać wyznaczoną klasę urządzenia używaną przez każdy zbiornik.

2. Ochrona danych stosowana do każdego zbioru Ceph określa dostępną przestrzeń.

- Ochrona replikowana: dostępna przestrzeń = pojemność surowa/rozmiar repliki

- Ochrona danych za pomocą kodu erasure: dostępna przestrzeń = pojemność surowa x (K/(K+M))

3. Ceph ma pewne narzuty związane z metadanymi i operacjami systemowymi. Używana przestrzeń narzutowa wynosi około 10 do 20% w zależności od konkretnej konfiguracji i użycia.

Cała przestrzeń dysków jest dzielona pomiędzy wszystkie zbiory replikowane i zbiory kodu erasure.

- Zbiory mogą ustalać lub nie ustalać kwot. Wszystkie kwoty są przydzielane w sposób cienkowarstwowy.

- Ponieważ dostępna przestrzeń Ceph jest przydzielana w sposób cienkowarstwowy, przestrzeń do przechowywania jest przydzielana tylko w razie potrzeby, zamiast przydzielać całą wymaganą przestrzeń z góry. Może to poprawić wykorzystanie pamięci i obniżyć koszty przechowywania.

- Zaleca się rezerwację 1/n przestrzeni podczas pracy jako przestrzeni do odzyskiwania danych w przypadku awarii sprzętu, gdzie n to liczba serwerów.

- System ma wstępnie ustawione ostrzeżenia o użyciu na poziomie 85% blisko pełnej i 95% pełnej.