Почему 80% настроек высокой доступности Proxmox терпят неудачу (И как создать такую, которая не потерпит неудачу)

Функция высокой доступности (HA) Proxmox предлагает мощное обещание: когда сервер выходит из строя, ваши виртуальные машины (VM) автоматически перезапускаются на другом компьютере. Это ключ к непрерывности бизнеса, и для любого IT-специалиста, ответственного за бесперебойную работу, это ключ к спокойному сну ночью.

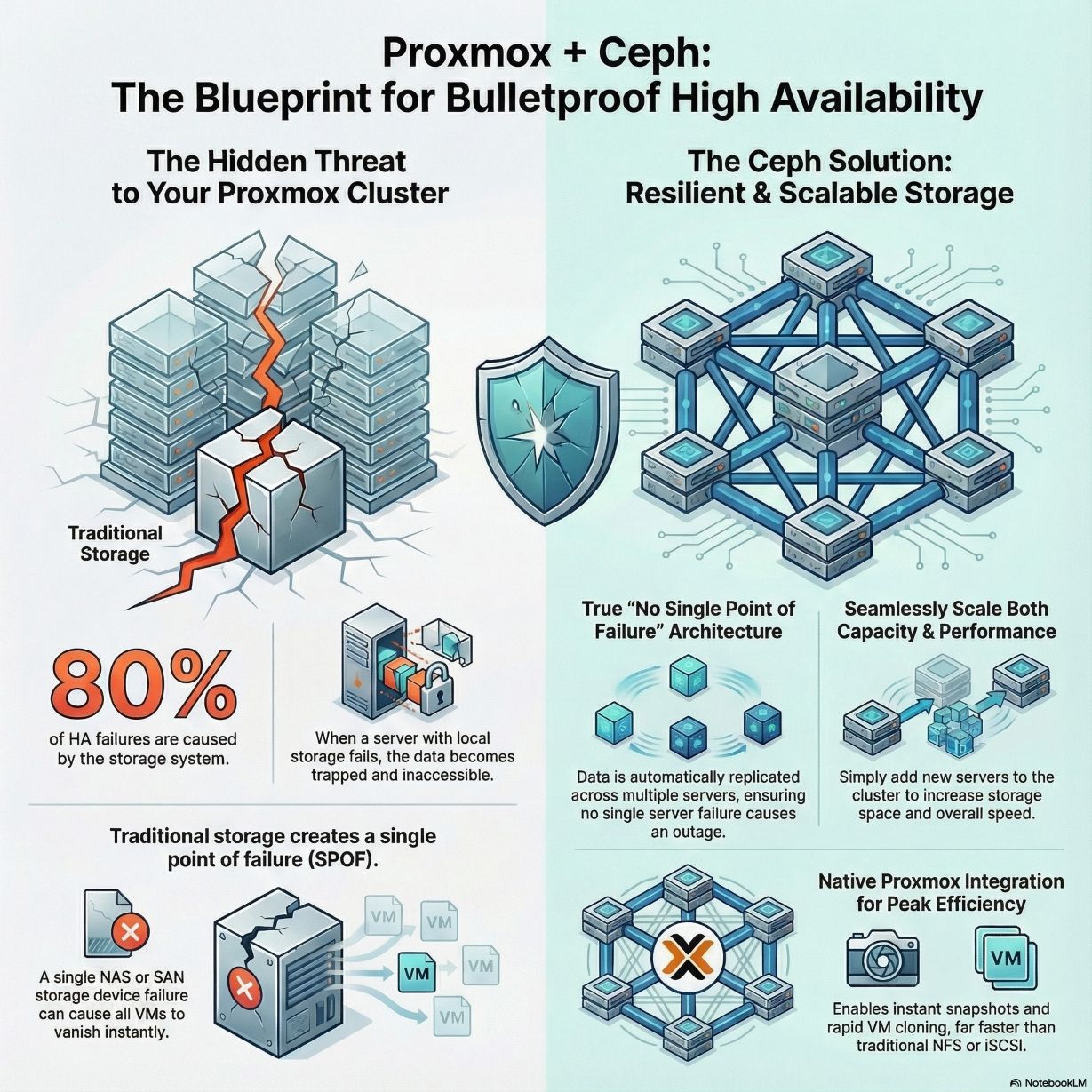

Но, основываясь на моем 20-летнем практическом опыте проектирования этих систем, я видел, как это обещание разбивалось снова и снова. Существует критическая, противоречивая проблема: 80% сбоев HA не вызваны самими вычислительными узлами. Настоящий виновник - это система хранения. Независимо от того, заблокированы ли ваши данные на локальном диске неработающего сервера или ваш весь кластер зависит от одного традиционного NAS или даже SAN с двумя контроллерами, результат остается тем же: единственная точка отказа, которая может полностью подорвать вашу стратегию высокой доступности.

Эта статья покажет вам, как решить эту критическую слабость, установив последний элемент головоломки HA: распределенную систему хранения, такую как Ceph, которая позволит вам наконец построить инфраструктуру, на которую можно положиться.

Вывод 1: Ваша настоящая точка отказа не то, что вы думаете.

Существует распространенное заблуждение, что высокая доступность в первую очередь связана с наличием резервных вычислительных серверов. Хотя резервирование серверов имеет решающее значение, мой опыт показывает, что подавляющее большинство сбоев HA — поразительные 80% — происходят из-за проблем со.storage.

Причина проста: если данные сами по себе недоступны, механизм HA бесполезен. Если данные ВМ находятся на локальном диске неработающего сервера, эти данные заблокированы на мёртвой машине, и Proxmox ничего не может сделать. Если вы используете одно традиционное устройство хранения, такое как NAS или SAN, и это устройство выходит из строя, каждая ВМ в вашем кластере мгновенно отключается.

Это определение "единой точки отказа" — критической уязвимости, которая делает в противном случае надежный кластер высокой доступности удивительно хрупким.

Вывод 2: Традиционное "Общее Хранилище" Часто Является Ловушкой Масштабирования

Многие компании используют традиционное общее хранилище, подключая свой кластер Proxmox к NAS или SAN через NFS или iSCSI. Хотя эта архитектура может показаться адекватной на первый взгляд, мой опыт показывает, что это ловушка, которая ждет, чтобы сработать на любом растущем бизнесе, создавая две основные уязвимости.

- Это все еще единственная точка отказа:Если это единственное устройство хранения выйдет из строя, весь ваш кластер Proxmox потерпит неудачу.Даже SAN с двумя контроллерами могут представлять собой единую область отказа.Хотя контроллеры избыточны, шасси, спинальная плата или само программное обеспечение все еще могут выйти из строя, что приведет к сбою всего массива и всего вашего кластера Proxmox.

- Масштабировать сложно и дорого: Когда у вас заканчиваются мощности или производительность, единственным вариантом часто становится дорогостоящий проект "снести и заменить" для покупки более крупной и мощной машины.Это значительное препятствие для роста.

Вывод 3: Истинная устойчивость означает расширение, а не только увеличение.

Чтобы решить проблему хранения, Proxmox нативно интегрирует мощное решение: распределённую систему хранения Ceph. Она устраняет единую точку отказа и предоставляет путь для бесшовного роста. Она предлагает три превосходных преимущества, которые делают её выигрышным выбором для корпоративных развертываний.

- Нет единой точки отказа: Ceph распределяет и реплицирует данные на нескольких серверах.Это не теоретично.Вы можете буквально подойти к серверу в кластере и вытащить его сетевой шнур.Виртуальные машины, которые работали на нем, автоматически мигрируют и продолжат работу на других узлах — часто без перезагрузки — используя полную реплику данных, которая уже существует в другом месте.Это действительно высококачественная отказоустойчивость для предприятий.

- Мощное горизонтальное масштабирование: В мире Ceph, когда у вас заканчивается место или производительность, решение удивительно простое: просто добавьте новый сервер, подключите его к сети и присоедините к кластеру.Ceph автоматически перераспределяет данные, и новый узел вносит вклад как в общий пул хранения, так и в общую производительность системы.

- Нативная интеграция Proxmox: Proxmox общается с Ceph нативно через RBD (RADOS Block Device), прямой протокол на уровне блоков, который гораздо эффективнее, чем протоколы сетевых файловых систем, такие как NFS или iSCSI.Эта тесная интеграция позволяет использовать мощные функции, такие как мгновенные снимки и возможность почти мгновенно клонировать новые виртуальные машины.

Вывод 4: Гиперконвергентные решения удобны, но имеют "налог" на производительность

Как только вы решите использовать Ceph, следующий вопрос - реализация: гиперконвергентная инфраструктура (HCI) или отдельный, независимый кластер хранения?

Подход HCI запускает как вычисления Proxmox, так и хранилище Ceph на одних и тех же серверах. Это экономически эффективно и проще в управлении, что делает его идеальным выбором для малых и средних кластеров от 3 до 10 узлов.

Однако HCI имеет скрытый "налог на производительность", вызванный конкуренцией за ресурсы. Фоновые операции Ceph, такие как перераспределение данных после сбоя, могут потреблять значительные ресурсы ЦП и сетевую пропускную способность, что потенциально замедляет работу виртуальных машин, работающих на том же оборудовании. Кроме того, функции управления Ceph в веб-интерфейсе Proxmox не являются исчерпывающими. Хотя они хорошо охватывают блочное хранилище и CephFS, реализация продвинутых корпоративных функций, таких как объектное хранилище S3 или NVMe-oF, часто требует перехода к командной строке (CLI), что является ключевым моментом для команд без глубоких знаний Ceph.

В отличие от этого, независимый кластер разделяет вычисления (Proxmox) и хранилище (Ceph) на выделенные серверы. Это обеспечивает стабильную, предсказуемую производительность, поскольку ресурсы хранения и вычислений никогда не мешают друг другу. Это также предлагает четкую изоляцию отказов и большую гибкость в использовании кластера Ceph для других корпоративных нужд, таких как объектное хранилище S3.

Заключение: Постройте свою инфраструктуру на прочном основании

Чтобы достичь истинной высокой доступности уровня предприятия с Proxmox, вы сначала должны решить проблему хранения с помощью распределенной системы, такой как Ceph. Полагание на одно традиционное устройство хранения оставляет вас подверженными единой точке отказа, что ставит под угрозу вашу всю стратегию высокой доступности.

Рекомендуемый путь - начать с экономически эффективной модели HCI. По мере роста вашего бизнеса и потребностей в данных планируйте переход к независимому кластеру, чтобы обеспечить стабильную производительность и масштабируемость. Вставив этот последний кусочек головоломки, вы создаете инфраструктуру, которая действительно устойчива, чтобы вы могли наконец спокойно спать по ночам.

"Хранение является основой ИТ-инфраструктуры."

Построена ли основа вашей ИТ-инфраструктуры на века, или она опирается на единую точку отказа?