Ceph RGWを使用したAI向けS3ストレージロードバランシング

AIワークロードには、トレーニングデータ、モデル、および推論出力のためのスケーラブルで高スループットのS3ストレージが必要です。 Ceph RGWは信頼性の高いS3互換のバックエンドを提供しますが、パフォーマンスは負荷分散に大きく依存します。 NVMeを使用したプライベートAIクラスターでは、LVS TUNがほぼラインレートの帯域幅と低遅延を提供します。 AmbeddedのUniVirStorは、LVS TUNをネイティブにサポートし、自動セットアップとHA設計を備えているため、パフォーマンスが重要なAIストレージ環境に最適です。

以下の重要なポイントは、各デザイン選択の必要性と正当性を要約しています。

- AIがスケーラブルで効率的なストレージを必要とする理由

- AIワークロードにS3が理想的な理由

- Ceph RGWがAI S3ストレージに強く適合する理由

- Ceph RGWにおける高可用性ロードバランシングの必要性

- Ceph RGWのオープンソースロードバランサーの選択肢

- NVMeベースのプライベートAI S3ストレージにLVS TUNが優れている理由

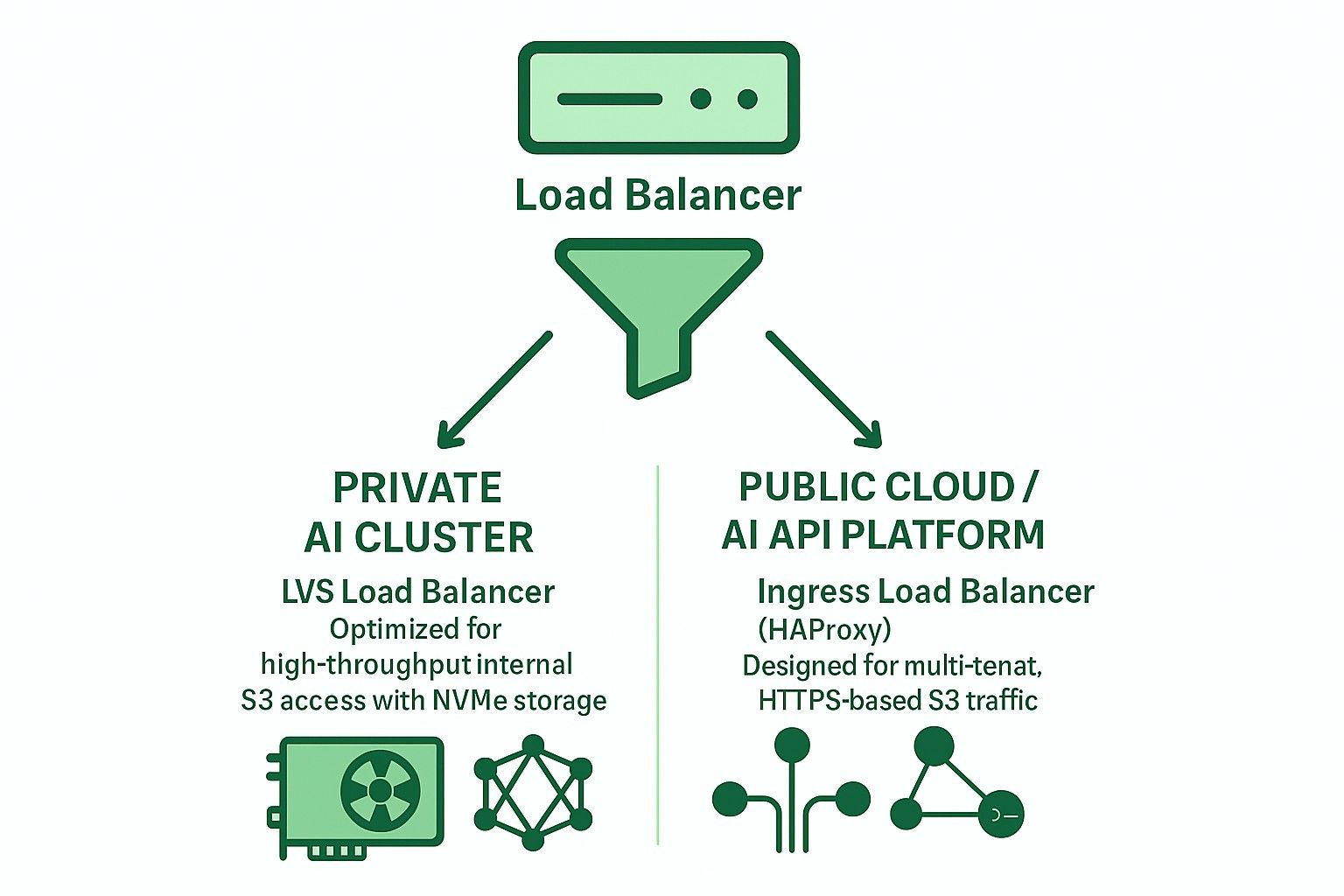

- プライベートおよびパブリッククラウドAIアプリケーションのためのLVS TUNとIngressの比較

- AmbeddedのUniVirStorがCeph RGWのLVSロードバランサーをサポートする方法

- 結論

AIがスケーラブルで効率的なストレージを必要とする理由

現代のAIワークロードは、トレーニングデータへの迅速なアクセスとコスト効率の良い長期ストレージの両方を必要とします。NVMeまたはHDDを介してアクセスされるS3オブジェクトストレージは、大規模なデータセット、チェックポイント、および推論モデルを管理するためのスケーラブルなバックエンドを提供します。

- トレーニングデータセット用の高速NVMeと低遅延アクセス

- 長期ストレージとアーカイブ用のコスト効率の良いHDD

AIワークロードにS3が理想的な理由

S3互換ストレージは、そのRESTful API、スケーラビリティ、およびMLフレームワークとの統合により、AIパイプラインで広く採用されています。サポート内容は次のとおりです:

- データセットとモデルのストレージ

- チェックポイントとアーティファクトのバージョン管理

- 推論エンドポイントへのモデルの提供

- TensorFlow、PyTorch、MLFlowとの統合

Ceph RGWがAI S3ストレージに強く適合する理由

Ceph RGWは、高可用性、強い一貫性、ペタバイト規模のスケーラビリティを提供するオープンソースのS3互換オブジェクトストレージサービスです。主な機能は次のとおりです:

- 数百のノードにわたるスケーラビリティをサポート

- 耐久性のために強力な整合性と消去コーディングを提供します。

- ハイブリッドクラウドのユースケースのために統合されたマルチサイトレプリケーションを提供します。

- コスト効果の高い汎用ハードウェアに展開できます。

これにより、Ceph RGWはペタバイト規模およびパフォーマンスが重要な環境でのAI中心のオブジェクトストレージの強力なバックエンドとなります。

Ceph RGWにおける高可用性ロードバランシングの必要性

Ceph RGWはステートレスであり、水平スケーリングを可能にします。ただし、提供するためには:

- 高可用性

- フェイルオーバーサポート

- パフォーマンスのスケーラビリティ

複数のRGWインスタンスに対して、着信S3リクエスト(GET、PUT、DELETE)を信頼性高く効率的に分配できるフロントエンドロードバランサーが必要です。

適切なロードバランシングがないと、単一のRGWノードまたはフロントエンドサーバーがボトルネックまたは単一障害点になる可能性があります。

Ceph RGWのオープンソースロードバランサーの選択肢

オープンソースのロードバランサーで一般的に使用される2つの主要なアーキテクチャは次のとおりです:

-

Ingressベース(HAProxy + Keepalived + Multi-VIP + DNS RR)

- レイヤー7(HTTP)サポート

- TLS終端、SNIベースのマルチテナントルーティングをサポート

- パブリッククラウドまたはマルチテナントデプロイメントに適しています

- わずかに高いレイテンシがあり、ボトルネックを避けるために慎重な調整が必要です

- 大規模なデプロイメントでは、HAProxyがボトルネックにならないようにするために、複数の高性能ハードウェアサーバーが必要です。

-

LVS TUN は加重最小接続(WLC)を追跡しました

- レイヤー4 IP-in-IPトンネリング

- 高スループットと低CPU使用率

- 戻りトラフィックのためにバランサーをバイパスします

- プライベートで高速な内部ネットワークに最適です

NVMeベースのプライベートAI S3ストレージにLVS TUNが優れている理由

内部のNVMeベースのAIトレーニングクラスターでは、パフォーマンスが最優先です:

- LVS TUNはほぼラインレートの帯域幅を実現します

- TLSを終了しないため、CPUオーバーヘッドが削減されます

- conntrackdはクライアントの中断なしにシームレスなフェイルオーバーを保証します

- アプリケーション層の検査を行わないため、レイテンシが減少します

したがって、LVS TUNは高速な内部AIオブジェクトストレージ(例:GPUクラスターのトレーニングパイプライン)に対してHAProxyよりも適しています。

プライベートおよびパブリッククラウドAIアプリケーションのためのLVS TUNとIngressの比較

| 機能 | イングレス (HAProxy) | LVS TUN が追跡されました |

|---|---|---|

| TLS終端処理 | ✅ はい | ❌ いいえ |

| マルチテナントルーティング | ✅ はい | ❌ いいえ |

| スループット | ❌ 制限あり | ✅ ラインレート |

| レイテンシ | ❌ 高い | ✅ 低い |

| ヘルスチェック | ✅ HTTP | ❌ TCP/ICMP |

| DNS統合 | ✅ 必須 | ❌ 不要 |

| 理想的な使用ケース | パブリッククラウド | プライベートAI/HPC |

AmbeddedのUniVirStorがCeph RGWのLVSロードバランサーをサポートする方法

UniVirStorは、次のようなLVS TUNモードのネイティブサポートを提供します:

- Ansibleベースの自動セットアップ

- keepalivedとconntrackdによる高可用性

- ヘルスチェックフックとパフォーマンスメトリクス

- 高スループットS3ゲートウェイのための最適化されたルーティング

これにより、UniVirStorは、Ceph RGWからパフォーマンスと信頼性の両方を要求するAIデータレイクやGPUベースのAIクラスターを構築する顧客に最適です。

結論

適切なロードバランサーアーキテクチャを選択することは、AIのための堅牢でスケーラブルなS3ストレージバックエンドを構築するために不可欠です。

- プライベートAIクラスターの場合、パフォーマンスを最大化するためにLVS TUN + conntrackdを使用してください。

- 公開サービスやマルチテナントS3の場合、より良い柔軟性とTLS処理のためにIngressベースのHAProxyを使用してください。

AmbeddedのUniVirStorは、プロダクショングレードの調整と高可用性サポートを備えた両方のシナリオを効率的に展開するのに役立ちます。