Równoważenie obciążenia pamięci S3 dla AI z Ceph RGW

Obciążenia AI wymagają skalowalnego, o wysokiej przepustowości magazynu S3 do danych treningowych, modeli i wyników wnioskowania. Ceph RGW oferuje niezawodny, zgodny z S3 backend, ale wydajność w dużej mierze zależy od równoważenia obciążenia. Dla prywatnych klastrów AI korzystających z NVMe, LVS TUN zapewnia niemal pełną przepustowość i niskie opóźnienia. UniVirStor 'a Ambedded natywnie wspiera LVS TUN z automatyczną konfiguracją i projektowaniem HA, co czyni go idealnym dla środowisk pamięci masowej AI krytycznych dla wydajności.

Poniższe kluczowe punkty podsumowują potrzebę i uzasadnienie dla każdego wyboru projektowego.

- Dlaczego AI potrzebuje skalowalnego i wydajnego przechowywania danych

- Dlaczego S3 jest idealne dla obciążeń AI

- Dlaczego Ceph RGW jest doskonałym rozwiązaniem dla przechowywania AI S3

- Potrzeba wysokiej dostępności równoważenia obciążenia w Ceph RGW

- Opcje równoważenia obciążenia open-source dla Ceph RGW

- Dlaczego LVS TUN jest lepsze dla prywatnego przechowywania AI S3 opartego na NVMe

- Porównanie LVS TUN i Ingress dla usług prywatnych i amp; Aplikacje AI w chmurze publicznej

- Jak Ambedded UniVirStor wspiera równoważnik obciążenia LVS dla Ceph RGW

- Podsumowanie

Dlaczego AI potrzebuje skalowalnego i wydajnego przechowywania danych

Nowoczesne obciążenia AI wymagają zarówno szybkiego dostępu do danych treningowych, jak i opłacalnego długoterminowego przechowywania. Przechowywanie obiektów S3, dostępne przez NVMe lub HDD, zapewnia skalowalny backend do zarządzania dużymi zbiorami danych, punktami kontrolnymi i modelami inferencyjnymi.

- Szybkie NVMe do zbiorów danych treningowych i niskolatencyjny dostęp

- Opłacalny HDD do długoterminowego przechowywania i archiwów

Dlaczego S3 jest idealne dla obciążeń AI

Przechowywanie zgodne z S3 jest szeroko stosowane w pipeline'ach AI dzięki swojemu interfejsowi API RESTful, skalowalności i integracji z frameworkami ML. Obsługuje:

- Przechowywanie zbiorów danych i modeli

- Punktowanie kontrolne i wersjonowanie artefaktów

- Serwowanie modeli do punktów końcowych inferencji

- Integracja z TensorFlow, PyTorch, MLFlow

Dlaczego Ceph RGW jest doskonałym rozwiązaniem dla przechowywania AI S3

Ceph RGW to usługa przechowywania obiektów zgodna z S3, open-source, która oferuje wysoką dostępność, silną spójność i skalowalność na poziomie petabajtów. Kluczowe cechy to:

- Obsługuje skalowalność w setkach węzłów

- Oferuje silną spójność i kodowanie usuwania dla trwałości

- Zapewnia zintegrowaną replikację w wielu lokalizacjach dla przypadków użycia w chmurze hybrydowej

- Może być wdrażany na opłacalnym sprzęcie ogólnym

To sprawia, że Ceph RGW jest potężnym zapleczem dla obiektowego przechowywania danych skoncentrowanego na AI zarówno w skali petabajtów, jak i w środowiskach krytycznych dla wydajności.

Potrzeba wysokiej dostępności równoważenia obciążenia w Ceph RGW

Ceph RGW jest bezstanowy, co pozwala na poziome skalowanie. Jednak aby zapewnić:

- Wysoką dostępność

- Wsparcie dla przełączania awaryjnego

- Skalowalność wydajności

Potrzebujesz zewnętrznego balansu obciążenia, który może niezawodnie i efektywnie rozdzielać przychodzące żądania S3 (GET, PUT, DELETE) pomiędzy wieloma instancjami RGW.

Bez odpowiedniego balansu obciążenia, pojedynczy węzeł RGW lub serwer front-end może stać się wąskim gardłem lub pojedynczym punktem awarii.

Opcje równoważenia obciążenia open-source dla Ceph RGW

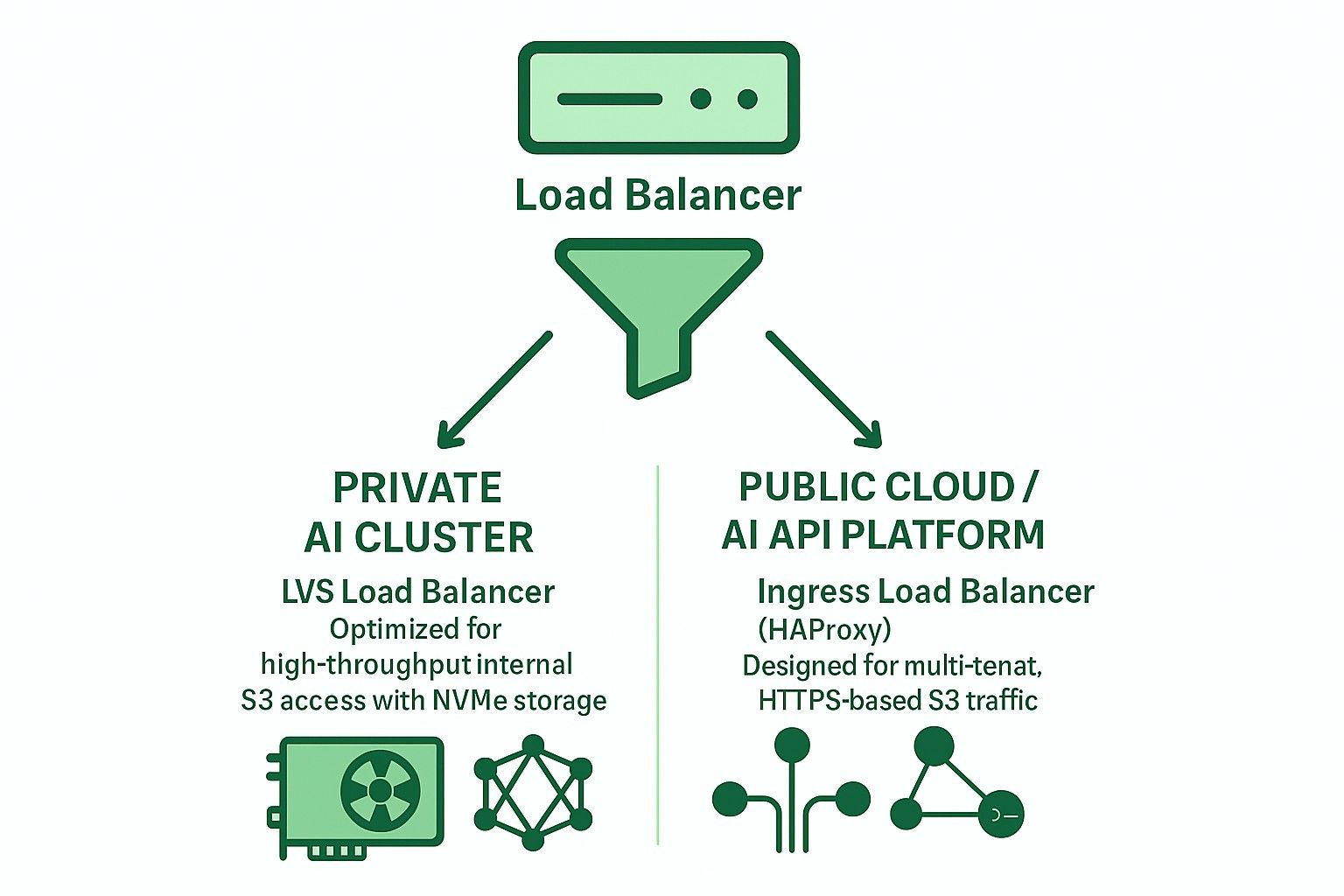

Dwie podstawowe architektury są powszechnie używane z otwartoźródłowymi równoważnikami obciążenia:

-

Oparte na Ingress (HAProxy + Keepalived + Multi-VIP + DNS RR)

- Wsparcie dla warstwy 7 (HTTP)

- Obsługuje zakończenie TLS, routowanie wielodostępowe oparte na SNI

- Odpowiednie dla publicznych chmur lub wdrożeń wielodostępnych

- Nieco wyższe opóźnienia i wymaga starannego dostrojenia, aby uniknąć wąskich gardeł

- Przy większych skalach wdrożenia wymagane są wiele wysokowydajnych serwerów sprzętowych, aby zapobiec staniu się HAProxy wąskim gardłem.

-

LVS TUN + conntrackd + Ważone Najmniejsze Połączenia (WLC)

- Tunelowanie IP w IP na warstwie 4

- Wysoka przepustowość i niskie zużycie CPU

- Omija balancer dla ruchu zwrotnego

- Najlepsze dla prywatnych, szybkich sieci wewnętrznych

Dlaczego LVS TUN jest lepsze dla prywatnego przechowywania AI S3 opartego na NVMe

Dla wewnętrznych klastrów szkoleniowych AI opartych na NVMe, wydajność jest najwyższym priorytetem:

- LVS TUN osiąga prawie pełną przepustowość

- Nie kończy TLS, co zmniejsza obciążenie CPU

- conntrackd zapewnia płynne przełączanie bez przerywania klienta

- Brak inspekcji na poziomie aplikacji zmniejsza opóźnienia

Dlatego LVS TUN jest lepszym wyborem niż HAProxy dla szybkiego wewnętrznego przechowywania obiektów AI (np. pipeline'y szkoleniowe klastrów GPU).

Porównanie LVS TUN i Ingress dla usług prywatnych i amp; Aplikacje AI w chmurze publicznej

| Funkcja | Ingres (HAProxy) | Połączenie LVS TUN |

|---|---|---|

| Zakończenie TLS | ✅ Tak | ❌ Nie |

| Routing wielodostępowy | ✅ Tak | ❌ Nie |

| Przepustowość | ❌ Ograniczone | ✅ W pełnej szybkości |

| Opóźnienie | ❌ Wyższe | ✅ Niższy |

| Kontrole zdrowia | ✅ HTTP | ❌ TCP/ICMP |

| Integracja DNS | ✅ Wymagane | ❌ Niepotrzebne |

| Idealny przypadek użycia | Chmura publiczna | Prywatna AI/HPC |

Jak Ambedded UniVirStor wspiera równoważnik obciążenia LVS dla Ceph RGW

UniVirStor oferuje natywne wsparcie dla trybu LVS TUN, w tym:

- Automatyczna konfiguracja oparta na Ansible

- Wysoka dostępność z keepalived i conntrackd

- Hooki do sprawdzania stanu i metryki wydajności

- Optymalizowane routowanie dla bramek S3 o wysokiej przepustowości

To sprawia, że UniVirStor jest idealny dla klientów budujących jeziora danych AI lub klastry AI oparte na GPU, które wymagają zarówno wydajności, jak i niezawodności od Ceph RGW.

Podsumowanie

Wybór odpowiedniej architektury load balancera jest kluczowy dla budowy solidnego, skalowalnego backendu pamięci S3 dla AI.

- Dla prywatnych klastrów AI użyj LVS TUN + conntrackd, aby zmaksymalizować wydajność.

- Dla usług publicznych lub wielo-tenantowych S3 użyj HAProxy opartego na Ingress dla lepszej elastyczności i obsługi TLS.

Ambedded UniVirStor pomaga efektywnie wdrażać oba scenariusze z tuningiem na poziomie produkcyjnym i wsparciem dla wysokiej dostępności.