การโหลดบาลานซ์การจัดเก็บ S3 สำหรับ AI ด้วย Ceph RGW

งาน AI ต้องการการจัดเก็บ S3 ที่สามารถปรับขนาดได้และมีความสามารถในการส่งข้อมูลสูงสำหรับข้อมูลการฝึกอบรม โมเดล และผลลัพธ์การอนุมาน. Ceph RGW มีแบ็คเอนด์ที่เชื่อถือได้และเข้ากันได้กับ S3 แต่ประสิทธิภาพขึ้นอยู่กับการกระจายโหลดอย่างมาก. สำหรับคลัสเตอร์ AI ส่วนตัวที่ใช้ NVMe, LVS TUN ให้แบนด์วิธใกล้เคียงกับอัตราไลน์และความหน่วงต่ำ. UniVirStor ของ Ambedded รองรับ LVS TUN โดยอัตโนมัติพร้อมการตั้งค่าและการออกแบบ HA ทำให้เหมาะสำหรับสภาพแวดล้อมการจัดเก็บข้อมูล AI ที่ต้องการประสิทธิภาพสูง.

ประเด็นสำคัญต่อไปนี้สรุปความจำเป็นและเหตุผลสำหรับการเลือกออกแบบแต่ละอย่าง.

- ทำไม AI ถึงต้องการการจัดเก็บข้อมูลที่สามารถขยายขนาดได้และมีประสิทธิภาพ

- ทำไม S3 ถึงเหมาะสมสำหรับงาน AI

- ทำไม Ceph RGW ถึงเหมาะสมอย่างยิ่งสำหรับการจัดเก็บ AI S3

- ความจำเป็นในการทำให้โหลดบาลานซ์มีความพร้อมใช้งานสูงใน Ceph RGW

- ตัวเลือกโหลดบาลานเซอร์แบบโอเพนซอร์สสำหรับ Ceph RGW

- ทำไม LVS TUN ถึงดีกว่าสำหรับการจัดเก็บ AI S3 ส่วนตัวที่ใช้ NVMe

- เปรียบเทียบ LVS TUN กับ Ingress สำหรับแอปพลิเคชัน AI คลาวด์ส่วนตัวและสาธารณะ

- UniVirStor ของ Ambedded สนับสนุน LVS Load Balancer สำหรับ Ceph RGW อย่างไร

- บทสรุป

ทำไม AI ถึงต้องการการจัดเก็บข้อมูลที่สามารถขยายขนาดได้และมีประสิทธิภาพ

งานโหลด AI สมัยใหม่ต้องการการเข้าถึงข้อมูลการฝึกอบรมอย่างรวดเร็วและการจัดเก็บระยะยาวที่คุ้มค่า S3 object storage ที่เข้าถึงได้ผ่าน NVMe หรือ HDD ให้บริการแบ็คเอนด์ที่สามารถปรับขนาดได้สำหรับการจัดการชุดข้อมูลขนาดใหญ่ จุดตรวจสอบ และโมเดลการอนุมาน.

- NVMe ความเร็วสูงสำหรับชุดข้อมูลการฝึกอบรมและการเข้าถึงที่มีความหน่วงต่ำ

- HDD ที่คุ้มค่าสำหรับการจัดเก็บระยะยาวและคลังข้อมูล

ทำไม S3 ถึงเหมาะสมสำหรับงาน AI

การจัดเก็บที่เข้ากันได้กับ S3 ได้รับการนำไปใช้กันอย่างแพร่หลายในสายงาน AI เนื่องจาก API แบบ RESTful ความสามารถในการปรับขนาด และการรวมเข้ากับกรอบ ML มันรองรับ:

- การจัดเก็บชุดข้อมูลและโมเดล

- การตรวจสอบจุดและการจัดการเวอร์ชันของอาร์ติแฟกต์

- การให้บริการโมเดลไปยังจุดสิ้นสุดการอนุมาน

- การรวมเข้ากับ TensorFlow, PyTorch, MLFlow

ทำไม Ceph RGW ถึงเหมาะสมอย่างยิ่งสำหรับการจัดเก็บ AI S3

Ceph RGW เป็นบริการจัดเก็บวัตถุที่เข้ากันได้กับ S3 แบบโอเพนซอร์สที่มีความพร้อมใช้งานสูง ความสอดคล้องที่แข็งแกร่ง และความสามารถในการปรับขนาดในระดับเพตาไบต์ ฟีเจอร์หลักประกอบด้วย:

- รองรับการปรับขนาดข้ามโหนดหลายร้อยโหนด

- เสนอความสอดคล้องที่แข็งแกร่งและการเข้ารหัสการลบเพื่อความทนทาน

- ให้การทำซ้ำแบบหลายไซต์ที่รวมเข้าด้วยกันสำหรับกรณีการใช้งานคลาวด์แบบไฮบริด

- สามารถติดตั้งบนฮาร์ดแวร์ที่มีต้นทุนต่ำ

นี่ทำให้ Ceph RGW เป็นแบ็คเอนด์ที่ทรงพลังสำหรับการจัดเก็บวัตถุที่มุ่งเน้น AI ทั้งในระดับเพตาไบต์และในสภาพแวดล้อมที่มีความสำคัญต่อประสิทธิภาพ

ความจำเป็นในการทำให้โหลดบาลานซ์มีความพร้อมใช้งานสูงใน Ceph RGW

Ceph RGW ไม่มีสถานะ ทำให้สามารถขยายแนวนอนได้ อย่างไรก็ตาม เพื่อให้บริการ:

- ความพร้อมใช้งานสูง

- การสนับสนุนการเปลี่ยนผ่าน

- ความสามารถในการปรับขนาดประสิทธิภาพ

คุณต้องมีโหลดบาลานเซอร์ด้านหน้า ที่สามารถกระจายคำขอ S3 ที่เข้ามา (GET, PUT, DELETE) ได้อย่างเชื่อถือได้และมีประสิทธิภาพไปยังหลายอินสแตนซ์ RGW

หากไม่มีการกระจายโหลดที่เหมาะสม โหนด RGW เดียวหรือเซิร์ฟเวอร์ด้านหน้าสามารถกลายเป็นจุดคอขวดหรือจุดล้มเหลวเดียว

ตัวเลือกโหลดบาลานเซอร์แบบโอเพนซอร์สสำหรับ Ceph RGW

สถาปัตยกรรมหลักสองแบบที่มักใช้กับโหลดบาลานเซอร์แบบโอเพนซอร์ส:

-

Ingress-Based (HAProxy + Keepalived + Multi-VIP + DNS RR)

- การสนับสนุน Layer 7 (HTTP)

- รองรับการสิ้นสุด TLS, การจัดเส้นทางแบบหลายผู้เช่าโดยอิงจาก SNI

- เหมาะสำหรับการใช้งานในคลาวด์สาธารณะหรือการใช้งานแบบหลายผู้เช่า

- มีความหน่วงเล็กน้อยและต้องการการปรับแต่งอย่างระมัดระวังเพื่อหลีกเลี่ยงปัญหาคอขวด

- ในระดับการใช้งานที่ใหญ่ขึ้น จะต้องมีเซิร์ฟเวอร์ฮาร์ดแวร์ประสิทธิภาพสูงหลายเครื่องเพื่อป้องกันไม่ให้ HAProxy กลายเป็นปัญหาคอขวด.

-

LVS TUN เชื่อมต่อ Weighted Least Connections (WLC)

- การสร้างอุโมงค์ IP-in-IP ที่ Layer 4

- ความสามารถในการส่งข้อมูลสูงและการใช้ CPU ต่ำ

- ข้ามตัวบาลานเซอร์สำหรับการจราจรกลับ

- ดีที่สุดสำหรับเครือข่ายภายในที่มีความเร็วสูงและเป็นส่วนตัว

ทำไม LVS TUN ถึงดีกว่าสำหรับการจัดเก็บ AI S3 ส่วนตัวที่ใช้ NVMe

สำหรับคลัสเตอร์การฝึกอบรม AI ที่ใช้ NVMe ภายใน ประสิทธิภาพคือสิ่งสำคัญที่สุด:

- LVS TUN สามารถทำความเร็วแบนด์วิดธ์ใกล้เคียงกับอัตราไลน์

- ไม่สิ้นสุด TLS ลดภาระ CPU

- conntrackd รับประกันการเปลี่ยนผ่านที่ราบรื่นโดยไม่มีการหยุดชะงักของลูกค้า

- การตรวจสอบที่ชั้นแอปพลิเคชันที่ไม่มีจะลดความหน่วง

ดังนั้น LVS TUN จึงเหมาะสมกว่ากับ HAProxy สำหรับการจัดเก็บวัตถุ AI ภายในที่มีความเร็วสูง (เช่น ท่อการฝึกอบรมคลัสเตอร์ GPU).

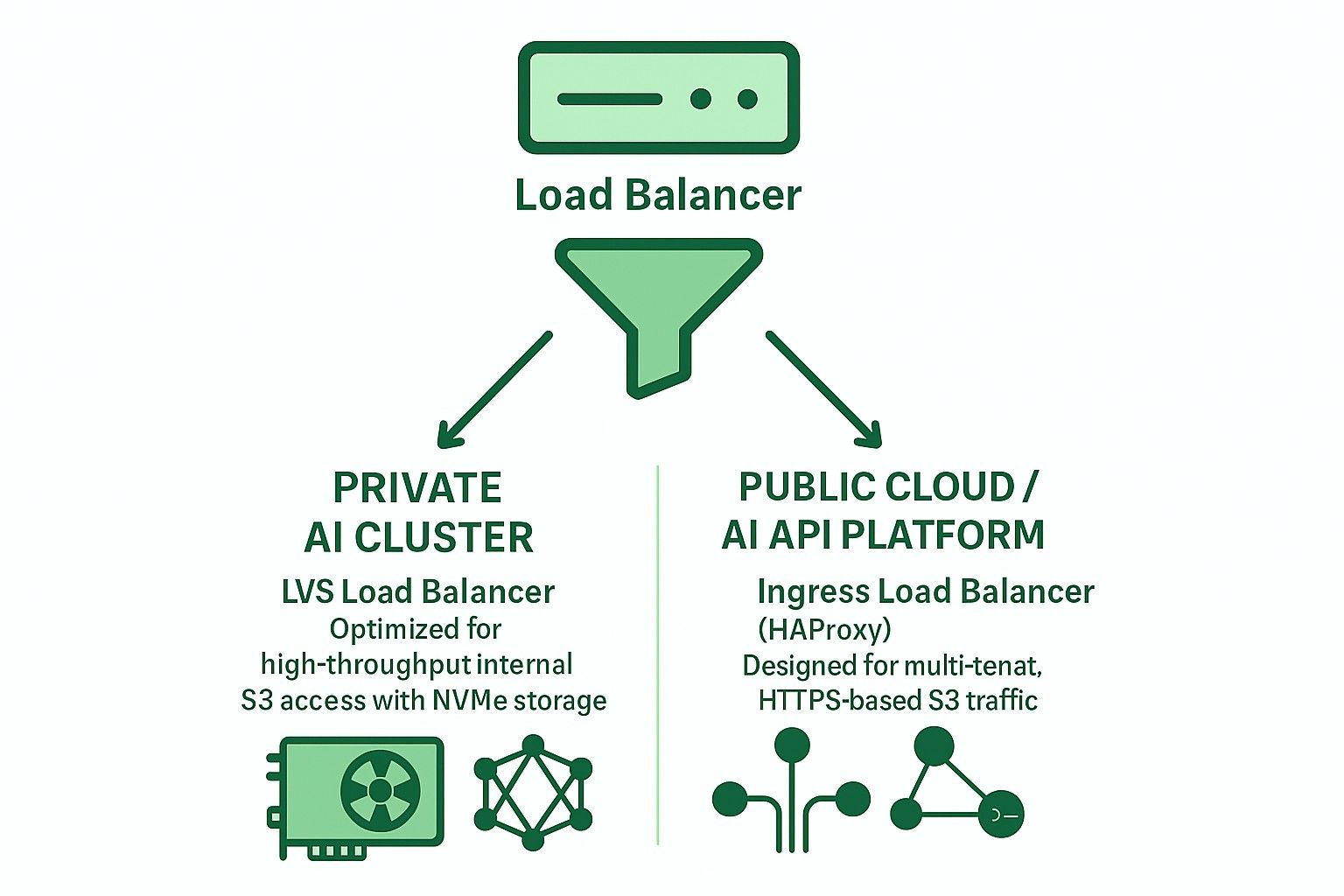

เปรียบเทียบ LVS TUN กับ Ingress สำหรับแอปพลิเคชัน AI คลาวด์ส่วนตัวและสาธารณะ

| ฟีเจอร์ | ทางเข้า (HAProxy) | LVS TUN มีข้อจำกัด |

|---|---|---|

| การสิ้นสุด TLS | ✅ ใช่ | ❌ ไม่ |

| การจัดเส้นทางหลายผู้เช่า | ✅ ใช่ | ❌ ไม่ |

| อัตราการส่งข้อมูล | ❌ จำกัด | ✅ อัตราเส้น |

| ความหน่วง | ❌ สูงกว่า | ✅ ต่ำกว่า |

| การตรวจสอบสุขภาพ | ✅ HTTP | ❌ TCP/ICMP |

| การรวม DNS | ✅ จำเป็น | ❌ ไม่จำเป็น |

| กรณีการใช้งานที่เหมาะสม | คลาวด์สาธารณะ | AI/HPC ส่วนตัว |

UniVirStor ของ Ambedded สนับสนุน LVS Load Balancer สำหรับ Ceph RGW อย่างไร

UniVirStor มีการสนับสนุนแบบเนทีฟสำหรับโหมด LVS TUN รวมถึง:

- การตั้งค่าอัตโนมัติที่ใช้ Ansible

- ความพร้อมใช้งานสูงด้วย keepalived และ conntrackd

- ฮุคการตรวจสอบสุขภาพและเมตริกประสิทธิภาพ

- การจัดเส้นทางที่ปรับให้เหมาะสมสำหรับเกตเวย์ S3 ที่มีความสามารถในการส่งข้อมูลสูง

นี่ทำให้ UniVirStor เป็นตัวเลือกที่เหมาะสมสำหรับลูกค้าที่สร้าง AI data lakes หรือ GPU-based AI clusters ที่ต้องการทั้งประสิทธิภาพและความเชื่อถือได้จาก Ceph RGW.

บทสรุป

การเลือกสถาปัตยกรรมโหลดบาลานเซอร์ที่เหมาะสมเป็นสิ่งสำคัญสำหรับการสร้าง S3 storage backend ที่แข็งแกร่งและสามารถขยายได้สำหรับ AI.

- สำหรับคลัสเตอร์ AI ส่วนตัว ให้ใช้ LVS TUN + conntrackd เพื่อเพิ่มประสิทธิภาพสูงสุด.

- สำหรับบริการที่เปิดเผยต่อสาธารณะหรือ S3 แบบหลายผู้เช่า ให้ใช้ HAProxy ที่ใช้ Ingress เพื่อความยืดหยุ่นและการจัดการ TLS ที่ดีกว่า.

Ambedded's UniVirStor ช่วยให้คุณปรับใช้ทั้งสองสถานการณ์ได้อย่างมีประสิทธิภาพด้วยการปรับแต่งระดับการผลิตและการสนับสนุนความพร้อมใช้งานสูง.