Cân bằng tải lưu trữ S3 cho AI với Ceph RGW

Các khối lượng công việc AI yêu cầu lưu trữ S3 có khả năng mở rộng và thông lượng cao cho dữ liệu đào tạo, mô hình và đầu ra suy diễn. Ceph RGW cung cấp một backend đáng tin cậy, tương thích với S3, nhưng hiệu suất phụ thuộc nhiều vào việc cân bằng tải. Đối với các cụm AI riêng tư sử dụng NVMe, LVS TUN cung cấp băng thông gần như theo tỷ lệ đường truyền và độ trễ thấp. UniVirStor của Ambedded hỗ trợ LVS TUN một cách tự nhiên với thiết lập tự động và thiết kế HA, làm cho nó trở thành lý tưởng cho các môi trường lưu trữ AI quan trọng về hiệu suất.

Các điểm chính sau đây tóm tắt nhu cầu và lý do cho mỗi lựa chọn thiết kế.

- Tại sao AI cần lưu trữ có thể mở rộng và hiệu quả

- Tại sao S3 là lý tưởng cho các khối lượng công việc AI

- Tại sao Ceph RGW là sự lựa chọn mạnh mẽ cho lưu trữ AI S3

- Nhu cầu về cân bằng tải có độ sẵn sàng cao trong Ceph RGW

- Các tùy chọn cân bằng tải mã nguồn mở cho Ceph RGW

- Tại sao LVS TUN tốt hơn cho lưu trữ AI S3 riêng tư dựa trên NVMe

- So sánh LVS TUN và Ingress cho các ứng dụng AI trên đám mây riêng và công cộng

- Cách mà Ambedded's UniVirStor hỗ trợ cân bằng tải LVS cho Ceph RGW

- Kết luận

Tại sao AI cần lưu trữ có thể mở rộng và hiệu quả

Các khối lượng công việc AI hiện đại yêu cầu cả việc truy cập nhanh vào dữ liệu đào tạo và lưu trữ lâu dài tiết kiệm chi phí. Lưu trữ đối tượng S3, được truy cập qua NVMe hoặc HDD, cung cấp một backend có thể mở rộng để quản lý các tập dữ liệu lớn, điểm kiểm tra và mô hình suy diễn.

- NVMe tốc độ cao cho các tập dữ liệu đào tạo và truy cập độ trễ thấp

- HDD tiết kiệm chi phí cho lưu trữ lâu dài và lưu trữ hồ sơ

Tại sao S3 là lý tưởng cho các khối lượng công việc AI

Lưu trữ tương thích S3 được áp dụng rộng rãi trong các quy trình AI nhờ vào API RESTful, khả năng mở rộng và tích hợp với các khung ML. Nó hỗ trợ:

- Lưu trữ tập dữ liệu và mô hình

- Kiểm tra điểm và phiên bản hóa đối tượng

- Cung cấp mô hình cho các điểm suy diễn

- Tích hợp với TensorFlow, PyTorch, MLFlow

Tại sao Ceph RGW là sự lựa chọn mạnh mẽ cho lưu trữ AI S3

Ceph RGW là một dịch vụ lưu trữ đối tượng mã nguồn mở, tương thích S3, cung cấp tính khả dụng cao, tính nhất quán mạnh mẽ và khả năng mở rộng quy mô petabyte. Các tính năng chính bao gồm:

- Hỗ trợ khả năng mở rộng trên hàng trăm nút

- Cung cấp tính nhất quán mạnh mẽ và mã hóa xóa để đảm bảo độ bền.

- Cung cấp sao chép đa địa điểm tích hợp cho các trường hợp sử dụng đám mây lai.

- Có thể triển khai trên phần cứng hàng hóa tiết kiệm chi phí.

Điều này làm cho Ceph RGW trở thành một backend mạnh mẽ cho lưu trữ đối tượng tập trung vào AI ở cả quy mô petabyte và môi trường yêu cầu hiệu suất cao.

Nhu cầu về cân bằng tải có độ sẵn sàng cao trong Ceph RGW

Ceph RGW là không trạng thái, cho phép mở rộng theo chiều ngang. Tuy nhiên, để cung cấp:

- Tính khả dụng cao.

- Hỗ trợ chuyển đổi dự phòng.

- Khả năng mở rộng hiệu suất.

Bạn cần một bộ cân bằng tải phía trước có thể phân phối đáng tin cậy và hiệu quả các yêu cầu S3 đến (GET, PUT, DELETE) trên nhiều phiên bản RGW.

Nếu không có cân bằng tải hợp lý, một nút RGW hoặc máy chủ phía trước có thể trở thành nút thắt cổ chai hoặc điểm thất bại duy nhất.

Các tùy chọn cân bằng tải mã nguồn mở cho Ceph RGW

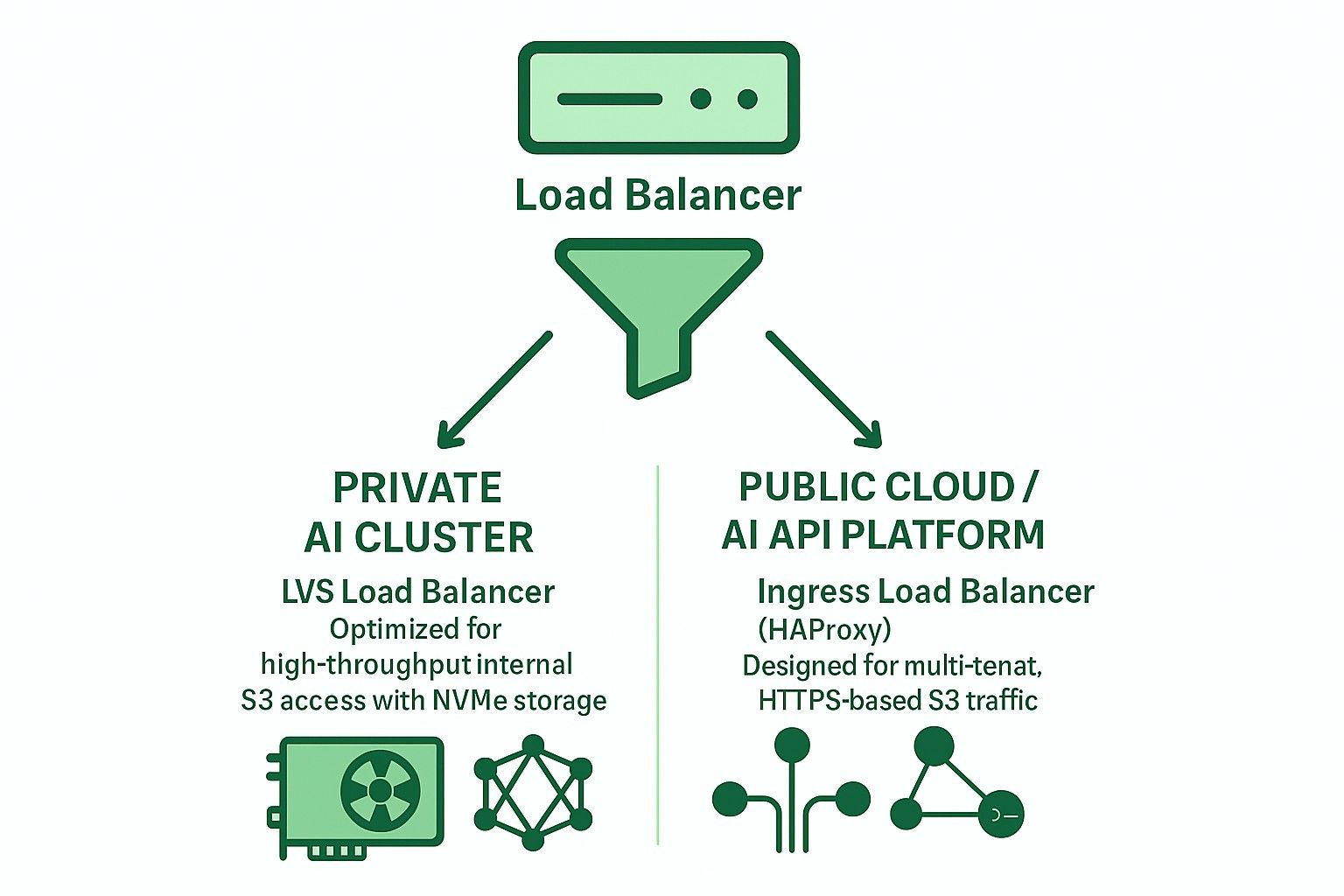

Hai kiến trúc chính thường được sử dụng với các bộ cân bằng tải mã nguồn mở:

-

Dựa trên Ingress (HAProxy + Keepalived + Multi-VIP + DNS RR)

- Hỗ trợ Layer 7 (HTTP)

- Hỗ trợ kết thúc TLS, định tuyến đa người dùng dựa trên SNI

- Phù hợp cho đám mây công cộng hoặc triển khai đa người dùng

- Độ trễ hơi cao hơn và yêu cầu điều chỉnh cẩn thận để tránh tắc nghẽn

- Ở quy mô triển khai lớn hơn, cần nhiều máy chủ phần cứng hiệu suất cao để ngăn HAProxy trở thành nút thắt cổ chai.

-

LVS TUN + conntrackd + Kết nối ít nhất có trọng số (WLC)

- Đường hầm IP-in-IP Layer 4

- Thông lượng cao và mức sử dụng CPU thấp

- Bỏ qua bộ cân bằng cho lưu lượng trả về

- Tốt nhất cho mạng nội bộ riêng tư, tốc độ cao

Tại sao LVS TUN tốt hơn cho lưu trữ AI S3 riêng tư dựa trên NVMe

Đối với các cụm đào tạo AI dựa trên NVMe nội bộ, hiệu suất là ưu tiên hàng đầu:

- LVS TUN đạt băng thông gần như theo tỷ lệ đường truyền

- Không kết thúc TLS, giảm tải CPU

- conntrackd đảm bảo chuyển đổi liền mạch mà không làm gián đoạn khách hàng

- Không kiểm tra ở lớp ứng dụng giảm độ trễ

Do đó, LVS TUN phù hợp hơn so với HAProxy cho lưu trữ đối tượng AI nội bộ tốc độ cao (ví dụ: quy trình đào tạo cụm GPU).

So sánh LVS TUN và Ingress cho các ứng dụng AI trên đám mây riêng và công cộng

| Tính năng | Xâm nhập (HAProxy) | LVS TUN được kết nối |

|---|---|---|

| Kết thúc TLS | ✅ Có | ❌ Không |

| Định tuyến đa người dùng | ✅ Có | ❌ Không |

| Thông lượng | ❌ Hạn chế | ✅ Tốc độ dòng |

| Độ trễ | ❌ Cao hơn | ✅ Thấp hơn |

| Kiểm tra sức khỏe | ✅ HTTP | ❌ TCP/ICMP |

| Tích hợp DNS | ✅ Bắt buộc | ❌ Không cần thiết |

| Trường hợp sử dụng lý tưởng | Đám mây công cộng | AI/HPC riêng tư |

Cách mà Ambedded's UniVirStor hỗ trợ cân bằng tải LVS cho Ceph RGW

UniVirStor cung cấp hỗ trợ gốc cho chế độ LVS TUN, bao gồm:

- Cài đặt tự động dựa trên Ansible

- Tính khả dụng cao với keepalived và conntrackd

- Các móc kiểm tra sức khỏe và chỉ số hiệu suất

- Định tuyến tối ưu cho các cổng S3 có thông lượng cao

Điều này làm cho UniVirStor trở thành lựa chọn lý tưởng cho khách hàng xây dựng hồ dữ liệu AI hoặc cụm AI dựa trên GPU, yêu cầu cả hiệu suất và độ tin cậy từ Ceph RGW.

Kết luận

Chọn kiến trúc bộ cân bằng tải phù hợp là điều cần thiết để xây dựng một backend lưu trữ S3 mạnh mẽ, có thể mở rộng cho AI.

- Đối với các cụm AI riêng tư, sử dụng LVS TUN + conntrackd để tối đa hóa hiệu suất.

- Đối với các dịch vụ công cộng hoặc S3 đa người dùng, sử dụng HAProxy dựa trên Ingress để có tính linh hoạt và xử lý TLS tốt hơn.

Ambedded's UniVirStor giúp bạn triển khai cả hai kịch bản một cách hiệu quả với tinh chỉnh cấp sản xuất và hỗ trợ tính khả dụng cao.