Veeam-Backup und Archivierung zur Zusammenarbeit mit Ceph.

Diese Fallstudie erklärt, wie man das Mars 400 Ceph-Speichergerät als Backup-Repository für Veeam Backup und Replikation verwendet.

Ceph unterstützt Objektspeicher, Blockspeicher und das POSIX-Dateisystem alles in einem Cluster. Je nach Backup-Anforderungen können Kunden verschiedene Speicherprotokolle auswählen, um die Bedürfnisse verschiedener Speicher-Backup-Strategien zu unterstützen.

In diesem Artikel verwenden wir Ceph-Blockspeicher (Ceph RBD) und Ceph-Dateisystem (Cephfs) als Backup-Repository und vergleichen die Dauer ihrer Backup-Jobs beim Sichern von virtuellen Maschinen von Hyper-V und VMWare.

Backup-Lösungsarchitektur unter Verwendung von Veeam und Ceph

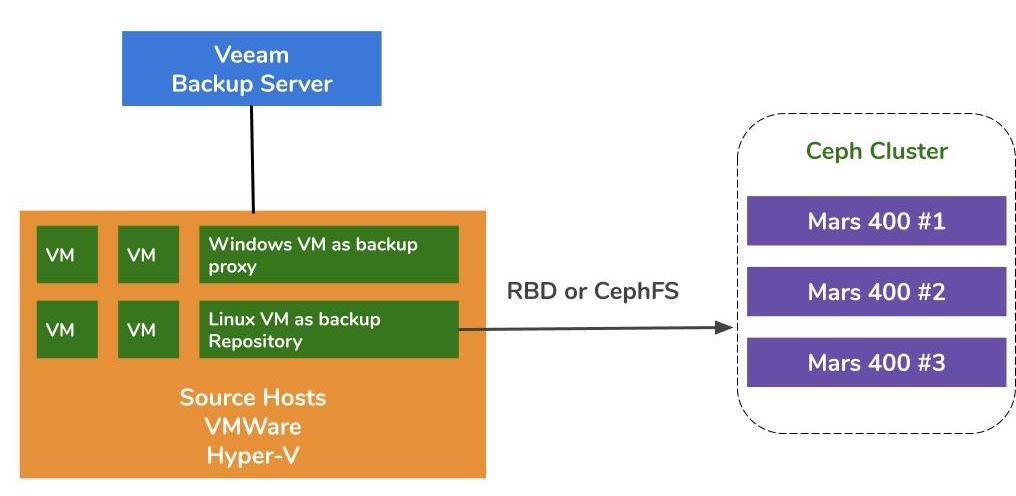

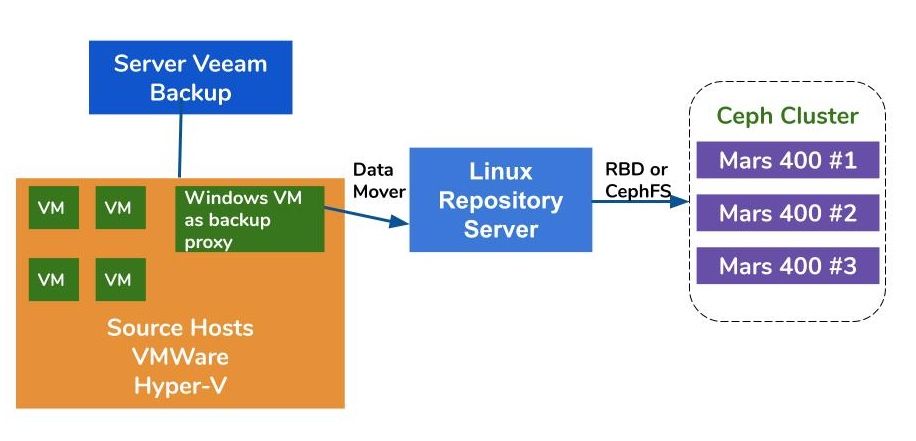

Die Architektur der Sicherung von virtuellen Maschinen auf VMWare und Hyper-V ist ähnlich. Veeam verwendet Datenbeweger, um Daten von Quellhosts zu Sicherungsrepositories zu übertragen. Die Datenbeweger werden auf dem Proxy-Server und dem Repository-Server ausgeführt. Um Ceph als Backend-Speicher eines Sicherungsrepositories zu verwenden, können Sie RBD oder CephFS auf einem physischen Linux-Server oder einer virtuellen Maschine als Repository-Server einbinden.

Wenn die Proxy- und Repository-Server virtuelle Maschinen innerhalb des Hypervisor-Clusters sind, können Sie von netzwerkfreiem Hochgeschwindigkeitsdatentransport zwischen VM-Disk, Proxy-Server und dem Repository-Server profitieren. Die beste Konfiguration eines großen Hypervisor-Clusters besteht darin, einen Proxy-Server-VM und einen Repository-Server-VM auf jedem VMWare-Host bereitzustellen. Alternativ können Sie eine Backup-Proxy-VM auf jedem VMWare-Host und einen Off-Host-Repository-Host bereitstellen, um die Arbeitslast von Ihrer Produktions-VMWare zu entfernen.

Es gibt drei Möglichkeiten, die Ambedded Ceph-Appliance als Speicherorte für Veeam Backup and Replication zu verwenden.CephFS und RBD-Blockgeräte können als lokale Backup-Speicher verwendet werden.Der S3-Objektspeicher kann als Kapazitätsebene für einen entfernten Standort verwendet werden.

Für die Einrichtung des Ceph RBD-Blockgeräts und des CephFS-Dateisystems als Backup-Repository von Veeam zur Sicherung von virtuellen Maschinen und Dateien finden Sie die Details im Whitepaper am Ende dieser Seite.

Testumgebung

Ceph Cluster

- Drei Mars 400 mit jeweils 3 Monitoren, 20 OSDs und 1 MDS (Metadatenserver)

- Jeder Ceph-Daemon wird auf einem Dual-Core Arm A72 Mikroserver ausgeführt

- Betriebssystem: CentOS 7

- Ceph-Software: Nautilus 14.2.9 Arm64

- Netzwerk: 4x 10Gb Netzwerk pro Mars 400

Veeam Backup & Replication 10, Version: 10.0.1.4854

Veeam Backup Server

- CPU: Intel Xeon E5-2630 2.3GHz DUAL

- DRAM: 64GB

- Netzwerk: 2x 10Gb sfp+ Verbindung

- Festplatte: 1TB für das System, 256GB SATA3 SSD für den Speicherbereich

- Windows Server 2019

Veeam Proxy Server

- Mit Veeam Backup Server zusammenstellen

Ablage Server

- Virtuelle Maschine

◇ CPU: 4 Kerne 2.3GHz

◇ DRAM: 8GB

◇ Netzwerk: Brücke

◇ Festplatte: 50GB virtuelle Festplatte

◇ Betriebssystem: CentOS 7.8.2003

- Bare-Metall-Server

◇ CPU: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ Netzwerk: 2-Port 10Gb sfp+ Verbindung

◇ Festplatte: 1TB für das System

◇ Betriebssystem: CentOS 7.6.1810

Hyper-V Gastgeber

◇ Prozessor: Intel Xeon E5-2630 2,3 GHz DUAL

◇ DRAM: 64GB

◇ Netzwerk: 2-Port 10Gb SFP+ Bonding

◇ Festplatte: 1TB für System

◇ Windows Server 2019

VMWare Gastgeber

◇ Prozessor: Intel Xeon E5-2630 2,3 GHz DUAL

◇ DRAM: 64GB

◇ Netzwerk: 2-Port 10Gb SFP+ Bonding

◇ Festplatte: 1TB für System

◇ ESXi 6.5

Netzwerk: 10GbE-Switch

Benchmark auf verschiedenen Setups

Um die Backup-Performance verschiedener Backup-Repositories zu benchmarken, haben wir Tests mit verschiedenen Backup-Repositories und drei Backup-Quellen durchgeführt.

Die Backup-Quellen, die wir für die Tests verwenden, sind ein auf einer Server basierendes SATA-SSD-basiertes Volume, eine Windows-VM von Hyper-V und eine CentOS 7-VM und eine Windows-VM von VMWare.

(1) Backup eines Volumes auf einer SSD-Festplatte

Tabelle 1. Backup eines Volumes von einem Server mit einer SATA-SSD.

| Festplattengröße (verarbeitete Daten) | 237,9 GB |

| Daten vom Quellgerät gelesen | 200,1 GB |

| Datenübertragung zu Ceph nach Deduplizierung und Kompression | 69,7GB |

| Deduplizierung | 1,3X |

| Kompression | 2,7X |

Tabelle 2.

|

Sicherung Ablageort |

Zeitspanne (Sek.) |

Quelle (%) |

Vermittler (%) |

Netzwerk (%) |

Ziel (%) |

Verarbeitung Rate (MB/s) |

Durchschnitt Daten schreiben Rate (MB/s) |

|

Linux VM, RBD-Replik 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linux VM, CephFS-Replik 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linux VM, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linux VM, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Linux Server, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Hinweis: Die durchschnittlichen Datenübertragungsraten werden durch die Datenübertragung geteilt durch die Dauer berechnet. Diese Raten repräsentieren die Arbeitslasten des Ceph-Clusters in diesen Backup-Jobs.

(2) Sichern einer Windows 10-VM auf Hyper-V auf HDD

In diesem Benchmark sichern wir eine Hyper-V-Instanz, die auf einer SATA-Festplatte gespeichert ist. Die Verarbeitungsraten dieser Aufgaben erreichen das obere Limit der HDD-Bandbreite. Wir können auch feststellen, dass der Engpass an der Quelle liegt, da ihre Lasten während 99% der Arbeitsdauer beschäftigt sind. Ceph-Cluster, das Ziel, die Arbeitslast von den Veeam-Backup-Jobs ist gering. Ceph-Cluster ist nur zu 6% bis 1% der Arbeitszeit beschäftigt.

Im Vergleich zum vorherigen Benchmark ist die Verarbeitungsrate des VM-Backups viel niedriger als die des SSD-Backups.Dies liegt hauptsächlich daran, dass die VM-Daten auf einer Festplatte gespeichert sind.

Tabelle 3.

| Festplattengröße (HDD) | 127GB |

| Daten vom Quellgerät gelesen | 37,9GB |

| Daten nach Ceph übertragen nach Deduplizierung und Komprimierung | 21,4GB |

| Deduplizierung | 3,3X |

| Kompression | 1,8X |

Tabelle 4. Sichern Sie ein virtuelles Maschinenimage auf einer SATA3-Festplatte

|

Sicherung Ablageort |

Zeitspanne (Sek.) |

Quelle (%) |

Vermittler (%) |

Netzwerk (%) |

Ziel (%) |

Verarbeitung Rate (MB/s) |

Durchschnitt Daten schreiben Rate (MB/s) |

|

Linux VM, RBD-Volume, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linux VM, CephFS Volumen, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58,1 |

|

Linux Server, RBD-Volume, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Hinweis: Die durchschnittlichen Datenübertragungsraten werden durch die Datenübertragung geteilt durch die Dauer berechnet. Diese Raten repräsentieren die Arbeitslasten des Ceph-Clusters in diesen Backup-Jobs.

(3)Sichern Sie virtuelle Maschinen auf ESXi auf HDD

Dieser Test sichert eine CentOS 7 und eine Windows 10 Virtual Machine, die auf einer HDD des VMWare ESXi 6.5 Hosts ausgeführt werden, in ein Repository, das von einem Ceph RBD mit 4+2 Erasure Code-Schutz unterstützt wird.

Tabelle 5.

| Quelle | CentOS VM | Windows 10 VM |

| Festplattengröße (HDD) | 40GB | 32GB |

| Daten vom Quellgerät gelesen | 1,8GB | 12,9GB |

| Daten nach Ceph übertragen nach Deduplizierung und Komprimierung | 966MB | 7,7GB |

| Deduplizierung | 22,1X | 2,5X |

| Kompression | 1,9X | 1,7X |

Tabelle 6.

|

Sicherung Quelle |

Zeitspanne (Sek.) |

Quelle (%) |

Vermittler (%) |

Netzwerk (%) |

Ziel (%) |

Verarbeitung Rate (MB/s) |

Durchschnitt Daten schreiben Rate (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Hinweis: Die durchschnittlichen Datenübertragungsraten werden durch die Datenübertragung geteilt durch die Dauer berechnet. Diese Raten repräsentieren die Arbeitslasten des Ceph-Clusters in diesen Backup-Jobs.

Schlussfolgerungen

Laut den Testergebnissen haben Ceph RBD und CephFS eine ähnliche Leistung. Dies entspricht unserer Erfahrung hinsichtlich der Leistungsbewertung von RBD und CephFS. Beim Vergleich der Eigenschaften von CephFS und RBD haben sie ihre Vor- und Nachteile. Wenn Sie mehrere Repository-Server bereitstellen müssen, müssen Sie für jeden Backup-Repository-Server ein RBD-Image erstellen, da Sie Ceph RBD nur auf einem Host mounten können. Im Vergleich zu CephFS ist die Verwendung von RBD einfacher, da es keine Metadataserver benötigt. Wir müssen die RBD-Kapazitätsgröße bei der Erstellung zuweisen, daher müssen Sie die Kapazität anpassen, wenn Sie mehr Platz benötigen.

Wenn Sie CephFS als Repository verwenden, müssen Sie mindestens einen Metadatenserver (MDS) im Ceph-Cluster bereitstellen. Wir benötigen auch einen Standby-Metadatenserver für hohe Verfügbarkeit. Im Vergleich zum Ceph RBD müssen Sie dem Dateisystem keine Quote geben. Sie können CephFS also als unbegrenzten Speicherpool behandeln.

In dieser Use-Case-Demonstration sichern unsere Tests nur eine VM pro Sicherungsauftrag. Gemäß den oben genannten Testberichten wissen wir, dass die durchschnittliche Datenschreibrate mit der Verarbeitungsrate und der Effizienz der Daten-Deduplizierung und -Komprimierung zusammenhängt. Eine schnellere Quelldiskette verringert die Dauer des Sicherungsauftrags und führt zu einer schnelleren Verarbeitungsrate. Je nach Infrastruktur der Benutzer können mehrere gleichzeitige Aufträge eingesetzt werden, um verschiedene Objekte gleichzeitig zu sichern. Ceph-Speicher unterstützt sehr gut mehrere gleichzeitige Aufträge.

Ein 20x HDD OSD Ceph-Cluster, der von 3x Ambedded Mars 400 betrieben wird, kann eine aggregierte Schreibdurchsatz von bis zu 700 MB/s für den 4+2-Löschcode-Pool bieten. Durch die Bereitstellung mehrerer aktueller Sicherungsaufträge wird die Gesamtdauer der Sicherung reduziert. Die maximale Leistung eines Ceph-Clusters ist nahezu proportional zur Gesamtzahl der Festplattenlaufwerke im Cluster.

In diesem Anwendungsfall haben wir die Verwendung von S3-Objektspeicher als Backup-Repository nicht getestet. S3-Objektspeicher kann als Kapazitätsebene im Veeam Scale-Out-Backup-Repository und als Zielarchiv-Repository für NAS-Backups verwendet werden. Sie können ganz einfach ein RADOS-Gateway einrichten und Objektspeicherbenutzer mithilfe des Ambedded UVS-Managers, der Ceph-Management-Web-GUI, erstellen.

- Herunterladen

Verwenden Sie Ceph als Repository für das Veeam Backup & Replication Whitepaper

Wie man das Ceph RBD-Blockgerät und das CephFS-Dateisystem als Backup-Repository von Veeam für die Sicherung von virtuellen Maschinen und Dateien einrichtet

Download- Verwandte Produkte

Mars 400PRO Ceph-Speichergerät

Mars 400PRO

Mars 400 Ceph Appliance wurde entwickelt, um den hohen Kapazitätsbedarf für cloudbasierten Datenspeicher zu erfüllen. Es nutzt HDD, um von den niedrigen...

Einzelheiten