Veeam sauvegarde et archive pour travailler avec Ceph.

Cette étude de cas explique comment utiliser l'appareil de stockage ceph Mars 400 comme dépôts de sauvegarde pour Veeam Backup et Réplication.

Ceph prend en charge le stockage d'objets, le stockage en bloc et le système de fichiers POSIX, le tout dans un seul cluster. Selon les exigences de sauvegarde, les clients peuvent sélectionner différents protocoles de stockage pour répondre aux besoins de diverses stratégies de sauvegarde.

Dans cet article, nous utilisons le stockage en bloc Ceph (Ceph RBD) et le système de fichiers Ceph (Cephfs) comme dépôts de sauvegarde et comparons leurs durées de travail de sauvegarde des machines virtuelles depuis Hyper-V et VMWare.

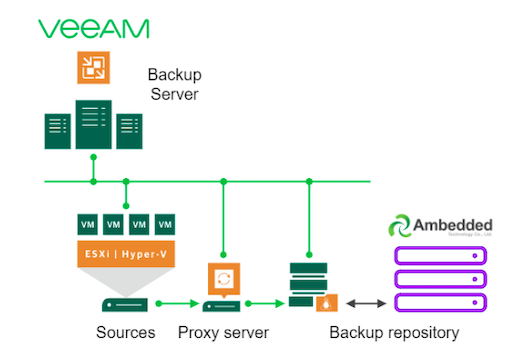

Architecture de solution de sauvegarde en utilisant Veeam et Ceph

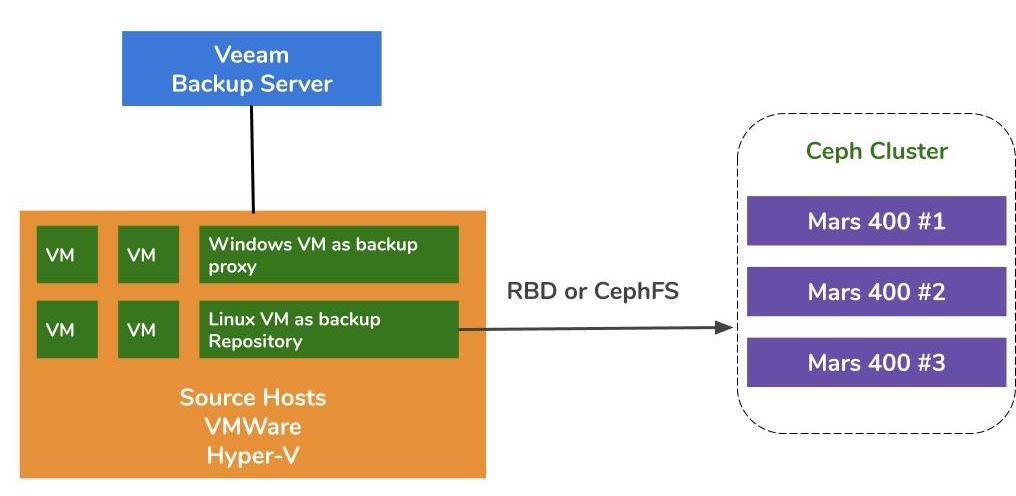

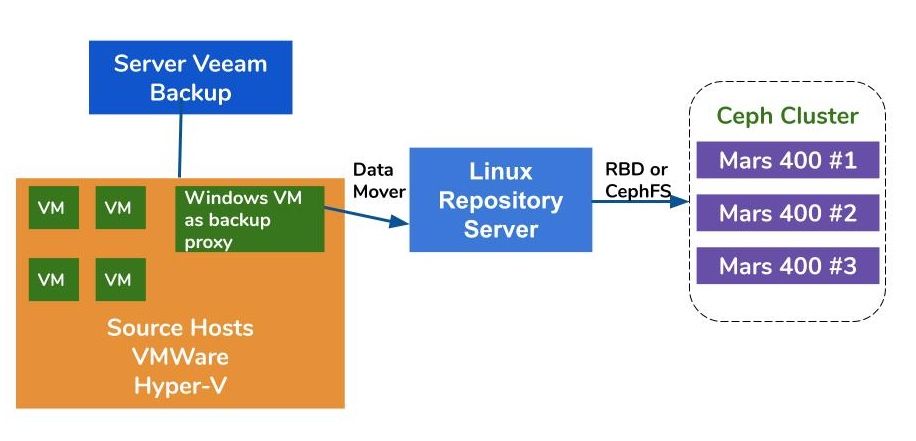

L'architecture de sauvegarde des machines virtuelles sur VMWare et Hyper-V est similaire. Veeam utilise des transferts de données pour transférer les données des hôtes sources vers les référentiels de sauvegarde. Les transferts de données s'exécutent sur le serveur proxy et le serveur de référentiel. Pour utiliser Ceph comme stockage de sauvegarde d'un référentiel, vous pouvez monter RBD ou CephFS sur un serveur physique ou une machine virtuelle Linux en tant que serveur de référentiel.

Si les serveurs proxy et de dépôt sont des machines virtuelles à l'intérieur du cluster hyperviseur, vous pouvez bénéficier d'un transport de données à haute vitesse sans réseau entre le disque de la machine virtuelle, le serveur proxy et le serveur de dépôt. La meilleure configuration d'un grand cluster hyperviseur consiste à déployer une machine virtuelle de serveur proxy et une machine virtuelle de serveur de référentiel sur chaque hôte VMWare. Sinon, vous pouvez déployer une machine virtuelle de proxy de sauvegarde sur chaque hôte VMWare et un hôte de référentiel externe pour alléger la charge de travail de vos machines virtuelles de production VMWare.

Il existe trois façons d'utiliser l'appliance Ceph Ambedded comme référentiels pour Veeam Backup and Replication.CephFS et les dispositifs de bloc RBD peuvent être utilisés comme référentiel de sauvegarde sur site.Le stockage d'objets S3 peut être utilisé comme niveau de capacité pour un emplacement distant.

Pour savoir comment configurer le périphérique de bloc Ceph RBD et le système de fichiers CephFS en tant que dépôt de sauvegarde de Veeam pour la sauvegarde des machines virtuelles et des fichiers, vous pouvez trouver les détails dans le livre blanc à la fin de cette page.

Environnement de Test

Grappe Ceph

- Trois Mars 400 avec 3x écrans, 20 OSDs, et 1x MDS (serveur de métadonnées)

- Chaque démon Ceph fonctionne sur un microserveur Arm A72 bicœur

- Système d'Exploitation: CentOS 7

- Logiciel Ceph: Nautilus 14.2.9 Arm64

- Réseau: 4x 10Gb réseau par Mars 400

Veeam Sauvegarde & Réplication 10, Version: 10.0.1.4854

Serveur de Sauvegarde Veeam

- CPU : Intel Xeon E5-2630 2.3GHz DOUBLE

- DRAM : 64GB

- Réseau : 2x 10Gb sfp+ en agrégation de lien

- Disque : 1TB pour le système, 256GB SSD SATA3 pour le volume

- Windows Server 2019

Serveur Proxy Veeam

- Colocaliser avec le Serveur de Sauvegarde Veeam

Serveur de Référentiel

- Machine Virtuelle

◇ CPU : 4 cœurs 2.3GHz

◇ DRAM : 8GB

◇ Réseau : pont

◇ Disque : disque virtuel de 50GB

◇ OS : CentOS 7.8.2003

- Serveur Baremetal

◇ CPU : Intel Xeon X5650 2.67GHz DUAL

◇ DRAM : 48GB

◇ Réseau : 2-port 10Gb sfp+ en liaison

◇ Disque : 1TB pour le système

◇ OS : CentOS 7.6.1810

Hôte Hyper-V

◇ Processeur : Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM : 64 Go

◇ Réseau : Liaison 10Gb sfp+ à 2 ports

◇ Disque : 1 To pour le système

◇ Serveur Windows 2019

Hôte VMWare

◇ Processeur : Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM : 64 Go

◇ Réseau : Liaison 10Gb sfp+ à 2 ports

◇ Disque : 1 To pour le système

◇ ESXi 6.5

Réseau : commutateur 10GbE

Benchmarck sur différents configurations

Pour évaluer les performances de sauvegarde de différents référentiels de sauvegarde, nous avons mis en place des tests avec différents référentiels de sauvegarde et trois sources de sauvegarde.

Les sources de sauvegarde que nous utilisons pour les tests sont un volume basé sur un SSD SATA sur un serveur, une machine virtuelle Windows de Hyper-V, et une machine virtuelle CentOS 7 et une machine virtuelle Windows de VMWare.

(1) Sauvegarder un volume sur un disque SSD

Tableau 1. Sauvegarder un volume à partir d'un serveur avec un SSD SATA.

| Taille du disque (Données traitées) | 237,9 Go |

| Données lues depuis la source | 200,1 Go |

| Transfert de données vers Ceph après déduplication et compression | 69,7GB |

| Déduplication | 1,3X |

| Compression | 2,7X |

Table 2.

|

Sauvegarde Dépôt |

Durée (sec) |

Source (%) |

Mandataire (%) |

Réseau (%) |

Cible (%) |

Traitement Débit (MB/s) |

Moyenne Écriture des données Débit (MB/s) |

|

Machine virtuelle Linux, Réplique RBD 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Machine virtuelle Linux, Réplique CephFS 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Machine virtuelle Linux, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Machine virtuelle Linux, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Serveur Linux, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Note : Les taux moyens d'écriture de données sont calculés en divisant les données transférées par la durée. Ces taux représentent les charges de travail du cluster Ceph dans ces tâches de sauvegarde.

(2) Sauvegarder une machine virtuelle Windows 10 sur Hyper-V sur un disque dur

Dans ce benchmark, nous sauvegardons une instance Hyper-V stockée sur un disque dur SATA. Les taux de traitement de ces emplois atteignent la limite supérieure de la bande passante du disque dur. Nous pouvons également constater que le goulot d'étranglement se trouve à la source car leurs charges sont occupées pendant 99% de la durée du travail. Cluster Ceph, la cible, la charge de travail des tâches de sauvegarde Veeam est légère. Le cluster Ceph est occupé seulement de 6% à 1% du temps de travail.

Comparé au précédent test de référence, le taux de traitement de la sauvegarde de la machine virtuelle est beaucoup plus bas que celui de la sauvegarde SSD.Cela est principalement dû au fait que les données de la machine virtuelle sont stockées sur un disque dur.

Tableau 3.

| Taille du disque (HDD) | 127 Go |

| Données lues depuis la source | 37,9 Go |

| Données transférées vers Ceph après Déduplication et Compression | 21,4 Go |

| Déduplication | 3,3X |

| Compression | 1,8X |

Tableau 4. Sauvegarde d'une image de machine virtuelle sur un disque dur SATA3

|

Sauvegarde Dépôt |

Durée (sec) |

Source (%) |

Mandataire (%) |

Réseau (%) |

Cible (%) |

Traitement Débit (MB/s) |

Moyenne Écriture des données Débit (MB/s) |

|

Machine virtuelle Linux, Volume RBD, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Machine virtuelle Linux, Volume CephFS, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Serveur Linux, Volume RBD, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Note : Les taux moyens d'écriture de données sont calculés en divisant les données transférées par la durée. Ces taux représentent les charges de travail du cluster Ceph dans ces tâches de sauvegarde.

(3)Sauvegarde des machines virtuelles sur ESXi sur disque dur

Ce test sauvegarde une machine virtuelle CentOS 7 et une machine virtuelle Windows 10 exécutées sur un disque dur d'un hôte VMWare ESXi 6.5 vers un référentiel soutenu par un Ceph RBD avec une protection de code d'effacement 4+2.

Tableau 5.

| Source | VM CentOS | VM Windows 10 |

| Taille du disque (HDD) | 40GB | 32GB |

| Données lues depuis la source | 1,8GB | 12,9GB |

| Données transférées vers Ceph après Déduplication et Compression | 966MB | 7,7GB |

| Déduplication | 22,1X | 2,5X |

| Compression | 1.9X | 1.7X |

Tableau 6.

|

Sauvegarde Source |

Durée (sec) |

Source (%) |

Mandataire (%) |

Réseau (%) |

Cible (%) |

Traitement Débit (MB/s) |

Moyenne Écriture des données Débit (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Note : Les taux moyens d'écriture de données sont calculés en divisant les données transférées par la durée. Ces taux représentent les charges de travail du cluster Ceph dans ces tâches de sauvegarde.

Conclusions

Selon les résultats du test, Ceph RBD et CephFS ont des performances similaires. Cela correspond à notre expérience en ce qui concerne les performances de référence de RBD et CephFS. En comparant les caractéristiques de CephFS et RBD, ils ont leurs avantages et leurs inconvénients. Si vous avez besoin de déployer plusieurs serveurs de dépôt, vous devez créer une image RBD pour chaque serveur de dépôt de sauvegarde car vous ne pouvez monter Ceph RBD que sur un seul hôte. Comparé à CephFS, l'utilisation de RBD est plus simple car il n'a pas besoin de serveurs de métadonnées. Nous devons attribuer la taille de la capacité RBD lors de sa création, vous devez donc redimensionner sa capacité lorsque vous avez besoin de plus d'espace.

Si vous utilisez CephFS comme référentiel, vous devez déployer au moins un serveur de métadonnées (MDS) dans le cluster Ceph. Nous avons également besoin d'un serveur de métadonnées de secours pour une haute disponibilité. Comparé au Ceph RBD, vous n'avez pas besoin de donner au système de fichiers un quota. Ainsi, vous pouvez considérer le CephFS comme un pool de stockage illimité.

Dans cette démonstration de cas d'utilisation, nos tests sauvegardent uniquement une machine virtuelle dans chaque tâche de sauvegarde. Selon les rapports de test ci-dessus, nous savons que le taux d'écriture des données moyennes est lié au taux de traitement et à l'efficacité de la déduplication et de la compression des données. Un disque source plus rapide réduit la durée de la tâche de sauvegarde et entraîne un taux de traitement plus rapide. Selon l'infrastructure des utilisateurs, ces derniers peuvent déployer plusieurs tâches simultanées pour sauvegarder différents objets en même temps. Le stockage Ceph fonctionne très bien en prenant en charge plusieurs tâches simultanées.

Un cluster Ceph OSD HDD 20x alimenté par 3x Ambedded Mars 400 peut offrir jusqu'à 700 Mo/s de débit d'écriture agrégé au pool de code d'effacement 4+2. Le déploiement de plusieurs tâches de sauvegarde actuelles permet de réduire la durée globale de sauvegarde. Les performances maximales d'un cluster Ceph sont presque proportionnelles au nombre total de disques dans le cluster.

Dans ce cas d'utilisation, nous n'avons pas testé l'utilisation du stockage d'objet S3 en tant que référentiel de sauvegarde. Le stockage d'objet S3 peut être utilisé comme couche de capacité dans le référentiel de sauvegarde échelonné de Veeam et comme référentiel d'archive cible pour la sauvegarde NAS. Vous pouvez facilement configurer une passerelle RADOS et créer des utilisateurs de stockage d'objet facilement en utilisant le gestionnaire UVS Ambedded, l'interface web de gestion de Ceph.

- Télécharger

Utiliser Ceph comme dépôt pour le livre blanc de Veeam Backup & Replication

Comment configurer le dispositif de bloc Ceph RBD et le système de fichiers CephFS comme dépôt de sauvegarde de Veeam pour sauvegarder des machines...

Télécharger- Produits associés

Appareil de stockage Ceph Mars 400PRO

Mars 400PRO

L'appliance Mars 400 Ceph est conçue pour répondre aux besoins de stockage de données cloud-native à haute capacité. Il utilise un disque dur pour...

Détails