Veeam 備份與歸檔與 Ceph 的整合

本案例研究說明如何使用 Mars 400 Ceph 儲存一體機作為 Veeam Backup & Replication 的備份存放庫。

Ceph 在單一叢集中同時支援物件儲存、區塊儲存和 POSIX 檔案系統。客戶可以根據備份需求,選擇不同的儲存協定,以支援各種儲存備份策略。

在這篇文章中,我們將使用 Ceph 區塊儲存 (Ceph RBD) 和 Ceph 檔案系統 (CephFS) 作為備份儲存庫,並比較從 Hyper-V 與 VMware 備份虛擬機時的備份作業耗時。

採用Veeam 與 Ceph 備份解決方案架構

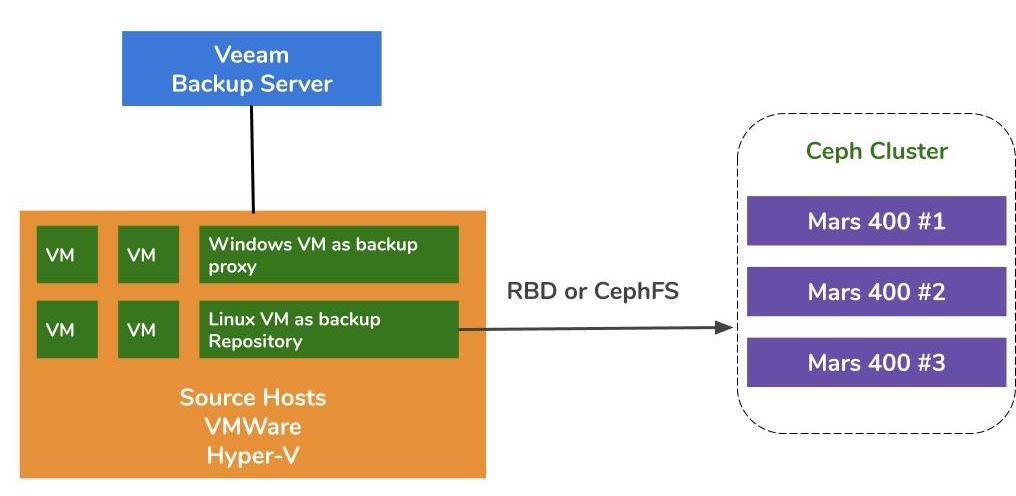

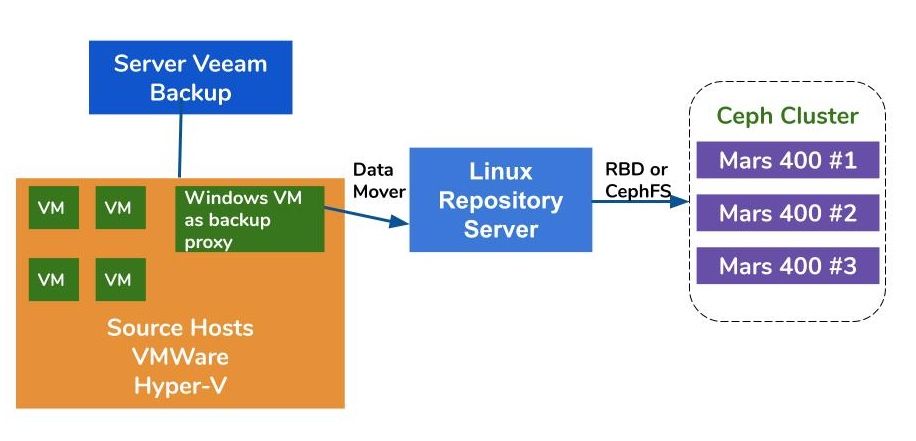

在 VMware 與 Hyper-V 上備份虛擬機的架構相似。Veeam 透過資料搬運程式 (data mover) 將資料從來源主機傳輸至備份儲存庫。這些資料搬運程式執行於 Proxy 伺服器與 Repository 伺服器上。若要以 Ceph 作為備份儲存庫的後端儲存,可在 一台 Linux 實體伺服器或虛擬機上掛載 RBD 或 CephFS,並將其作為 Repository 伺服器使用。

若 Proxy 與 Repository 伺服器以虛擬機 (VM) 形式部署在同一個虛擬化叢集中,便可在 VM 磁碟、Proxy 伺服器與 Repository 伺服器之間享有免經網路 (network-free) 的高速資料傳輸。對於大型虛擬化叢集,最佳做法是在每台 VMware 主機上各部署一台 Proxy Server VM 與一台 Repository Server VM。或者,也可在每台 VMware 主機上部署一台備份 Proxy VM,並額外部署一台外部 (off-host) Repository 主機,以將工作負載從生產用 VMware 環境中移出。

將 Ambedded Ceph 一體機作為 Veeam Backup & Replication 的備份存放庫有三種方式。 CephFS 和 RBD 區塊設備 可以被用作本地備份儲存庫。S3 物件儲存 可作為異地據點的容量層。

關於如何設定 Ceph RBD 區塊設備和 CephFS 檔案系統,使其成為 Veeam 備份虛擬機器和檔案的備份儲存庫,詳細說明請參閱本頁最下方的白皮書。

測試環境

Ceph 叢集

- 三台 Mars 400,配置 3 個 Monitor (監控節點) 、20 個 OSD,以及 1 個 MDS (中繼資料伺服器) 。

- 每個 Ceph 守護程式 (daemon) 都運行在一個雙核心的 Arm A72 微伺服器上。

- 作業系統 : CentOS 7

- Ceph 軟體 : Nautilus 14.2.9 Arm64

- 網路 : 每台 Mars 400 具備 4 個 10Gb 網路介面

Veeam Backup & Replication 10, 版本 : 10.0.1.4854

Veeam 備份伺服器

- CPU : Intel Xeon E5-2630 2.3GHz DUAL

- DRAM : 64GB

- 網路 : 2個 10Gb SFP+ 埠,採用連結聚合 (bonding)

- 磁碟 : 1TB 作為系統碟;256GB SATA3 SSD 作為資料卷 (volume) 。

- Windows Server 2019

Veeam 代理伺服器

- 與 Veeam 備份伺服器同機部署

儲存庫伺服器 (Repository Server)

- 虛擬機器 (VM)

◇ CPU: 4 核心 2.3GHz

◇ DRAM: 8GB

◇ 網路: 橋接 (bridge)

◇ 磁碟: 50GB 虛擬磁碟

◇ 作業系統: CentOS 7.8.2003

- 裸機伺服器 (Baremetal Server)

◇ CPU: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ 網路: 2個 10Gb SFP+ 埠,採用連結聚合 (bonding)

◇ 磁碟: 1TB 用於系統

◇ 作業系統: CentOS 7.6.1810

Hyper-V 主機

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ 網路: 2個 10Gb SFP+ 埠,採用連結聚合 (bonding)

◇ 磁碟: 1TB 用於系統

◇ Windows Server 2019

VMWare 主機

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ 網路: 2個 10Gb SFP+ 埠,採用連結聚合 (bonding)

◇ 磁碟: 1TB 用於系統

◇ ESXi 6.5

網路: 10GbE 交換器

各項設定的效能測試

為了對不同備份儲存庫的備份效能進行基準測試,我們以不同的備份儲存庫與三個備份來源來設置測試。

我們在測試中使用的備份來源包括:伺服器上基於 SATA SSD 的儲存卷、一台 Hyper-V 的 Windows 虛擬機器,以及兩台來自 VMWare 的虛擬機器 (一台為 CentOS 7,另一台為 Windows) 。

(1) 備份SSD 磁碟上的資料卷 (volume)

表 1. 備份來自帶有 SATA SSD

的伺服器上的資料卷。

| 磁碟大小 (已處理資料量) | 237.9GB |

| 從來源讀取的資料 | 200.1GB |

| 經過重複資料刪除和壓縮後傳輸至 Ceph 的資料 | 69.7GB |

| 重複資料刪除 | 1.3X |

| 壓縮 | 2.7X |

表 2.

| 備份儲存庫 |

耗時 (秒) | 來源 (%) | Proxy (%) | 網路 (%) | 目標 (%) | 傳輸速率 (MB/s) |

平均資料 寫入速率 (MB/s) |

| Linux VM, RBD-3副本 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

| Linux

VM, CephFS-3副本 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

| Linux VM, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

| Linux VM, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

| Linux Server, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

註: 平均資料寫入速率是以「傳輸的資料量 (Data Transferred) 」除以「耗時 (Duration) 」計算得出。這些速率代表 Ceph 叢集在這些備份作業中的工作負載。

(2) 備份在 Hyper-V 上運行、存放於 HDD 的 Windows 10 虛擬機器 (VM)

在這項基準測試中,我們備份了儲存在 SATA 硬碟上的 Hyper-V 實例。這些備份工作的處理速率達到了 HDD 頻寬的上限,同時可見瓶頸出現在來源端,因為在備份期間的 99% 期間其負載都處於忙碌狀態。相比之下,作為目標端的 Ceph 叢集承受的 Veeam 備份作業負載很輕,僅有約 1% ~ 6% 的時間處於忙碌。

與之前的基準測試相比, VM 備份的處理速率遠低於 SSD 的備份。這主要是因為 VM 的資料儲存在 HDD 中。

表 3.

| 磁碟大小 (HDD) | 127GB |

| 從來源讀取的資料 | 37.9GB |

| 經過重複資料刪除與壓縮 後傳輸至 Ceph 的資料 | 21.4GB |

| 重複資料刪除 | 3.3X |

| 壓縮 | 1.8X |

表 4. 在 SATA3 硬碟上備份虛擬機器映像檔

| 備份儲存庫 |

耗時 (秒) |

來源 (%) |

Proxy (%) |

網路 (%) |

目標 (%) | 傳輸速率 (MB/s) | 平均資料 寫入速率 (MB/s) |

| Linux VM, RBD volume, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

| Linux VM, CephFS volume, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

| Linux

Server, RBD volume, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

註: 平均資料寫入速率以「傳輸的資料量 (Data Transferred) 」除以「耗時 (Duration) 」計算。這些速率代表 Ceph 叢集在這些備份作業中的工作負載。

(3) 在 ESXi 上、存放於 HDD 的虛擬機器備份

本測試將把在 VMware ESXi 6.5 主機之 HDD 上運行的 CentOS 7 與 Windows 10 虛擬機,備份至以 Ceph RBD 為後端、採 4+2

糾刪碼 保護的儲存庫。

表 5.

| 來源 | CentOS VM | Windows 10 VM |

| 磁碟大小 (HDD) | 40GB | 32GB |

| 從來源讀取的資料 | 1.8GB | 12.9GB |

| 經過重複資料刪除與壓縮 後傳輸至 Ceph 的資料 | 966MB | 7.7GB |

| 重複資料刪除 | 22.1X | 2.5X |

| 壓縮 | 1.9X | 1.7X |

表 6.

| 備份來源 |

耗時 (秒) | 來源 (%) |

Proxy (%) |

網路 (%) |

目標 (%) | 傳輸速率 (MB/s) | 平均資料 寫入速率 (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

註: 平均資料寫入速率以「傳輸的資料量 (Data Transferred) 」除以「耗時 (Duration) 」計算。這些速率代表 Ceph 叢集在這些備份作業中的工作負載。

結論

根據測試結果,Ceph RBD 和 CephFS 的效能相近,這與我們在 RBD 和 CephFS 效能基準測試方面的經驗相符。比較 CephFS 和 RBD 的特性,它們各有優缺點。如果你需要部署多台儲存庫伺服器,由於 Ceph RBD 只能掛載在單一主機上,因此你必須為每台備份儲存庫伺服器建立一個 RBD 映像。 相較於 CephFS,使用 RBD 較為簡單,因為它不需要中繼資料伺服器 (MDS) 。然而,在建立 RBD 時,我們必須指定其容量大小,當你需要更多空間時,就必須手動調整其容量。

如果你使用 CephFS 作為儲存庫,你必須在 Ceph 叢集中至少部署一台中繼資料伺服器 (MDS) ,並且為了實現高可用性,我們也需要一個備援的中繼資料伺服器。與 Ceph RBD 相比,你不需要為檔案系統設定配額,因此可以將 CephFS 視為一個無上限的儲存池。

在此使用案例示範中,我們的測試在每個備份工作中只備份一台 VM。根據上述測試報告我們得知平均資料寫入速率與處理速率以及重複資料刪除與壓縮效率有關。來源磁碟速度越快,備份工作的持續時間越短,處理速率也越快。依使用者的基礎架構配置,使用者可以併行多個備份作業,同時備份不同物件。Ceph 儲存系統支援多個並行作業方面表現優異。

由 3 台 Ambedded Mars 400 組成、含 20 顆 HDD OSD Ceph 叢集,對 4+2 糾刪碼儲存池提供高達 700MB/s 的總寫入吞吐量。部署多個並行備份作業的好處在於能縮短整體備份持續時間。Ceph 叢集的最大效能幾乎與叢集中硬碟的總數呈線性正比關係。

在此使用案例中,我們並未測試使用 S3 物件儲存作為備份儲存庫。S3 物件儲存可用於 Veeam Scale-Out 備份儲存庫的「容量層(capacity tier)」以及可作為 NAS 備份的「目標歸檔儲存庫 (target archive repository) 」。您可以使用 Ambedded UVS Manager (Ceph Web 管理介面) 輕鬆部署 RADOS Gateway 並建立物件儲存使用者。

- 下載

使用 Ceph 作為 Veeam Backup & Replication 儲存庫的白皮書

如何將 Ceph RBD 區塊設備與 CephFS 檔案系統設定為 Veeam 的備份儲存庫,以備份虛擬機與檔案。

下載