Bagaimana kinerja lapisan cache Ceph?

Pendahuluan:

Dalam postingan ini, kami membagikan pengujian benchmark untuk menunjukkan bagaimana lapisan cache Ceph dapat meningkatkan kinerja kumpulan HDD dengan menetapkan lapisan cache yang didukung oleh kumpulan NVMe.

Apa itu Ceph Cache Tier dan Bagaimana Cara Kerjanya

Tier cache Ceph memungkinkan penggunaan perangkat penyimpanan yang lebih cepat sebagai cache untuk yang lebih lambat. Ini melibatkan pembuatan kumpulan perangkat penyimpanan cepat/mahal (seperti NVMe SSD) yang dikonfigurasi untuk berfungsi sebagai tingkat cache, dan kumpulan perangkat penyimpanan yang lebih lambat/lebih murah (seperti HDD) yang dikonfigurasi untuk berfungsi sebagai tingkat penyimpanan ekonomis. Tier cache menyimpan data yang sering diakses dari tier pendukung dan melayani permintaan baca dan tulis dari klien. Agen penataan cache secara berkala mengosongkan atau mengeluarkan objek dari lapisan cache berdasarkan kebijakan tertentu.

Demo Tingkat Cache Ceph

Di masa lalu, ketika menggunakan SATA SSD sebagai perangkat penyimpanan lapisan cache, peningkatan kinerja yang dihasilkan dari penggunaan lapisan cache tersebut tidak signifikan. Saat ini, biaya NVMe SSD telah turun banyak dibandingkan beberapa tahun yang lalu, dan kinerja NVMe SSD jauh lebih cepat dibandingkan HDD. Kami ingin mengetahui apakah penggunaan NVMe SSD sebagai lapisan cache dapat sangat membantu dalam sebuah pool HDD.

Untuk menguji efektivitas lapisan cache NVMe, kami melakukan pengujian untuk melihat apakah lapisan cache meningkatkan kinerja dari kumpulan penyimpanan berbasis HDD.

Pengaturan Kluster

| Host NVME | 3 x Ambedded Mars500 Ceph Appliances |

| Spesifikasi dari setiap perangkat Mars 500 | |

| CPU | 1x Ampere Altra Arm 64-Core 3.0 Ghz |

| Memori | 96 GiB DDR4 |

| Jaringan | 2 port 25Gbps Mellanox ConnectX-6 |

| Drive OSD | 8 x Micron 7400 960GB |

| Host HDD | 3 x Ambedded Mars400 Ceph Appliances |

| Spesifikasi dari setiap alat Mars 400 | |

| CPU | 8 node Quad-Cores Arm64 1.2 GHz |

| Memori | 4GiB per node. 32 GiB per alat |

| Jaringan | 2 x 2.5Gbps per node. 2x 10 Gb uplink melalui switch di dalam chassis. |

| Drive OSD | 8 x 6 TB Seagate Exos HDD |

Informasi Klaster Ceph

- 24 x OSD pada NVMe SSD (3x perangkat Ambedded Mars500)

- 24x OSD pada HDD (3x perangkat Ambedded Mars400)

- Server HDD dan NVMe terletak di root CRUSH yang terpisah.

Klien Uji

- 2 x server fisik. 2x kartu jaringan 25Gb

- Setiap server menjalankan 7x VM.

- Setiap VM memiliki 4x inti dan 8 GB memori

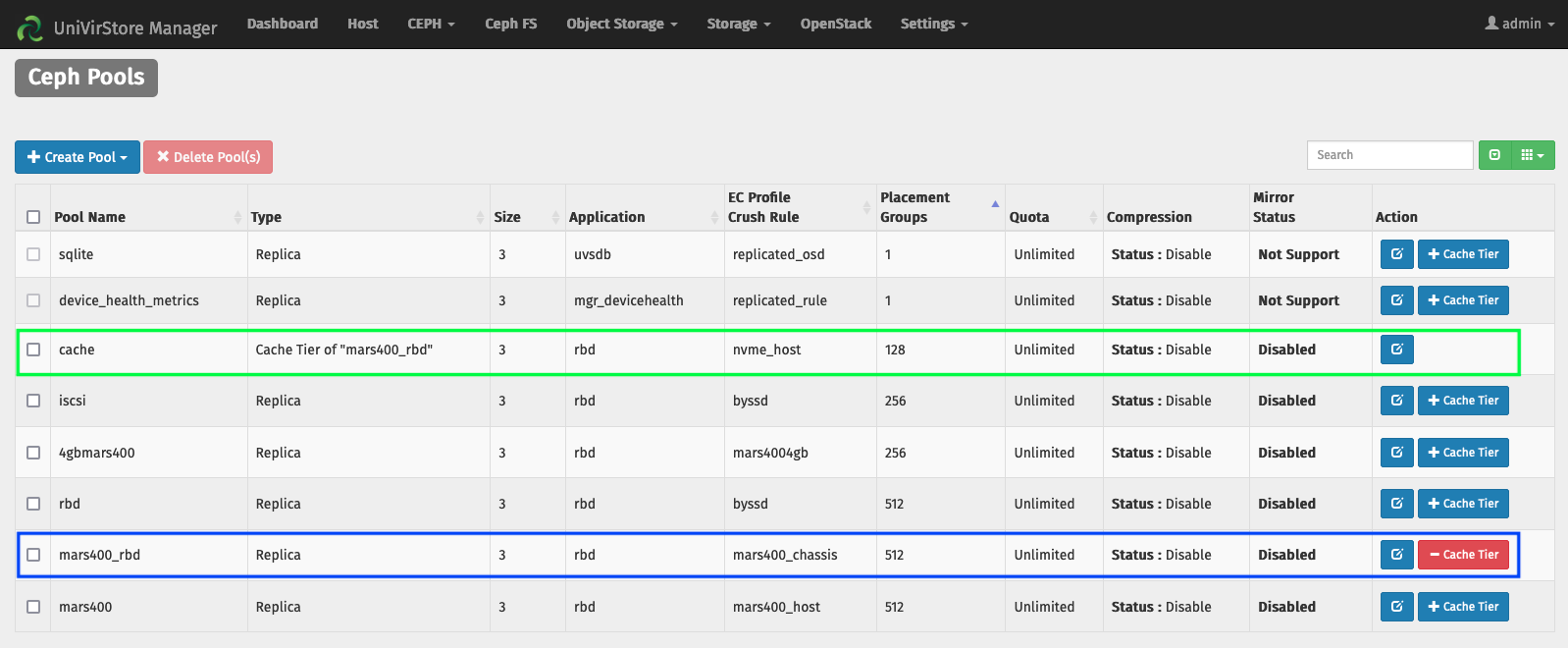

Menyiapkan Cache Tier oleh manajer Ambedded UVS

1. Buat pool dasar dengan menggunakan osd HDD.

2. Buat pool NVMe menggunakan osd SSD NVMe.

3. Tambahkan pool NVMe sebagai tier cache dari pool HDD.

konfigurasi tier cache default:

- Mode cache: writeback

- hit_set_count = 12

- hit_set_period = 14400 detik (4 jam)

- target_max_byte = 2 TiB

- target_max_objects = 1 juta

- min_read_recency_for_promote & min_write_recency_for_promote = 2

- cache_target_dirty_ratio = 0.4

- cache_target_dirty_high_ratio = 0.6

- cache_target_full_ratio = 0.8

- cache_min_flush_age = 600 detik.

- cache_min_evict_age = 1800 detik.

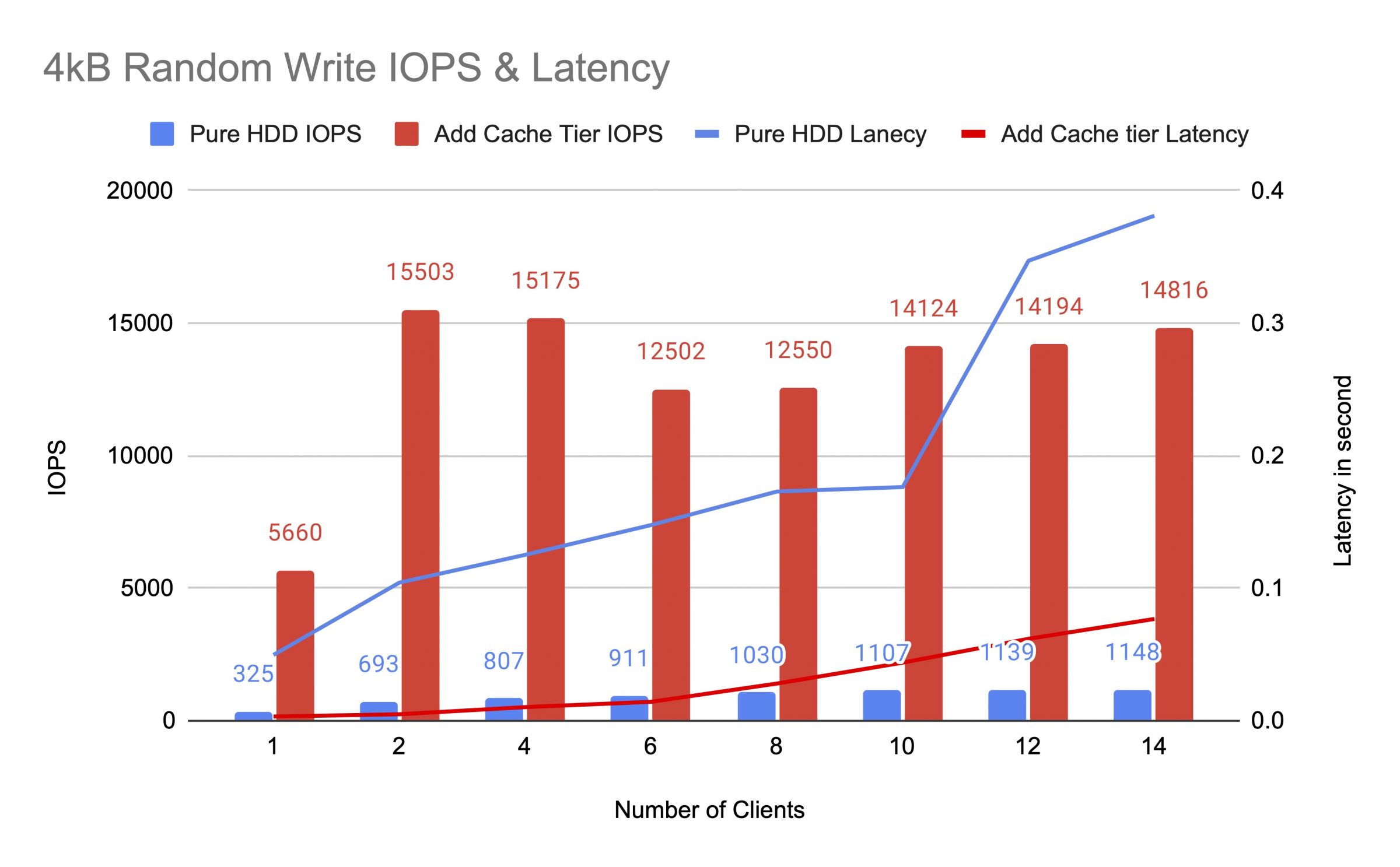

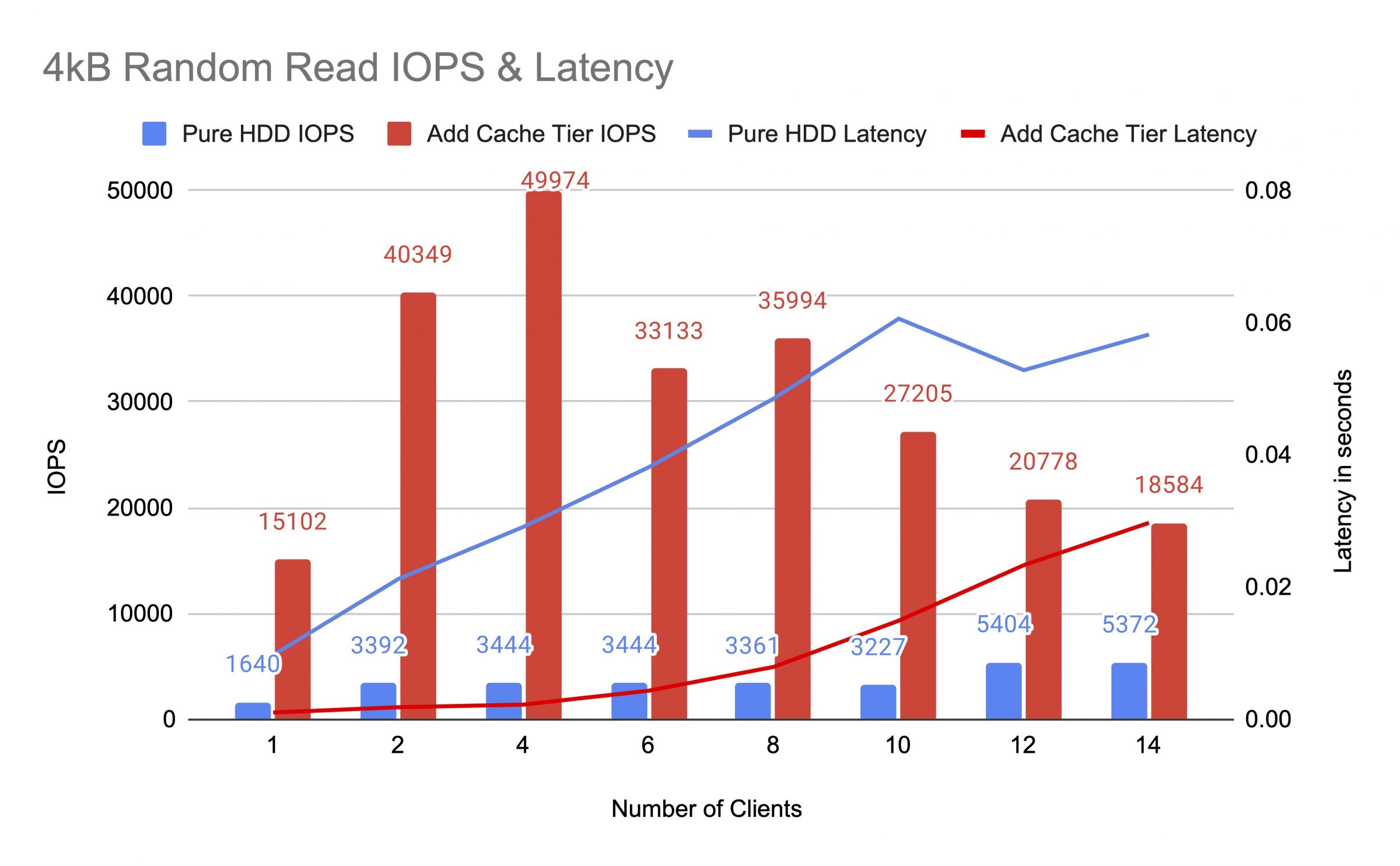

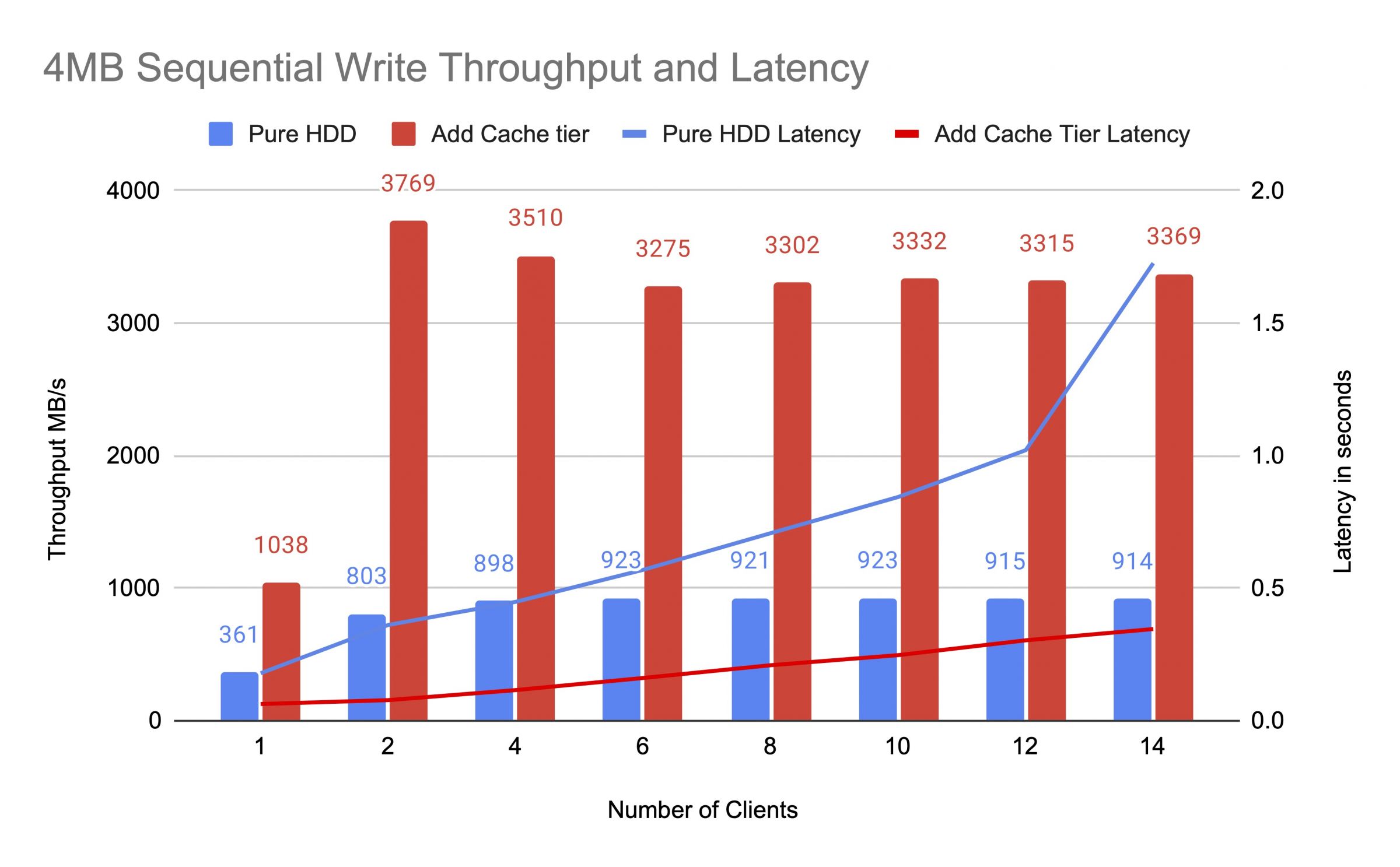

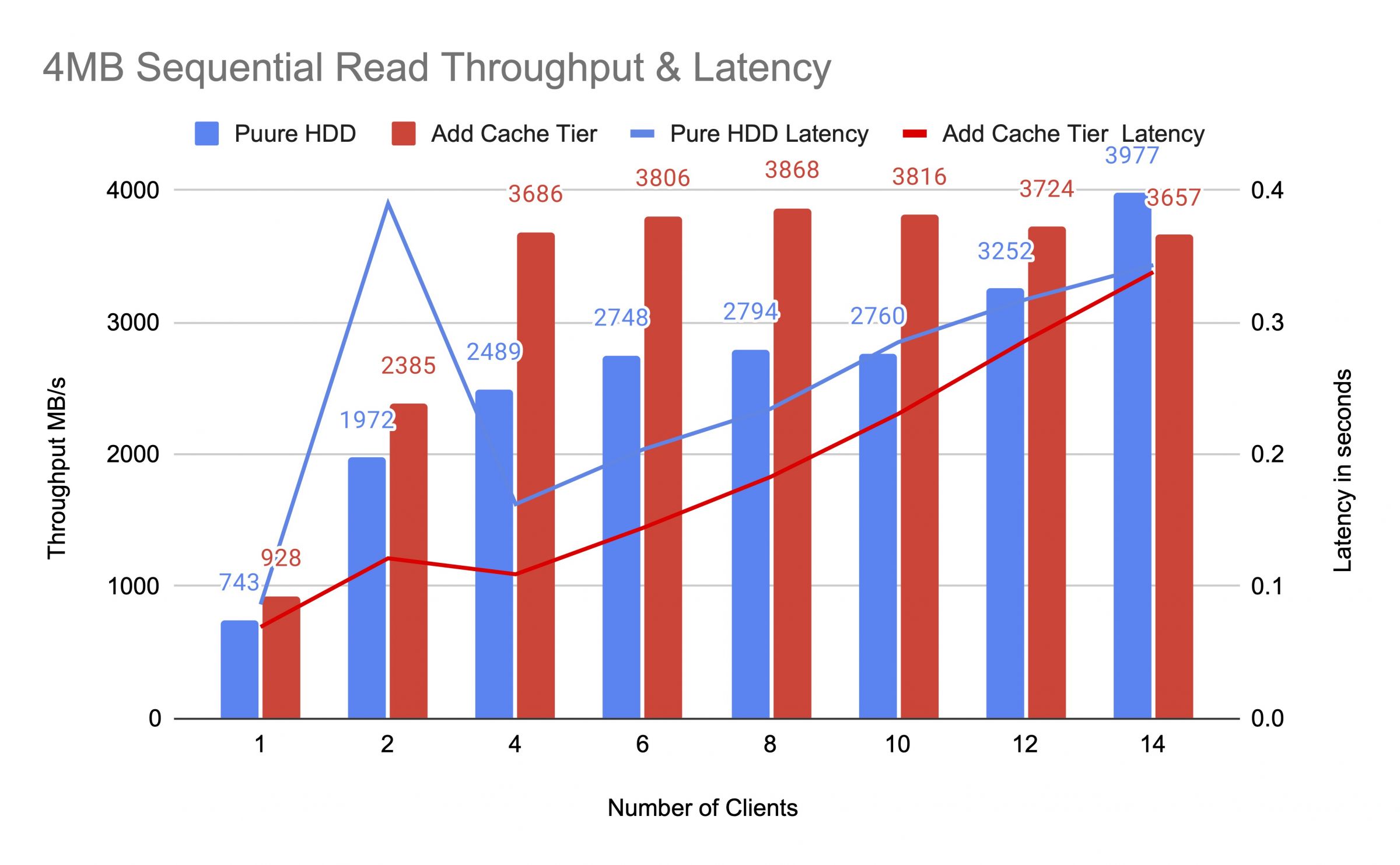

Kami menguji kolam HDD sebelum dan setelah menambahkan tingkat cache, menggunakan hingga 14 klien untuk menghasilkan beban uji. Setiap klien memasang RBD untuk uji coba fio. Pemuatan uji dimulai dengan satu klien dan meningkatkan jumlah klien setelah setiap pekerjaan uji selesai. Setiap siklus pengujian berlangsung selama lima menit dan dikendalikan secara otomatis oleh Jenkins. Kinerja pekerjaan uji adalah jumlah dari semua hasil klien. Sebelum menguji tiering cache, kami menulis data ke RBD hingga kolam tier cache terisi melebihi rasio penuh target cache ceph (0.8).

Diagram menunjukkan bahwa kinerja dari pool HDD murni secara signifikan ditingkatkan setelah menambahkan pool cache NVMe.

Selama uji tingkat cache, kami mengamati statistik kolam menggunakan perintah CEPH OSD Pool Stats. Kolam cache dan pangkalan telah memerah, mengusir, dan mempromosikan kegiatan. Kami menangkap statistik biliar pada waktu yang berbeda selama tes tingkat cache.

Data telah ditulis ke cache

id cache pool 84

io klien 21 MiB/s wr, 0 op/s rd, 5.49k op/s wr

id mars400_rbd pool 86

tidak ada yang sedang terjadi

Cache sedang melakukan promosi dan pengusiran

kumpulan cache id 84

klien io 42 MiB/s wkt, 0 op/s rd, 10,79k op/s rd

tingkat cache io 179 MiB/dtk dikeluarkan, 17 operasi/dtk dipromosikan

pool mars400_rbd id 86

klien io 0 B/s rd, 1,4 MiB/s rd, 18 op/s rd, 358 op/s rd

Cache sedang membersihkan

cache pool id 84

io klien 3.2 GiB/s rd, 830 op/s rd, 0 op/s wr

io tingkat cache 238 MiB/s flush, 14 op/s promote, 1 PG sedang dibersihkan

pool mars400_rbd id 86

io klien 126 MiB/s rd, 232 MiB/s wr, 44 op/s rd, 57 op/s wr

PG diusir

kumpulan cache id 84

klien io 2,6 GiB/s rd, 0 B/s wr, 663 op/s rd, 0 op/s wr

tingkat cache io 340 MiB/dtk flush, 2,7 MiB/dtk dikeluarkan, 21 operasi/dtk dipromosikan, 1 PG dikeluarkan (penuh)

pool mars400_rbd id 86

klien io 768 MiB/s rd, 344 MiB/s rd, 212 op/s rd, 86 op/s rd

Mengosongkan PG dan IO klien langsung ke pool dasar.(klien sedang menulis data)

ID cache kolam 84

IO klien 0 B/dt wr, 0 op/dt rd, 1 op/dt wr

IO tingkat cache 515 MiB/dt flush, 7.7 MiB/dt evict, 1 PGs flushin

ID kolam mars400_rbd 86

IO klien 613 MiB/dt wr, 0 op/dt rd, 153 op/dt wr

Setelah pengujian berkelanjutan, kami mengistirahatkan kluster selama beberapa jam dan mengulangi tes tulis acak 4 kB. Kami mendapatkan kinerja yang jauh lebih baik. Ini karena ruang cache dibebaskan untuk penulisan baru.

Dari tes ini, kami yakin bahwa menggunakan kolam NVMe sebagai lapisan cache dari kolam HDD dapat mencapai peningkatan kinerja yang signifikan.

Perlu dicatat bahwa kinerja lapisan cache tidak dapat dijamin. Kinerja tergantung pada kondisi hit cache pada saat itu, dan kinerja yang sama tidak dapat dicapai dengan mengulangi tes dengan konfigurasi dan beban kerja yang sama.

Jika aplikasi Anda membutuhkan kinerja yang konsisten, gunakan kolam SSD NVMe murni.

- Produk Terkait

Mars500 NVME Semua Flash Perangkat Penyimpanan Ceph

Mars 500

Mars 500 Ceph Appliance dirancang untuk memenuhi kebutuhan penyimpanan data cloud-native berkinerja tinggi. Ini memanfaatkan teknologi flash NVMe terbaru...

rincianPerangkat penyimpanan Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance dirancang untuk memenuhi kebutuhan penyimpanan data cloud-native dengan kapasitas tinggi. Ini menggunakan HDD untuk mendapatkan...

rincian