Schnelle Ceph OSD-Wiederherstellung mit SBB-Technologie erreichen

In modernen Rechenzentren ist die ununterbrochene Datenverfügbarkeit entscheidend. Während der CRUSH-Algorithmus von Ceph effektiv mit Ausfällen umgeht und die Datenintegrität schützt, bleibt die Hardware-Redundanz entscheidend, um eine hohe Verfügbarkeit sicherzustellen. Die Einführung von Storage Bridge Bay (SBB) Servern in die Ceph-Infrastruktur verbessert die Resilienz erheblich, indem sie Serviceunterbrechungen während Hardwareausfällen minimiert.

Herausforderungen traditioneller Ceph-Implementierungen

In einer herkömmlichen Ceph-Implementierung hostet jeder Speicher-Server typischerweise mehrere Object Storage Daemons (OSDs). Wenn ein einzelner Server Hardwarefehler erleidet, wie z.B. einen Motherboard-Ausfall oder einen Netzwerkartenfehler, gehen alle OSDs auf diesem Host gleichzeitig offline. Diese Situation löst einen Wiederherstellungsprozess aus, wodurch Placement Groups (PGs) degradiert werden und möglicherweise die Datenredundanz gefährdet wird.

Die Wiederherstellung von einem solchen Ereignis kann eine erhebliche Zeit in Anspruch nehmen, abhängig vom Datenvolumen und den verfügbaren Ressourcen, was zu einer verlängerten verminderten Leistung und einem erhöhten Risiko von Datenverlust oder Dienstunterbrechung führen kann.

Einführung der Storage Bridge Bay (SBB) Server

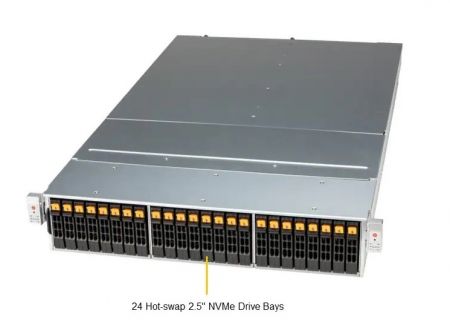

Storage Bridge Bay (SBB) ist eine standardisierte Doppelknoten-Serverarchitektur für hohe Verfügbarkeit. Ein SBB -Server beherbergt zwei unabhängige Computerknoten, die mit dem gemeinsam genutzten Speicher in einer JBOD -Konfiguration (nur einer Reihe von Festplatten) verbunden sind. In der Regel unterstützen diese Server Dual-Port-NVME- oder SAS-Laufwerke und bieten eine robuste Redundanz von Hardware.

Wie die SBB die Hochverfügbarkeit von Ceph verbessert

In einer SBB-basierten Ceph-Bereitstellung arbeitet jeder Knoten im aktiven aktiven Modus, was bedeutet, dass beide Knoten gleichzeitig Ceph OSD-Dienste ausführen. Zum Beispiel verteilt ein typischer SBB-Server, der mit 24 NVMe-SSD-Laufwerken ausgestattet ist, diese gleichmäßig zwischen den beiden Knoten, wobei jeder Knoten zunächst 12 OSDs verwaltet.

Dieses Design stellt sicher, dass wenn ein Knoten ausfällt, nur die Hälfte der OSDs vorübergehend nicht verfügbar wird, anstatt alle auf einmal, was die Schwere und die Auswirkungen des Ausfalls erheblich reduziert.

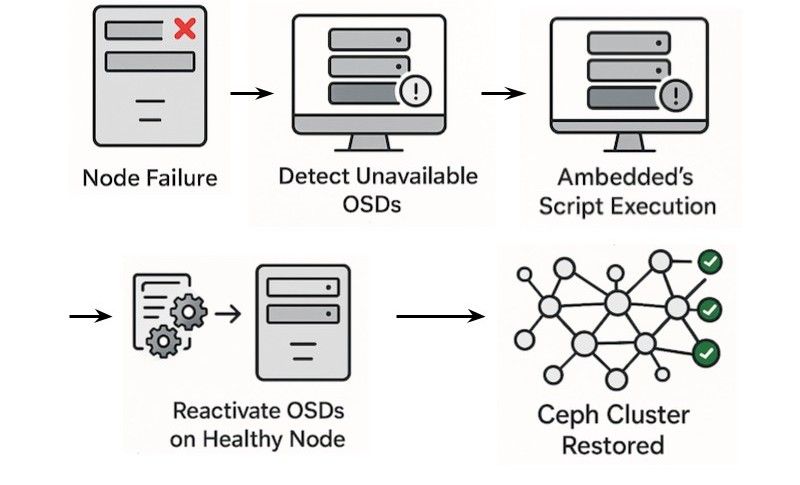

Schnelles OSD-Fehlerübertragungsszenario

Wenn ein Fehler auf einem Knoten innerhalb eines SBB-Servers auftritt, werden die Hälfte der OSDs unzugänglich. Ambedded Technology hat ein robustes Skript entwickelt, das darauf ausgelegt ist, die betroffenen OSDs schnell auf den überlebenden Knoten zu migrieren und wieder zu aktivieren.

So erfolgt der schnelle Migrationsprozess:

1.Erhalten Sie das Ceph-Container-Image:Holen Sie sich schnell die erforderliche Container-Image-Referenz für Ceph-Operationen.

2.OSD-spezifischen CRUSH-Standort entfernen: Aktualisieren Sie die OSD-Konfiguration, indem Sie die nodespezifischen CRUSH-Standortdetails entfernen.

3.Aktivieren Sie OSD mit ceph-volume: Reaktivieren Sie die OSD-Dienste mit dem ceph-volume-Dienstprogramm.

4.OSD mit cephadm übernehmen: Integrieren Sie die aktivierten OSDs zurück in den Ceph-Cluster, um den Dienst schnell wiederherzustellen.

Vorteile der Verwendung von SBB für Ceph

1.Minimierte Ausfallzeiten: Die schnelle OSD-Reaktivierung reduziert die Zeit, die in degradierten Zuständen verbracht wird, erheblich und stellt die PGs schnell wieder in einen aktiven und sauberen Status her.

2.Erweiterte Servicekontinuität: Verhindert längere Unterbrechungen und gewährleistet eine konsistente Servicebereitstellung.

3.Vereinfachte Wartung: Sofortige Hardware-Reparaturen werden weniger dringend, da die Dienste auf dem verbleibenden Knoten weiterhin betriebsbereit sind.

4.Reduziertes Risiko von Datenverlust und Leistungsabfall: Beschleunigte Wiederherstellungsprozesse und Hardware-Redundanz minimieren potenzielle Risiken, die mit Hardwarefehlern verbunden sind.

Zusammenfassung und Fazit

Die Integration von Storage Bridge Bay (SBB) Servern mit Ceph-Implementierungen verbessert die Widerstandsfähigkeit und Betriebseffizienz von Speicherinfrastrukturen erheblich. Durch die Nutzung einer aktiven aktiven Konfiguration und schneller OSD-Reaktivierungsfähigkeiten können Organisationen die Ausfallzeiten erheblich reduzieren und das Management vereinfachen.

Die Ceph-Appliance von Ambedded Technology, Mars 624, veranschaulicht diese Integration, indem sie eine schlüsselfertige Lösung anbietet, die die Vorteile der SBB-Architektur nutzt.Organisationen, die die Verfügbarkeit von Ceph verbessern und die Wartung optimieren möchten, sollten ein Upgrade auf Mars 624 in Betracht ziehen, um unvergleichliche Speicherzuverlässigkeit und Effizienz zu erreichen.

Darüber hinaus unterstützt die UniVirStor Full-Stack Ceph-Software von Ambedded vollständig alle Speicherserver, die auf SBB-Technologie basieren, wie z.B. Supermicro's SSG-640SP-DE2CR60, und gewährleistet Flexibilität und Kompatibilität für verschiedene Infrastrukturumgebungen.

- Verwandte Produkte

Mars 624 SBB 24x NVMe Zwei Hot-Swap Knoten Ceph Speichergerät

Mars 624 SBB

Der Mars624 SBB-Server beherbergt zwei hot-swappable Intel Xeon-Serverknoten in einem 2U-Gehäuse. Zwei Serverknoten können gleichzeitig mit allen 24x Dual-Port...

Einzelheiten