Veeam yedekleme ve arşivleme için Ceph ile çalışmak.

Bu vaka çalışması, Mars 400 ceph depolama cihazını Veeam yedekleme ve çoğaltma yedekleme havuzları olarak nasıl kullanacağınızı açıklar.

Ceph, nesne depolama, blok depolama ve POSIX dosya sistemini tek bir kümede destekler. Yedekleme gereksinimlerine göre, müşteriler çeşitli depolama yedekleme stratejilerinin ihtiyaçlarını desteklemek için farklı depolama protokolleri seçebilir.

Bu makalede, Ceph blok depolama (Ceph RBD) ve Ceph dosya sistemi (Cephfs) yedekleme havuzları olarak kullanılıyor ve Hyper-V ve VMWare'den sanal makineleri yedeklemenin yedekleme iş süreleri karşılaştırılıyor.

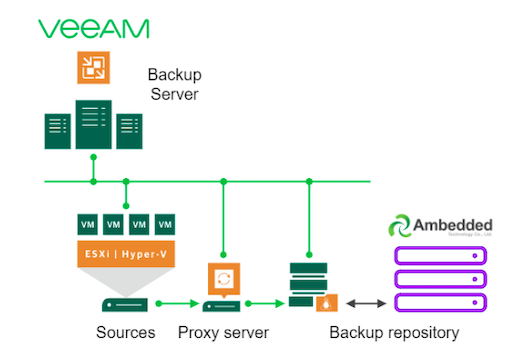

Veeam ve Ceph kullanarak Yedekleme Çözümü Mimarisi

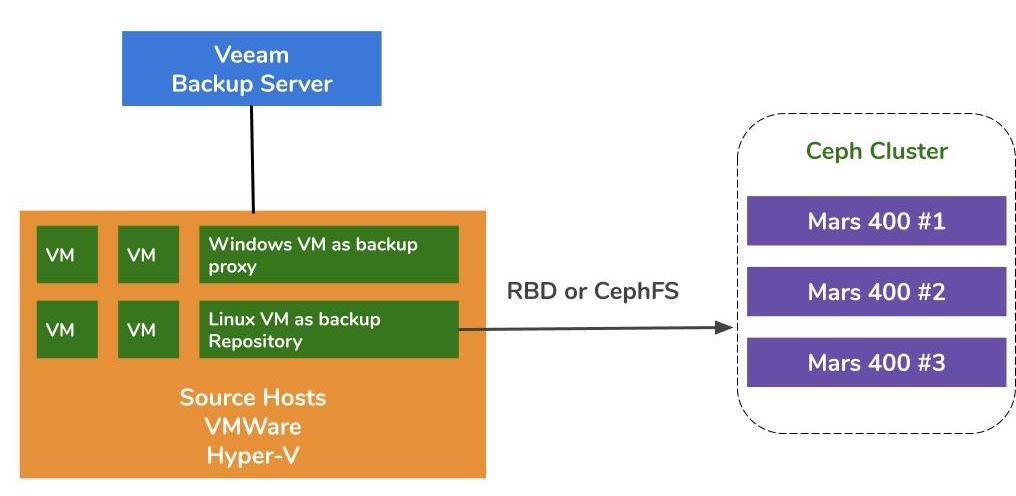

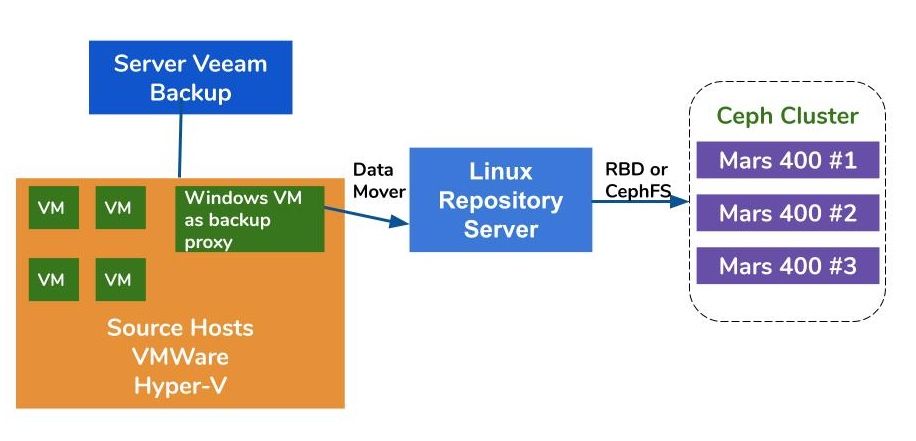

VMWare ve Hyper-V üzerinde sanal makinelerin yedeklenmesi mimarisi benzerdir. Veeam, veri taşıyıcıları kullanarak verileri kaynak sunuculardan yedek depolama alanlarına aktarır. Veri taşıyıcıları proxy sunucusunda ve depolama sunucusunda çalışır. Bir yedek depolama alanının arka uç depolama olarak Ceph'i kullanmak için, Linux fiziksel sunucuda veya sanal makinede RBD veya CephFS'yi bağlayabilirsiniz.

Eğer proxy ve depo sunucuları hipervizör kümesinin içindeki sanal makineler ise, VM diski, proxy sunucusu ve depo sunucusu arasında ağsız yüksek hızlı veri taşıma avantajından faydalanabilirsiniz. Büyük bir hipervizör kümesinin en iyi yapılandırması, her VMWare ana bilgisayarında bir proxy sunucusu VM ve bir depolama sunucusu VM dağıtmaktır. Aksi takdirde, üretim VMWare'inizden yükü kaldırmak için her VMWare sunucusuna bir yedek proxy VM ve bir dış sunucu deposu sunucusu dağıtabilirsiniz.

Veeam Yedekleme ve Replikasyon için Ambedded Ceph cihazını depo olarak kullanmanın üç yolu vardır.CephFS ve RBD blok cihazları yerinde yedekleme deposu olarak kullanılabilir.S3 nesne depolama, uzak bir konum için kapasite katmanı olarak kullanılabilir.

Ceph RBD blok cihazını ve CephFS dosya sistemiyle sanal makineleri ve dosyaları yedeklemek için Veeam'in yedekleme deposunu nasıl kuracağınızı ayrıntıları bu sayfanın sonundaki beyaz kağıtta bulabilirsiniz.

Test Ortamı

- 3x monitör, 20 OSD ve 1x MDS (meta veri sunucusu) ile üç Mars 400

- Her Ceph daemonu bir çift çekirdekli Arm A72 mikro sunucuda çalışır

- İşletim Sistemi: CentOS 7

- Ceph yazılımı: Nautilus 14.2.9 Arm64

- Ağ: Mars 400 için 4x 10Gb ağ

Veeam Backup & Replication 10, Sürüm: 10.0.1.4854

Veeam Yedekleme Sunucusu

- CPU: Intel Xeon E5-2630 2.3GHz İKİLİ

- DRAM: 64GB

- Ağ: 2x 10Gb sfp+ bağlama

- Disk: Sistem için 1TB, hacim için 256GB SATA3 SSD

- Windows Sunucu 2019

Veeam Proxy Sunucusu

- Veeam Yedek Sunucusu ile birlikte konumlandır

Depo Sunucusu

- Sanal Makina

◇ CPU: 4 çekirdek 2.3GHz

◇ DRAM: 8GB

◇ Ağ: köprü

◇ Disk: 50GB sanal disk

◇ İşletim Sistemi: CentOS 7.8.2003

- Çıplak Metal Sunucu

◇ CPU: Intel Xeon X5650 2.67GHz ÇİFT

◇ DRAM: 48GB

◇ Ağ: 2-port 10Gb sfp+ bağlama

◇ Disk: Sistem için 1TB

◇ İşletim Sistemi: CentOS 7.6.1810

Hyper-V Sunucusu

◇ İşlemci: Intel Xeon E5-2630 2.3GHz ÇİFT

◇ DRAM: 64GB

◇ Ağ: 2-portlu 10Gb sfp+ bağlama

◇ Disk: 1TB sistem için

◇ Windows Sunucusu 2019

VMWare Sunucusu

◇ İşlemci: Intel Xeon E5-2630 2.3GHz ÇİFT

◇ DRAM: 64GB

◇ Ağ: 2-portlu 10Gb sfp+ bağlama

◇ Disk: 1TB sistem için

◇ ESXi 6.5

Ağ: 10GbE anahtar

Çeşitli Kurulumlarda Performans Testi

Farklı yedekleme depolarının yedekleme performansını test etmek için, farklı yedekleme depoları ve üç yedekleme kaynağıyla testler yapıyoruz.

Testler için kullandığımız yedekleme kaynakları, bir sunucuda bulunan bir SATA SSD tabanlı bir birim, Hyper-V'nin bir Windows VM'i ve bir CentOS 7 VM ve VMWare'nin bir Windows VM'i.

(1)SSD Sürücüdeki bir birimi yedekleme

Tablo 1. Bir sunucudan SATA SSD ile bir birimi yedekleme.

| Disk Boyutu (İşlenen Veri) | 237.9GB |

| Kaynaktan Okunan Veri | 200.1GB |

| Veri, Deduplikasyon ve Sıkıştırma Sonrasında Ceph'e Aktarıldı | 69.7GB |

| Deduplikasyon | 1.3X |

| Sıkıştırma | 2.7X |

Tablo 2.

|

Yedekleme Depo |

Süre (sn) |

Kaynak (%) |

Vekil (%) |

Ağ (%) |

Hedef (%) |

İşleniyor Hız (MB/s) |

Ortalama Veri Yazma Hız (MB/s) |

|

Linux Sanal Makinesi, RBD-replika 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linux Sanal Makinesi, CephFS-replika 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linux Sanal Makinesi, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linux Sanal Makinesi, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Linux Sunucusu, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Not: Ortalama Veri Yazma Hızları, Aktarılan Veriye Bölünerek Süreyle Hesaplanır. Bu hızlar, bu yedekleme işlerindeki Ceph kümesinin iş yüklerini temsil eder.

(2) Bir Windows 10 VM'yi HDD üzerinde Hyper-V'de yedekle

Bu ölçütte, bir SATA sabit diske kaydedilen bir Hyper-V örneğini yedekliyoruz. Bu işlerin işleme hızları HDD bant genişliğinin üst sınırına ulaşır. Kaynağın darboğazının da kaynaklandığını görebiliriz çünkü yükleri iş süresinin %99'unda meşgul durumdadır. Ceph kümesi, hedef, Veeam yedekleme işlerinden gelen iş yükü hafiftir. Ceph kümesi çalışma süresinin sadece %6 ila %1'i meşgul.

Önceki ölçümle karşılaştırıldığında, VM yedekleme işleminin işleme hızı SSD yedeklemesinden çok daha düşüktür.Bu, sanal makine verilerinin bir sabit diske kaydedilmesi nedeniyle başlıca olarak gerçekleşir.

Tablo 3.

| Disk Boyutu (HDD) | 127GB |

| Kaynaktan Okunan Veri | 37.9GB |

| Ceph'e Aktarılan Veriler Çıkarma ve Sıkıştırma Sonrası | 21.4GB |

| Deduplikasyon | 3.3X |

| Sıkıştırma | 1.8X |

Tablo 4. Bir sanal makine görüntüsünü SATA3 HDD üzerine yedekleme

|

Yedekleme Depo |

Süre (sn) |

Kaynak (%) |

Vekil (%) |

Ağ (%) |

Hedef (%) |

İşleniyor Hız (MB/s) |

Ortalama Veri Yazma Hız (MB/s) |

|

Linux Sanal Makinesi, RBD hacmi, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linux Sanal Makinesi, CephFS birimi, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Linux Sunucusu, RBD hacmi, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Not: Ortalama Veri Yazma Hızları, Aktarılan Veriye Bölünerek Süreyle Hesaplanır. Bu hızlar, bu yedekleme işlerindeki Ceph kümesinin iş yüklerini temsil eder.

(3)ESXi üzerindeki Sanal Makineleri HDD'ye Yedekleme

Bu test, bir HDD üzerinde çalışan CentOS 7 ve Windows 10 sanal makinelerini VMWare ESXi 6.5 ana bilgisayarına yedekler ve 4+2 hata düzeltme kodu korumasına sahip bir Ceph RBD tarafından desteklenen bir depoya kaydeder.

Tablo 5.

| Kaynak | CentOS Sanal Makinesi | Windows 10 Sanal Makinesi |

| Disk Boyutu (HDD) | 40GB | 32GB |

| Kaynaktan Okunan Veri | 1.8GB | 12.9GB |

| Ceph'e Aktarılan Veriler Çıkarma ve Sıkıştırma Sonrası | 966MB | 7.7GB |

| Deduplikasyon | 22.1X | 2.5X |

| Sıkıştırma | 1.9X | 1.7X |

Tablo 6.

|

Yedekleme Kaynak |

Süre (sn) |

Kaynak (%) |

Vekil (%) |

Ağ (%) |

Hedef (%) |

İşleniyor Hız (MB/s) |

Ortalama Veri Yazma Hız (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Not: Ortalama Veri Yazma Hızları, Aktarılan Veriye Bölünerek Süreyle Hesaplanır. Bu hızlar, bu yedekleme işlerindeki Ceph kümesinin iş yüklerini temsil eder.

Sonuçlar

Test sonuçlarına göre, Ceph RBD ve CephFS benzer performansa sahiptir. Bu, RBD ve CephFS performansıyla ilgili deneyimimize uyuyor. CephFS ve RBD'nin özelliklerini karşılaştırırken, avantajları ve dezavantajları vardır. Birden fazla depo sunucusu dağıtmanız gerekiyorsa, her yedek depo sunucusu için bir RBD görüntüsü oluşturmanız gerekmektedir çünkü Ceph RBD yalnızca bir ana bilgisayarda bağlanabilir. CephFS'ye kıyasla, RBD kullanmak daha basittir çünkü metadata sunucularına ihtiyaç duymaz. Oluşturulduğunda RBD kapasite boyutunu atamamız gerekiyor, bu yüzden daha fazla alan ihtiyacınız olduğunda kapasiteyi yeniden boyutlandırmanız gerekiyor.

Eğer depo olarak CephFS kullanıyorsanız, Ceph kümesinde en az bir meta veri sunucusu (MDS) dağıtmanız gerekmektedir. Ayrıca yüksek kullanılabilirlik için bir yedek meta veri sunucusuna da ihtiyacımız var. Ceph RBD'ye kıyasla, dosya sisteme bir kota vermenize gerek yoktur. Bu nedenle, CephFS'yi sınırsız bir depolama havuzu olarak kullanabilirsiniz.

Bu kullanım senaryosu gösteriminde, testlerimiz her yedekleme işinde yalnızca bir sanal makineyi yedekler. Yukarıdaki test raporlarına göre, ortalama veri yazma hızının işleme hızı ve veri sıkıştırma ve sıkıştırma verimliliği ile ilişkili olduğunu biliyoruz. Daha hızlı bir kaynak disk, yedekleme işi süresini azaltır ve daha hızlı bir işleme hızına yol açar. Kullanıcıların altyapısına bağlı olarak, kullanıcılar aynı anda farklı nesneleri yedeklemek için birkaç eşzamanlı işi dağıtabilirler. Ceph depolama, birden fazla eşzamanlı işi desteklemede çok iyi performans gösterir.

3x Ambedded Mars 400 tarafından desteklenen 20x HDD OSD Ceph kümesi, 4+2 silme kodu havuzuna kadar 700MB/s toplam yazma verimliliği sunabilir. Birden fazla mevcut yedekleme işinin dağıtılması, genel yedekleme süresini azaltma avantajı sağlar. Bir Ceph kümesinin maksimum performansı, kümedeki toplam disk sürücüsü sayısıyla neredeyse doğrusal olarak orantılıdır.

Bu kullanım durumunda, yedek depo olarak S3 nesne depolamasını test etmedik. S3 nesne depolaması, Veeam Scale-Out yedek deposunda kapasite katmanı olarak ve NAS yedeklemesi için hedef arşiv deposu olarak kullanılabilir. Ambedded UVS yöneticisi olan ceph yönetim web arayüzünü kullanarak kolayca bir RADOS ağ geçidi kurabilir ve nesne depolama kullanıcıları oluşturabilirsiniz.

- İndir

Veeam Yedekleme & Replikasyon beyaz kitabı için Ceph'i depo olarak kullanın.

Ceph RBD blok cihazını ve CephFS dosya sistemini sanal makineleri ve dosyaları yedeklemek için Veeam'in yedekleme deposu olarak nasıl kuracağınız.

İndirmek- İlgili Ürünler

Mars 400PRO Ceph depolama aygıtı

Mars 400PRO

Mars 400 Ceph Appliance, yüksek kapasiteli bulut tabanlı veri depolama ihtiyaçlarını karşılamak üzere tasarlanmıştır. Düşük maliyetli TB başına...

Detaylar