運用 SBB 技術實現 Ceph OSD 的快速復原

在現代資料中心中,不間斷的資料可用性至關重要。儘管 Ceph 的 CRUSH 演算法能有效處理故障並保護資料完整性,但硬體冗餘依然是確保高可用性的關鍵。將SBB (Storage Bridge Bay) 伺服器導入 Ceph 基礎架構,可在硬體故障期間把服務中斷降至最低,從而顯著提升整體韌性。

傳統 Ceph 部署的挑戰

在傳統的 Ceph 部署中,每台儲存伺服器通常會運行多個 OSD(Object Storage Daemon)。如果單一伺服器發生硬體故障(例如主機板異常或網路卡故障),該主機上的所有 OSD 都會同時離線。此情況將觸發復原流程,使放置群組(PG)進入降級(degraded)狀態,並可能削弱資料的冗餘性。

從此類事件中復原可能耗費大量時間,其長短取決於資料量和可用資源,進而可能導致長時間的效能下降,並增加資料遺失或服務中斷的風險。

導入儲存橋接槽 (SBB) 伺服器

儲存橋接槽(SBB)是一種專為高可用性設計的標準化雙節點伺服器架構。一台 SBB 伺服器內含兩個獨立的運算節點,以 JBOD (Just a Bunch of Disks) 配置連接到共享儲存。這類伺服器通常支援雙埠 NVMe 或 SAS 硬碟,藉此提供強固的硬體冗餘。

SBB 如何提升 Ceph 的高可用性

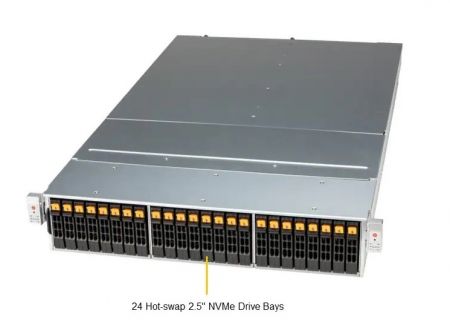

在基於 SBB 的 Ceph 部署中,每個節點都採用主動-主動(Active-Active)模式運作,意即兩個節點會同時運行 Ceph OSD 服務。舉例來說,一台配備 24 個 NVMe SSD 硬碟的典型 SBB 伺服器,會將這些硬碟平均分配給兩個節點,讓每個節點最初各自管理 12 個 OSD。

這種設計確保了當其中一個節點故障時,只有一半的 OSD 會暫時離線,而非全部同時離線,藉此顯著降低了故障的嚴重性與影響。

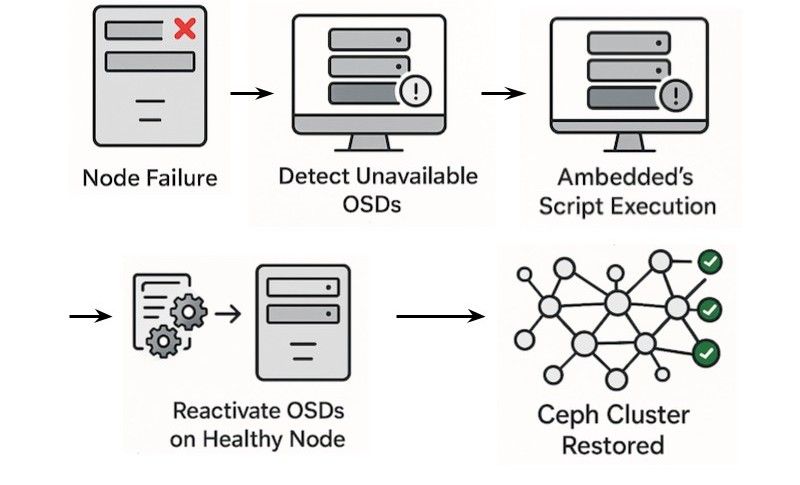

OSD 快速故障轉移情境

當 SBB 伺服器中的其中一個節點發生故障時,將有一半的 OSD 變得無法存取。Ambedded Technology 已開發一套穩健的腳本,可快速將受影響的 OSD 遷移至存活節點並重新啟用。

以下是快速遷移過程的運作方式 :

1. 取得 Ceph 容器映像檔 : 快速取得 Ceph 操作所需的容器映像檔參考。

2. 移除 OSD 的特定 CRUSH 位置 : 透過移除節點特定的 CRUSH 位置細節來更新 OSD 設定。

3. 使用 ceph-volume 啟用 OSD : 使用 ceph-volume 工具重新啟用 OSD 服務。

4. 使用 cephadm 接管 OSD : 將已啟用的 OSD 重新整合回 Ceph 叢集,以迅速恢復服務。

在 Ceph 中使用 SBB 的優勢

1. 將停機時間降到最低 : 快速重新啟動 OSD 可大幅縮短系統處於降級 (degraded) 狀態的時間,迅速使 PG (Placement Group) 恢復為 active+clean 狀態。

2. 強化服務連續性 : 避免長時間服務中斷,維持穩定一致的服務提供。

3. 簡化維護 : 由於服務可在存活的節點上持續運作,立即進行硬體維修的急迫性降低。

4. 降低資料遺失與效能下降的風險 : 加速的復原流程與硬體冗餘可將硬體故障帶來的潛在風險降至最低。

總結與結論

將儲存橋接槽 (SBB) 伺服器與 Ceph 部署相結合,可大幅提升儲存基礎架構的韌性與營運效率。藉由利用其主動 - 主動 (Active-Active) 架構和快速 OSD 重新啟用能力,企業能夠顯著減少停機時間並簡化管理。

Ambedded Technology 的 Ceph 一體機 Mars 624 透過採用 SBB 架構並提供一體化的統包式解決方案,充分體現了此整合的優勢。若企業希望提升 Ceph 的可用性並簡化維護流程,建議考慮升級至 Mars 624,以實現無與倫比的儲存可靠性與效率。

此外,Ambedded 的 UniVirStor 全棧式 (full-stack) Ceph 軟體完全支援任何以 SBB 技術所打造的儲存伺服器,例如 Supermicro 的 SSG-640SP-DE2CR60,確保了在多樣化基礎架構環境中的靈活性與相容性。

- 相關產品

Mars 624 SBB 24×NVMe 雙節點熱插拔 Ceph 儲存一體機

Mars 624 SBB

Mars624 SBB 伺服器在一個 2U 機箱中可容納兩個熱插拔的 Intel Xeon 伺服器節點。兩個伺服器節點可以同時連接到所有 24 個雙埠...

細節