Veeam backup และ archive เพื่อทำงานร่วมกับ Ceph.

กรณีศึกษานี้อธิบายวิธีการใช้ Mars 400 Ceph storage appliance เป็นที่เก็บข้อมูลสำรองของ Veeam backup และ replication.

Ceph รองรับการเก็บข้อมูลแบบ object storage, block storage และ POSIX file system ทั้งหมดในคลัสเตอร์เดียว ตามความต้องการในการสำรองข้อมูล ลูกค้าสามารถเลือกโปรโตคอลการเก็บข้อมูลที่แตกต่างกันเพื่อตอบสนองความต้องการของกลยุทธ์การสำรองข้อมูลที่หลากหลาย.

ในบทความนี้ เราใช้ Ceph block storage (Ceph RBD) และ Ceph file system (Cephfs) เป็นที่เก็บข้อมูลสำรองและเปรียบเทียบระยะเวลางานสำรองข้อมูลของการสำรองเครื่องเสมือนจาก Hyper-V และ VMWare.

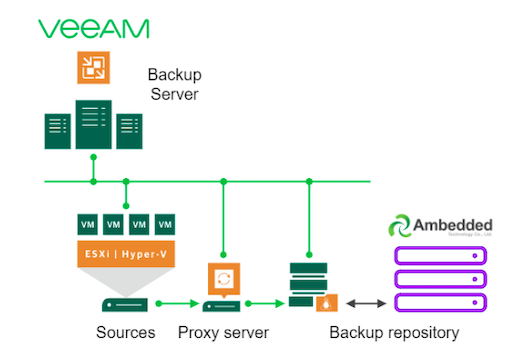

สถาปัตยกรรมการสำรองข้อมูลโดยใช้ Veeam และ Ceph

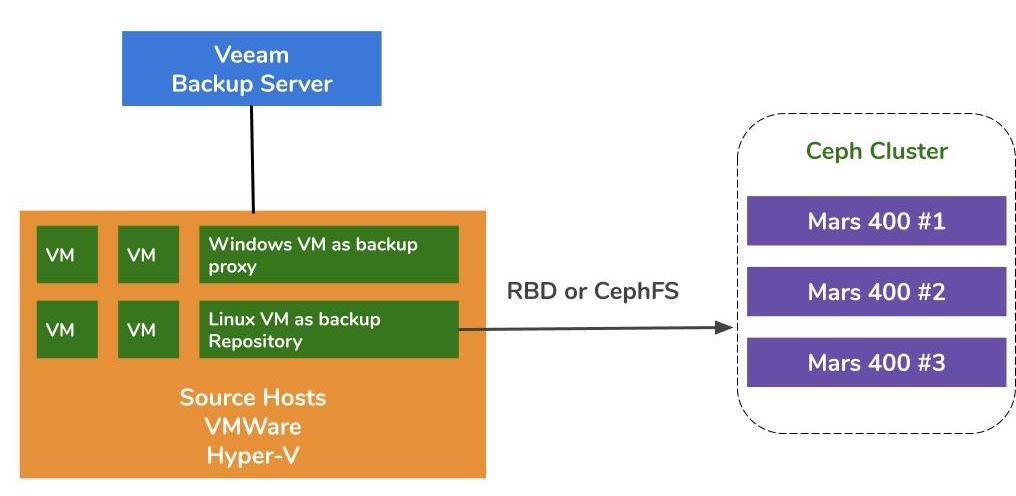

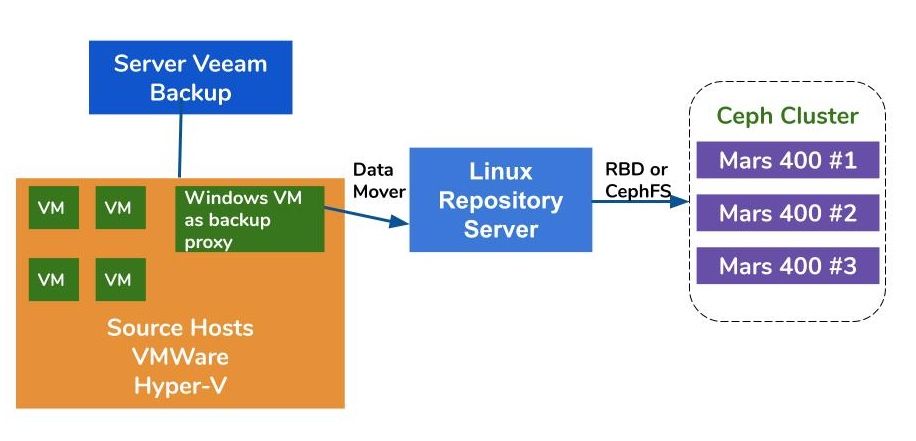

สถาปัตยกรรมการสำรองข้อมูลเครื่องเสมือนบน VMWare และ Hyper-V คล้ายกัน Veeam ใช้ตัวย้ายข้อมูลเพื่อถ่ายโอนข้อมูลจากโฮสต์ต้นทางไปยังที่เก็บข้อมูลสำรอง ตัวย้ายข้อมูลทำงานบนเซิร์ฟเวอร์พร็อกซีและเซิร์ฟเวอร์เก็บข้อมูลสำรอง ในการใช้ Ceph เป็นการจัดเก็บข้อมูลสำรองของเซิร์ฟเวอร์ คุณสามารถติดตั้ง RBD หรือ CephFS บนเซิร์ฟเวอร์ฟิสิกส์หรือเครื่องเสมือนบน Linux เป็นเซิร์ฟเวอร์เก็บข้อมูลสำรอง

หากเซิร์ฟเวอร์พร็อกซีและเซิร์ฟเวอร์เก็บข้อมูลเป็นเครื่องเสมือนภายในกลุ่มไฮเปอร์ไวเซอร์ คุณสามารถได้รับประโยชน์จากการส่งข้อมูลด้วยความเร็วสูงระหว่างดิสก์เครื่องเสมือนภายในเครื่องเซิร์ฟเวอร์พร็อกซีและเซิร์ฟเวอร์เก็บข้อมูล การกำหนดค่าที่ดีที่สุดของกลุ่ม hypervisor ขนาดใหญ่คือการติดตั้งเซิร์ฟเวอร์พร็อกซี VM และเซิร์ฟเวอร์เก็บข้อมูล VM หนึ่งเครื่องละหนึ่งเครื่องบนแต่ละโฮสต์ VMWare นอกจากนี้คุณยังสามารถติดตั้งเครื่องมือสำรองข้อมูลแบบพร็อกซีสำหรับเซิร์ฟเวอร์ VMWare บนทุกๆเครื่องเซิร์ฟเวอร์ VMWare และเครื่องเซิร์ฟเวอร์สำรองแยกออกจากเครื่องเซิร์ฟเวอร์ในการทำงานเพื่อลดภาระของเครื่องเซิร์ฟเวอร์หลักของคุณ

มีสามวิธีในการใช้อุปกรณ์ Ceph Ambedded เป็นที่เก็บข้อมูลสำหรับการสำรองข้อมูลและการจำลองแบบของ VeeamCephFS และ อุปกรณ์บล็อก RBD สามารถใช้เป็นที่เก็บข้อมูลสำรองภายในองค์กรได้การจัดเก็บวัตถุ S3 สามารถใช้เป็นชั้นความจุสำหรับสถานที่ระยะไกลได้.

สำหรับวิธีการตั้งค่าอุปกรณ์บล็อก Ceph RBD และระบบไฟล์ CephFS เป็นที่เก็บข้อมูลสำรองของ Veeam สำหรับการสำรองข้อมูลเครื่องเสมือนและไฟล์ คุณสามารถหารายละเอียดในเอกสารขาวที่สุดของหน้านี้ได้

สภาพแวดล้อมการทดสอบ

- Three Mars 400 พร้อม 3x จอภาพ, 20 OSDs และ 1x MDS (เซิร์ฟเวอร์ข้อมูลเมตาดาต้า)

- แต่ละเซิร์ฟเวอร์ Ceph ทำงานบนเซิร์ฟเวอร์ไมโครเซิร์ฟเวอร์ Arm A72 คู่

- ระบบปฏิบัติการ: CentOS 7

- ซอฟต์แวร์ Ceph: Nautilus 14.2.9 Arm64

- เครือข่าย: 4x เครือข่าย 10Gb ต่อ Mars 400

Veeam Backup & Replication 10, เวอร์ชัน: 10.0.1.4854

เซิร์ฟเวอร์สำรองข้อมูล Veeam

- CPU: Intel Xeon E5-2630 2.3GHz คู่

- DRAM: 64GB

- เครือข่าย: 2x 10Gb sfp+ การผูกมัด

- ดิสก์: 1TB สำหรับระบบ, 256GB SATA3 SSD สำหรับปริมาณ

- Windows Server 2019

Veeam Proxy Server

- ตั้งอยู่ร่วมกับ Veeam Backup Server

Repository Server

- เครื่องจำลอง

◇ CPU: 4 แกน 2.3GHz

◇ DRAM: 8GB

◇ เครือข่าย: สะพาน

◇ ดิสก์: 50GB ดิสก์เสมือน

◇ ระบบปฏิบัติการ: CentOS 7.8.2003

- เซิร์ฟเวอร์ Baremetal

◇ CPU: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ เครือข่าย: 2 พอร์ต 10Gb sfp+ การรวมเชื่อมต่อ

◇ ดิสก์: 1TB สำหรับระบบ

◇ ระบบปฏิบัติการ: CentOS 7.6.1810

โฮสต์ Hyper-V

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ เครือข่าย: การผูกมัด 2 พอร์ต 10Gb sfp+

◇ ดิสก์: 1TB สำหรับระบบ

◇ เซิร์ฟเวอร์ Windows 2019

โฮสต์ VMWare

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ เครือข่าย: การผูกมัด 2 พอร์ต 10Gb sfp+

◇ ดิสก์: 1TB สำหรับระบบ

◇ ESXi 6.5

เครือข่าย: สวิตช์ 10GbE

การทดสอบบนการติดตั้งต่าง ๆ

เพื่อทดสอบประสิทธิภาพการสำรองข้อมูลของที่เก็บข้อมูลสำรองต่าง ๆ เราตั้งค่าการทดสอบด้วยที่เก็บข้อมูลสำรองที่แตกต่างกันและมีแหล่งข้อมูลสำรองสามแห่ง

แหล่งข้อมูลสำรองที่เราใช้ในการทดสอบคือระบบเสียงเอสเอสดีที่อ้างอิงจากเซิร์ฟเวอร์ เครื่องเสมือน Hyper-V และเครื่องเสมือน CentOS 7 และเครื่องเสมือน Windows ของ VMWare

(1) สำรองข้อมูลจากโดรฟ์ SSD

ตาราง 1. สำรองข้อมูลจากเซิร์ฟเวอร์ด้วย SSD ที่มี SATA

| ขนาดดิสก์ (ข้อมูลที่ประมวลผล) | 237.9GB |

| ข้อมูลที่อ่านจากแหล่งที่มา | 200.1GB |

| การถ่ายโอนข้อมูลไปยัง Ceph หลังจากการลดความซ้ำซ้อนและการบีบอัด | 69.7GB |

| การลดความซ้ำซ้อน | 1.3 เท่า |

| การบีบอัด | 2.7 เท่า |

ตารางที่ 2.

|

การสำรองข้อมูล เก็บข้อมูลสำรอง |

ระยะเวลา (วินาที) |

แหล่งที่มา (%) |

พร็อกซี (%) |

เครือข่าย (%) |

เป้าหมาย (%) |

การประมวลผล อัตรา (MB/s) |

เฉลี่ย การเขียนข้อมูล อัตรา (MB/s) |

|

เครื่องเสมือน Linux RBD สำเนา 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

เครื่องเสมือน Linux CephFS สำเนา 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

เครื่องเสมือน Linux RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

เครื่องเสมือน Linux CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

เซิร์ฟเวอร์ลินุกซ์, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

หมายเหตุ: อัตราการเขียนข้อมูลเฉลี่ยคำนวณโดยการนำข้อมูลที่ถูกถ่ายโอนหารด้วยระยะเวลา อัตราเหล่านี้แสดงการทำงานของกลุ่ม Ceph ในงานสำรองข้อมูลเหล่านี้

(2)สำรองข้อมูลเครื่องเสมือน Windows 10 บน Hyper-V บน HDD

ในการทดสอบนี้เราสำรองข้อมูล Hyper-V ที่เก็บอยู่บนฮาร์ดดิสก์ SATA อัตราการประมวลผลของงานเหล่านี้ถึงขีดจำกัดสูงสุดของแบนด์วิดท์ของ HDD เรายังสามารถหาจุดขวางได้ที่แหล่งที่มาเพราะโหลดของพวกเขาเต็มระหว่าง 99% ของระยะเวลาการทำงาน คลัสเตอร์ Ceph, เป้าหมาย, ภารกิจงานที่มาจากงานสำรองข้อมูล Veeam นั้นเบา คลัสเตอร์ Ceph ยังไม่ได้ทำงานหนักมากนัก ใช้เวลาทำงานเพียง 6% ถึง 1% เท่านั้น

เมื่อเปรียบเทียบกับเบนช์มาร์กก่อนหน้านี้ อัตราการประมวลผลของการสำรองข้อมูลเครื่องเสมือนจริง (VM) ต่ำกว่าการสำรองข้อมูล SSD อย่างมากสาเหตุหลักคือข้อมูล VM ถูกเก็บไว้ในฮาร์ดไดร์ฟ

ตารางที่ 3.

| ขนาดดิสก์ (ฮาร์ดดิสก์) | 127GB |

| ข้อมูลที่อ่านจากแหล่งที่มา | 37.9GB |

| ข้อมูลถูกส่งไปยัง Ceph หลังจาก การลดขนาดและการบีบอัด | 21.4GB |

| การลดความซ้ำซ้อน | 3.3X |

| การบีบอัด | 1.8X |

ตาราง 4. สำรองรูปภาพเครื่องเสมือนบนฮาร์ดดิสก์ SATA3

|

การสำรองข้อมูล เก็บข้อมูลสำรอง |

ระยะเวลา (วินาที) |

แหล่งที่มา (%) |

พร็อกซี (%) |

เครือข่าย (%) |

เป้าหมาย (%) |

การประมวลผล อัตรา (MB/s) |

เฉลี่ย การเขียนข้อมูล อัตรา (MB/s) |

|

เครื่องเสมือน Linux รายการ RBD, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

เครื่องเสมือน Linux โซลูชัน CephFS, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

เซิร์ฟเวอร์ลินุกซ์, รายการ RBD, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

หมายเหตุ: อัตราการเขียนข้อมูลเฉลี่ยคำนวณโดยการนำข้อมูลที่ถูกถ่ายโอนหารด้วยระยะเวลา อัตราเหล่านี้แสดงการทำงานของกลุ่ม Ceph ในงานสำรองข้อมูลเหล่านี้

(3)สำรองข้อมูลเครื่องเสมือนบน ESXi บนฮาร์ดดิสก์

การทดสอบนี้สำรองข้อมูลเครื่องเสมือน CentOS 7 และ Windows 10 ที่ทำงานบนเครื่องเสมือนของ VMWare ESXi 6.5 บนฮาร์ดดิสก์ของเครื่องเซิร์ฟเวอร์ ไปยังที่เก็บข้อมูลที่สนับสนุนโดย Ceph RBD ด้วยการป้องกันรหัสการลบข้อมูล 4+2

ตารางที่ 5.

| แหล่งที่มา | เครื่องเสมือน CentOS | เครื่องเสมือน Windows 10 |

| ขนาดดิสก์ (ฮาร์ดดิสก์) | 40GB | 32GB |

| ข้อมูลที่อ่านจากแหล่งที่มา | 1.8GB | 12.9GB |

| ข้อมูลถูกส่งไปยัง Ceph หลังจาก การลดขนาดและการบีบอัด | 966MB | 7.7GB |

| การลดความซ้ำซ้อน | 22.1X | 2.5X |

| การบีบอัด | 1.9X | 1.7X |

ตารางที่ 6.

|

การสำรองข้อมูล แหล่งที่มา |

ระยะเวลา (วินาที) |

แหล่งที่มา (%) |

พร็อกซี (%) |

เครือข่าย (%) |

เป้าหมาย (%) |

การประมวลผล อัตรา (MB/s) |

เฉลี่ย การเขียนข้อมูล อัตรา (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

หมายเหตุ: อัตราการเขียนข้อมูลเฉลี่ยคำนวณโดยการนำข้อมูลที่ถูกถ่ายโอนหารด้วยระยะเวลา อัตราเหล่านี้แสดงการทำงานของกลุ่ม Ceph ในงานสำรองข้อมูลเหล่านี้

สรุปผล

ตามผลการทดสอบ Ceph RBD และ CephFS มีประสิทธิภาพที่คล้ายกัน นี้ตรงกับประสบการณ์ของเราเกี่ยวกับมาตรฐานการทดสอบประสิทธิภาพของ RBD และ CephFS เมื่อเปรียบเทียบลักษณะของ CephFS และ RBD พวกเขามีข้อดีและข้อเสียของตัวเอง หากคุณต้องการใช้งานเซิร์ฟเวอร์เก็บข้อมูลหลายเครื่อง คุณต้องสร้างภาพ RBD สำหรับแต่ละเซิร์ฟเวอร์เก็บข้อมูลสำรอง เนื่องจากคุณสามารถแม่นยำเชื่อมต่อ Ceph RBD ได้เพียงเครื่องเดียว เมื่อเปรียบเทียบกับ CephFS การใช้ RBD ง่ายกว่าเนื่องจากไม่ต้องใช้เซิร์ฟเวอร์ข้อมูล เราต้องกำหนดขนาดความจุของ RBD เมื่อสร้าง ดังนั้นคุณต้องปรับขนาดความจุเมื่อคุณต้องการพื้นที่เพิ่มเติม

หากคุณใช้ CephFS เป็นเครื่องเก็บข้อมูล คุณจะต้องติดตั้งเซิร์ฟเวอร์ข้อมูลเมตาดาต้า (MDS) อย่างน้อยหนึ่งเครื่องในกลุ่ม Ceph นอกจากนี้เรายังต้องการเซิร์ฟเวอร์ข้อมูลเมตาดาต้าสำรองเพื่อให้มีความพร้อมใช้งานสูง ต่างจาก Ceph RBD คุณไม่ต้องกำหนดโควต้าให้ระบบไฟล์ ดังนั้นคุณสามารถใช้ CephFS เป็นพื้นที่จัดเก็บข้อมูลได้โดยไม่จำกัด

ในการสาธิตใช้งานนี้ เราทดสอบการสำรองข้อมูลเพียงเครื่องเดียวในแต่ละงานสำรองข้อมูล จากรายงานการทดสอบด้านบน เราทราบว่าอัตราการเขียนข้อมูลเฉลี่ยเกี่ยวข้องกับอัตราการประมวลผลและประสิทธิภาพในการลดข้อมูลและการบีบอัดข้อมูล ดิสก์ต้นทางที่เร็วกว่าจะลดระยะเวลางานสำรองข้อมูลและทำให้มีอัตราการประมวลผลที่เร็วขึ้น ขึ้นอยู่กับโครงสร้างพื้นฐานของผู้ใช้ ผู้ใช้สามารถติดตั้งงานพร้อมกันหลายงานเพื่อสำรองข้อมูลวัตถุต่าง ๆ พร้อมกัน การจัดเก็บข้อมูล Ceph ทำงานได้ดีมากในการสนับสนุนงานพร้อมกันหลายงาน

คลัสเตอร์ Ceph 20x HDD OSD ที่มีพลังงานจาก 3x Ambedded Mars 400 สามารถให้ประสิทธิภาพการเขียนรวมสูงสุดถึง 700MB/s สำหรับพูลรหัสการลบข้อมูล 4+2 การใช้งานงานสำรองข้อมูลหลายงานพร้อมกันจะลดระยะเวลาสำรองข้อมูลทั้งหมด ประสิทธิภาพสูงสุดของคลัสเตอร์ Ceph เกือบสัมพันธ์กับจำนวนฮาร์ดดิสก์ในคลัสเตอร์

ในกรณีการใช้งานนี้ เราไม่ได้ทดสอบการใช้ S3 object storage เป็นที่เก็บข้อมูลสำรอง อย่างไรก็ตาม S3 object storage สามารถใช้เป็นชั้นความจุใน Veeam Scale-Out backup repository และเป็นที่เก็บข้อมูลสำรองสำหรับ NAS คุณสามารถตั้งค่า RADOS gateway และสร้างผู้ใช้งาน object storage ได้อย่างง่ายดายโดยใช้ Ambedded UVS manager ซึ่งเป็นเว็บ GUI สำหรับการจัดการ ceph

- ดาวน์โหลด

ใช้ Ceph เป็นที่เก็บสำหรับเอกสารขาว Veeam Backup & Replication

วิธีตั้งค่าอุปกรณ์บล็อก Ceph RBD และระบบไฟล์ CephFS เป็นที่เก็บข้อมูลสำรองของ...

ดาวน์โหลด- ผลิตภัณฑ์ที่เกี่ยวข้อง

อุปกรณ์จัดเก็บข้อมูล Mars 400PRO Ceph

Mars 400PRO

Mars 400 Ceph Appliance ถูกออกแบบมาเพื่อตอบสนองความต้องการในการจัดเก็บข้อมูลแบบคลาวด์ที่มีความจุสูง...

รายละเอียด