Ceph 캐시 계층은 어떻게 작동하나요?

소개:

이 게시물에서는 NVMe 풀에 의해 지원되는 캐시 계층을 설정하여 Ceph 캐시 계층이 HDD 풀의 성능을 어떻게 향상시킬 수 있는지를 보여주는 벤치마크 테스트를 공유합니다.

Ceph 캐시 티어란 무엇이며 어떻게 작동합니까?

Ceph 캐시 티어는 더 느린 저장 장치의 캐시로 더 빠른 저장 장치를 사용할 수 있게 합니다. 이는 빠른/비싼 저장 장치 (예: NVMe SSD)로 구성된 캐시 계층으로 작동하도록 구성된 저장 장치 풀을 생성하고, 이를 경제적인 저장 계층으로 작동하도록 구성된 이레이저 코드 또는 느린 장치 (예: HDD)의 뒷받침 풀로 구성하는 것을 포함합니다. 캐시 계층은 백업 계층에서 자주 액세스되는 데이터를 저장하고 클라이언트로부터 읽기 및 쓰기 요청을 처리합니다. 캐시 티어링 에이전트는 일정한 정책에 따라 캐시 티어에서 주기적으로 객체를 플러시하거나 제거합니다.

Ceph 캐시 티어 데모

과거에는 캐시 티어 저장 장치로 SATA SSD를 사용할 때 캐시 티어링을 사용하여 성능 향상이 미미했습니다. 하지만 최근 몇 년 동안 NVMe SSD의 가격이 많이 하락하였고, NVMe SSD의 성능은 HDD보다 훨씬 빠릅니다. HDD 풀에 NVMe SSD를 캐시 티어로 사용하는 것이 큰 도움이 될 수 있는지 알고 싶습니다.

NVMe 캐시 계층의 효능을 테스트하기 위해, 우리는 캐시 계층이 HDD 기반 스토리지 풀의 성능을 향상시키는지 확인하기 위한 테스트를 설정했습니다.

클러스터 설정

| NVME 호스트들 | 3 x Ambedded Mars500 Ceph Appliances |

| 각각의 Mars 500 장비의 사양 | |

| CPU | 1x Ampere Altra Arm 64-Core 3.0 Ghz |

| 메모리 | 96 GiB DDR4 |

| 네트워크 | 2포트 25Gbps Mellanox ConnectX-6 |

| OSD 드라이브들 | 8 x 마이크론 7400 960GB |

| HDD 호스트들 | 3 x Ambedded Mars400 Ceph Appliances |

| 각각의 Mars 400 장치의 사양 | |

| CPU | 8개의 노드, 쿼드-코어 Arm64 1.2 GHz |

| 메모리 | 노드 당 4GiB. 장치 당 32 GiB |

| 네트워크 | 노드 당 2 x 2.5Gbps. 인 채시스 스위치를 통한 2x 10 Gb 업링크. |

| OSD 드라이브들 | 8 x 6 TB Seagate Exos HDD |

Ceph 클러스터 정보

- NVMe SSD에 24 x OSD (3x Ambedded Mars500 장비)

- HDD에 24x OSD (3x Ambedded Mars400 장비)

- HDD 및 NVMe 서버는 분리된 CRUSH 루트에 위치해 있습니다.

테스트 클라이언트

- 물리 서버 2대. 25Gb 네트워크 카드 2개

- 각 서버는 7대의 VM을 실행합니다.

- 각 VM은 4개의 코어와 8GB 메모리를 가지고 있습니다.

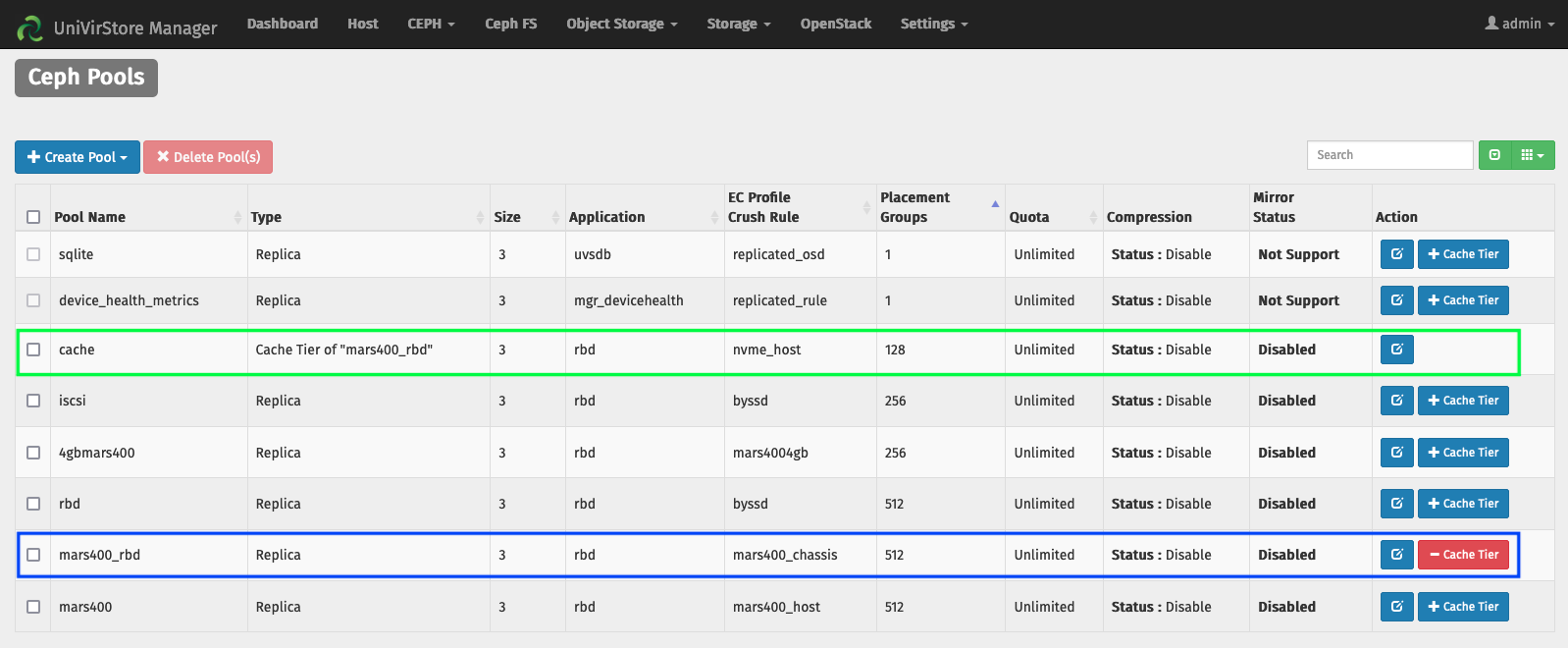

캐시 티어를 Ambedded UVS 매니저로 설정합니다

1. HDD osd를 사용하여 기본 풀을 생성하십시오.

2. NVMe SSD osd를 사용하여 NVMe 풀을 생성합니다.

3. NVMe 풀을 HDD 풀의 캐시 계층으로 추가하십시오.

기본 캐시 계층 구성:

- 캐시 모드: 쓰기 반영

- hit_set_count = 12

- hit_set_period = 14400초 (4시간)

- target_max_byte = 2 테라바이트

- target_max_objects = 100만 개

- min_read_recency_for_promote & min_write_recency_for_promote = 2

- cache_target_dirty_ratio = 0.4

- cache_target_dirty_high_ratio = 0.6

- cache_target_full_ratio = 0.8

- cache_min_flush_age = 600초

- cache_min_evict_age = 1800 초.

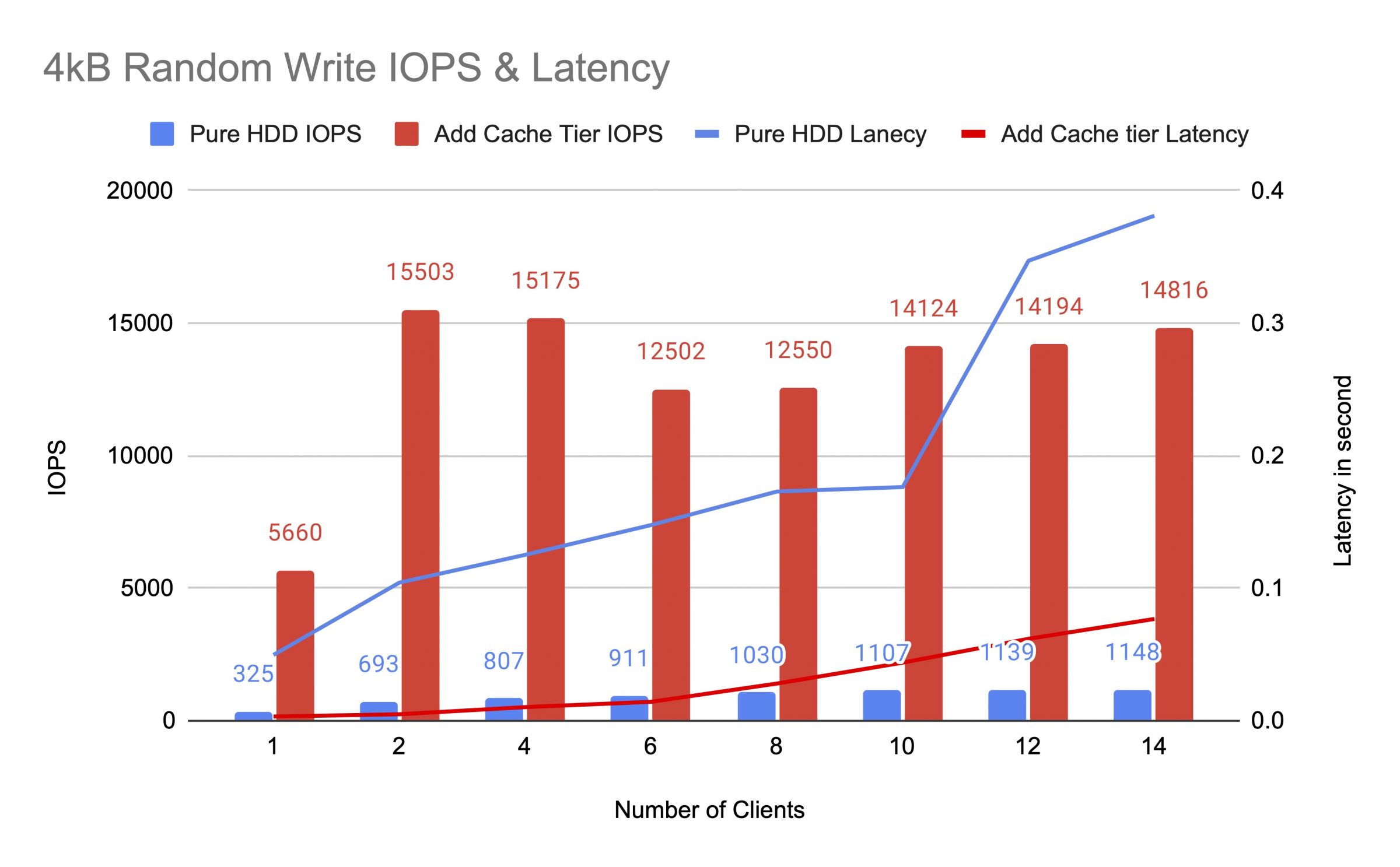

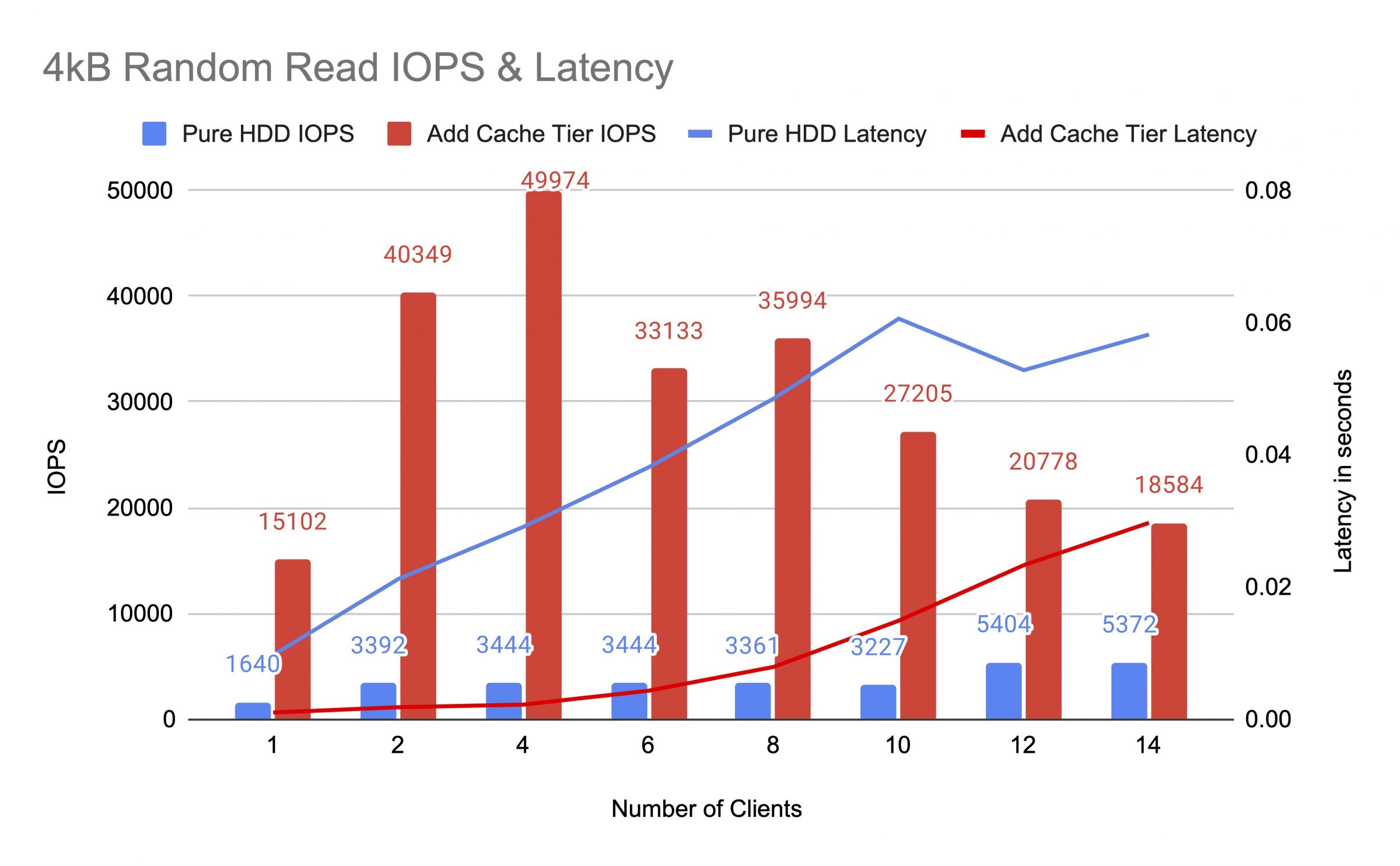

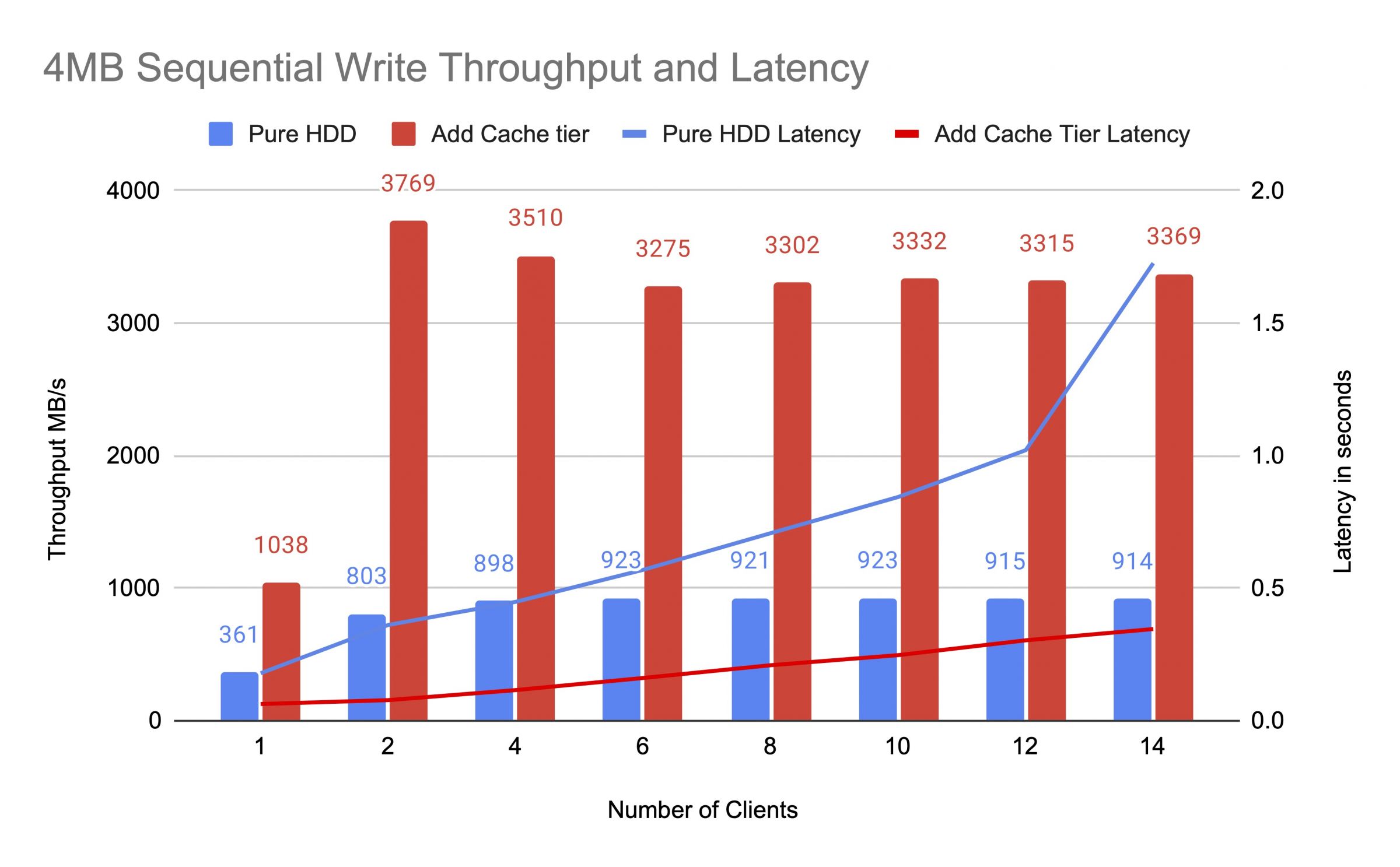

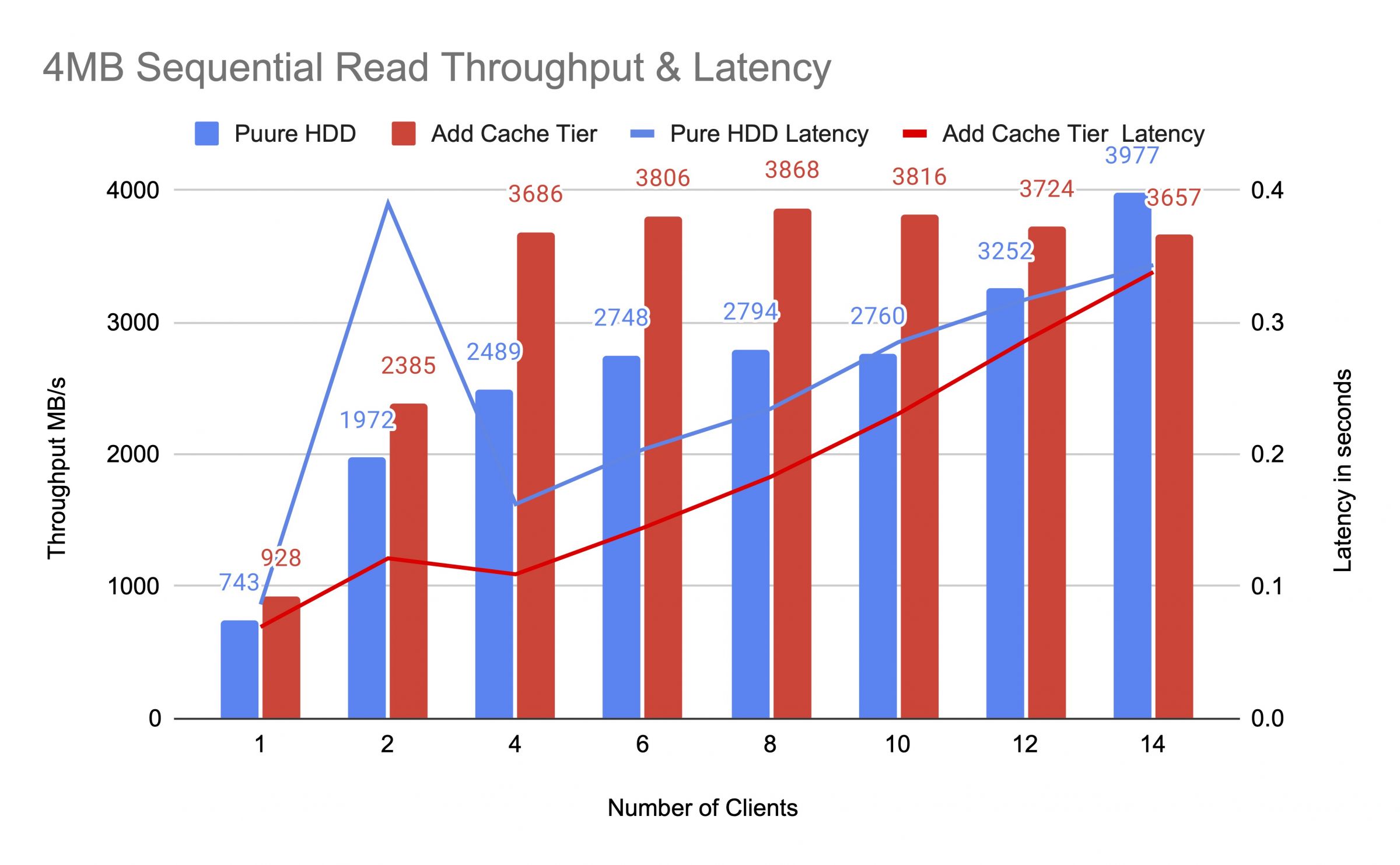

캐시 티어를 추가하기 전과 후에 HDD 풀을 테스트했으며, 최대 14개의 클라이언트를 사용하여 테스트 부하를 생성했습니다. 각 클라이언트는 fio 테스트를 위해 RBD를 마운트했습니다. 테스트 로드는 한 클라이언트로 시작하여 각 테스트 작업이 완료된 후 클라이언트 수를 증가시켰습니다. 각 테스트 주기는 5분 동안 지속되었으며 Jenkins에 의해 자동으로 제어되었습니다. 테스트 작업의 성능은 모든 클라이언트의 결과의 합이었습니다. 캐시 티어링을 테스트하기 전에, 우리는 RBD에 데이터를 쓰고 캐시 티어 풀이 ceph 캐시 대상 전체 비율 (0.8)을 초과하여 채웠습니다.

다이어그램은 NVMe 캐시 풀을 추가한 후 순수 HDD 풀의 성능이 크게 향상되었음을 보여줍니다.

캐시 계층 테스트 중에 Ceph OSD Pool Stats 명령을 사용하여 풀 통계를 관찰했습니다. 캐시와베이스 풀에는 플러싱, 퇴거 및 홍보 활동이있었습니다. 캐시 계층 테스트 중에 다른 시간에 풀 통계를 캡처했습니다.

데이터가 캐시에 기록되었습니다

풀 캐시 ID 84

클라이언트 IO 21 MiB/s 쓰기, 0 op/s 읽기, 5.49k op/s 쓰기

풀 mars400_rbd ID 86

아무 일도 일어나지 않고 있습니다

캐시가 프로모션과 제거를 수행 중

풀 캐시 ID 84

클라이언트 I/O 42 MiB/s wr, 0 op/s rd, 10.79k op/s wr

캐시 계층 I/O 179 MiB/s 제거, 17 op/s 프로모션

풀 mars400_rbd ID 86

클라이언트 I/O 0 B/s rd, 1.4 MiB/s wr, 18 op/s rd, 358 op/s wr

캐시가 플러싱 중이었습니다

풀 캐시 ID 84

클라이언트 IO 3.2 GiB/s 읽기, 830 op/s 읽기, 0 op/s 쓰기

캐시 계층 IO 238 MiB/s 플러시, 14 op/s 승격, 1 PGs 플러싱

풀 mars400_rbd ID 86

클라이언트 IO 126 MiB/s 읽기, 232 MiB/s 쓰기, 44 op/s 읽기, 57 op/s 쓰기

PG가 제거되고 있습니다

캐시 풀 ID 84

클라이언트 I/O 2.6 GiB/s 읽기, 0 B/s 쓰기, 663 op/s 읽기, 0 op/s 쓰기

캐시 계층 I/O 340 MiB/s 플러시, 2.7 MiB/s 제거, 21 op/s 승격, 1 PG 제거 중 (전체)

풀 mars400_rbd ID 86

클라이언트 I/O 768 MiB/s 읽기, 344 MiB/s 쓰기, 212 op/s 읽기, 86 op/s 쓰기

PG 플러싱 및 클라이언트 IO는 기본 풀로 직접 전송됩니다.(클라이언트가 데이터를 쓰고 있습니다)

풀 캐시 ID 84

클라이언트 IO 0 B/s 쓰기, 0 op/s 읽기, 1 op/s 쓰기

캐시 티어 IO 515 MiB/s 플러시, 7.7 MiB/s 제거, 1 PGs 플러시 중

풀 mars400_rbd ID 86

클라이언트 IO 613 MiB/s 쓰기, 0 op/s 읽기, 153 op/s 쓰기

지속적인 테스트 후, 우리는 클러스터를 몇 시간 동안 쉬게 하고 4 kB 랜덤 쓰기 테스트를 다시 수행했습니다. 우리는 훨씬 더 나은 성능을 얻었습니다. 이는 캐시 공간이 새로운 쓰기를 위해 해제되었기 때문입니다.

이번 테스트를 통해 NVMe 풀을 HDD 풀의 캐시 계층으로 사용하면 상당한 성능 향상을 이룰 수 있다는 것을 확신하게 되었습니다.

캐시 계층의 성능은 보장될 수 없다는 점에 유의해야 합니다. 성능은 그 순간의 캐시 적중 조건에 따라 달라지며, 동일한 구성과 작업 부하로 테스트를 반복해도 동일한 성능을 얻을 수 없습니다.

응용 프로그램이 일관된 성능이 필요하다면 순수 NVMe SSD 풀을 사용하십시오.

- 관련 제품

Mars500 NVME 올 플래시 Ceph 스토리지 장치

화성 500

Mars 500 Ceph Appliance는 고성능 클라우드 네이티브 데이터 저장 요구를 충족하도록 설계되었습니다. 최신 NVMe 플래시...

세부Mars 400PRO Ceph 스토리지 어플라이언스

Mars 400PRO

Mars 400 Ceph Appliance는 고용량 클라우드 네이티브 데이터 저장 요구를 충족하기 위해 설계되었습니다. 저렴한 비용 당 TB를...

세부